내 QLC와 디램리스가 완전 수라장 [P3 Plus 2TB]

Change log

2025.11.29 - DUT Summary의 PN 변경

며칠 전, 커뮤니티 두 곳에는 벤치마크 방법론에 대한 요약본을, 한 곳에는 블로그 링크를 달았습니다. 반응은 생각보다는 좋았습니다. 아무도 관심 없는 채로 쓸쓸하게 사라질 글일 줄 알았거든요.

물론, 이렇게 해도 크게 달라지진 않을 것입니다. 뭐라고 해야 할까요, 큰 기대는 하지 않거든요.

저는 저만의 길을 걷도록 하겠습니다, 이전에 P4800X 리뷰 라이트판을 배포했을 때의 설문조사 결과와 다르게, 쌓인 것부터 쳐내기로 했습니다. 램디스크나 최신 Optane SSD에 대한 벤치마크를 기대하신 분들께는 사죄의 말씀을 드리고 싶습니다.

오늘 준비한 SSD는 Micron, Crucial의 P3 Plus입니다. 근 몇 개월간, 알리 익스프레스를 통해 값싸게 풀린 SSD중 하나죠. 바로 시작합시다.

목차

Appearance

P3 Plus 2TB

P3 Plus 2TB는 M.2 2280, 단면의 폼팩터를 가진 평범한 cSSD입니다. 전면에는 Crucial 브랜드와 제품명의 P3 Plus가 기재되었습니다.

후면에는 제품의 간단한 정보가 들어있습니다. 2,000GB의 용량, PCIe Gen4 x4의 인터페이스, 3.3V 2.5A의 전기적 사양, 초기 FW의 버전인 P9CR40A 등을 확인할 수 있네요.

Internal Components

이 제품은 제가 직접 구매한 것이 아닌, 지인을 통해 대여받은 SSD입니다. 따라서, 물리적으로 스티커를 제거하는 것은 보증이 무효가 되기에 지양했습니다. 직구품이라고는 하셨지만요.

대신, Flash ID를 통해 내부 부품을 추정합니다.

...

Bank00: 0x2c,0xd3,0xc,0x32,0xea,0x30,0x0,0x0 - Micron 176L(N48R) QLC 1024Gb/CE 1024Gb/die

Bank01: 0x2c,0xd3,0xc,0x32,0xea,0x30,0x0,0x0 - Micron 176L(N48R) QLC 1024Gb/CE 1024Gb/die

Bank02: 0x2c,0xd3,0xc,0x32,0xea,0x30,0x0,0x0 - Micron 176L(N48R) QLC 1024Gb/CE 1024Gb/die

Bank03: 0x2c,0xd3,0xc,0x32,0xea,0x30,0x0,0x0 - Micron 176L(N48R) QLC 1024Gb/CE 1024Gb/die

Bank08: 0x2c,0xd3,0xc,0x32,0xea,0x30,0x0,0x0 - Micron 176L(N48R) QLC 1024Gb/CE 1024Gb/die

Bank09: 0x2c,0xd3,0xc,0x32,0xea,0x30,0x0,0x0 - Micron 176L(N48R) QLC 1024Gb/CE 1024Gb/die

Bank10: 0x2c,0xd3,0xc,0x32,0xea,0x30,0x0,0x0 - Micron 176L(N48R) QLC 1024Gb/CE 1024Gb/die

Bank11: 0x2c,0xd3,0xc,0x32,0xea,0x30,0x0,0x0 - Micron 176L(N48R) QLC 1024Gb/CE 1024Gb/die

Bank16: 0x2c,0xd3,0xc,0x32,0xea,0x30,0x0,0x0 - Micron 176L(N48R) QLC 1024Gb/CE 1024Gb/die

Bank17: 0x2c,0xd3,0xc,0x32,0xea,0x30,0x0,0x0 - Micron 176L(N48R) QLC 1024Gb/CE 1024Gb/die

Bank18: 0x2c,0xd3,0xc,0x32,0xea,0x30,0x0,0x0 - Micron 176L(N48R) QLC 1024Gb/CE 1024Gb/die

Bank19: 0x2c,0xd3,0xc,0x32,0xea,0x30,0x0,0x0 - Micron 176L(N48R) QLC 1024Gb/CE 1024Gb/die

Bank24: 0x2c,0xd3,0xc,0x32,0xea,0x30,0x0,0x0 - Micron 176L(N48R) QLC 1024Gb/CE 1024Gb/die

Bank25: 0x2c,0xd3,0xc,0x32,0xea,0x30,0x0,0x0 - Micron 176L(N48R) QLC 1024Gb/CE 1024Gb/die

Bank26: 0x2c,0xd3,0xc,0x32,0xea,0x30,0x0,0x0 - Micron 176L(N48R) QLC 1024Gb/CE 1024Gb/die

Bank27: 0x2c,0xd3,0xc,0x32,0xea,0x30,0x0,0x0 - Micron 176L(N48R) QLC 1024Gb/CE 1024Gb/die

Controller : PS5021-E21

CPU Clk : 1000

...

컨트롤러는 PS5021-E21을 사용합니다. 흔히 Phison E21T라고 불리며, PCIe 4.0 x4 인터페이스를 지원합니다. ARM Cortex-R5를 사용한 단일 코어, 1GHz의 디자인이며 TSMC 12nm 공정이 이용되었습니다. Phison의 4세대 LDPC 엔진에 4CH 4CE 구성, NAND I/O 속도는 1,600MT/s 정도로 소개하면 충분하겠죠.

저장매체는 Micron G5 176L QLC 1024Gb를 사용했습니다. 4개의 1024Gb Die가 패키징 된 4개의 512GB의 칩이 장치의 2TB를 구현하는 것을 볼 수 있습니다. 큰 관심은 없지만, 저는 1TB 제품까지 TLC와 QLC가 공존하고, 2TB 이상은 전량 QLC인 것으로 알고 있습니다.

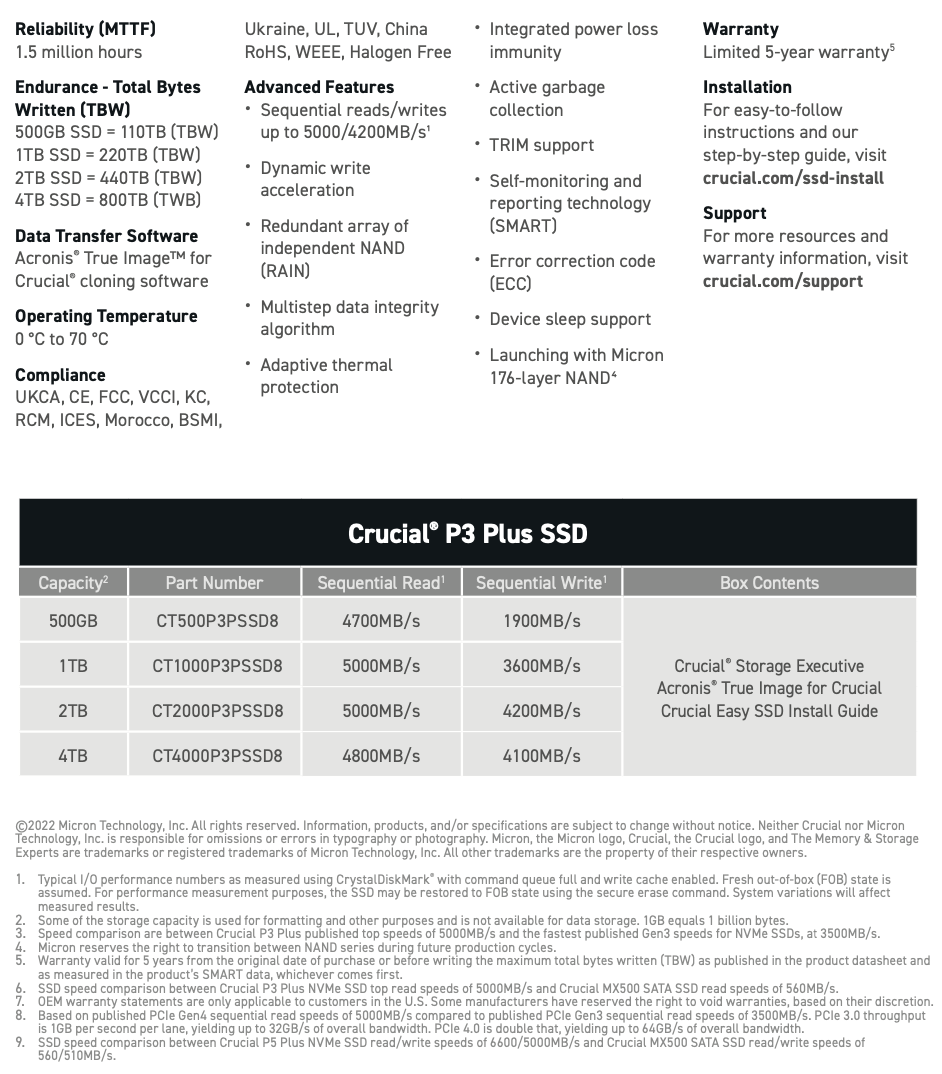

Datasheet

스펙 시트는 좀 허술하네요. 일반적으로 스펙 시트에서 확인하는 정보 중에선 순차 속도와 TBW를 확인할 수 있습니다. 2TB 제품의 보증 TBW가 440TB면 나름 낮은 편이네요. 그럼에도 5년 보증을 명시합니다. 대부분은 직구품일 것 같지만요.

Notable Points

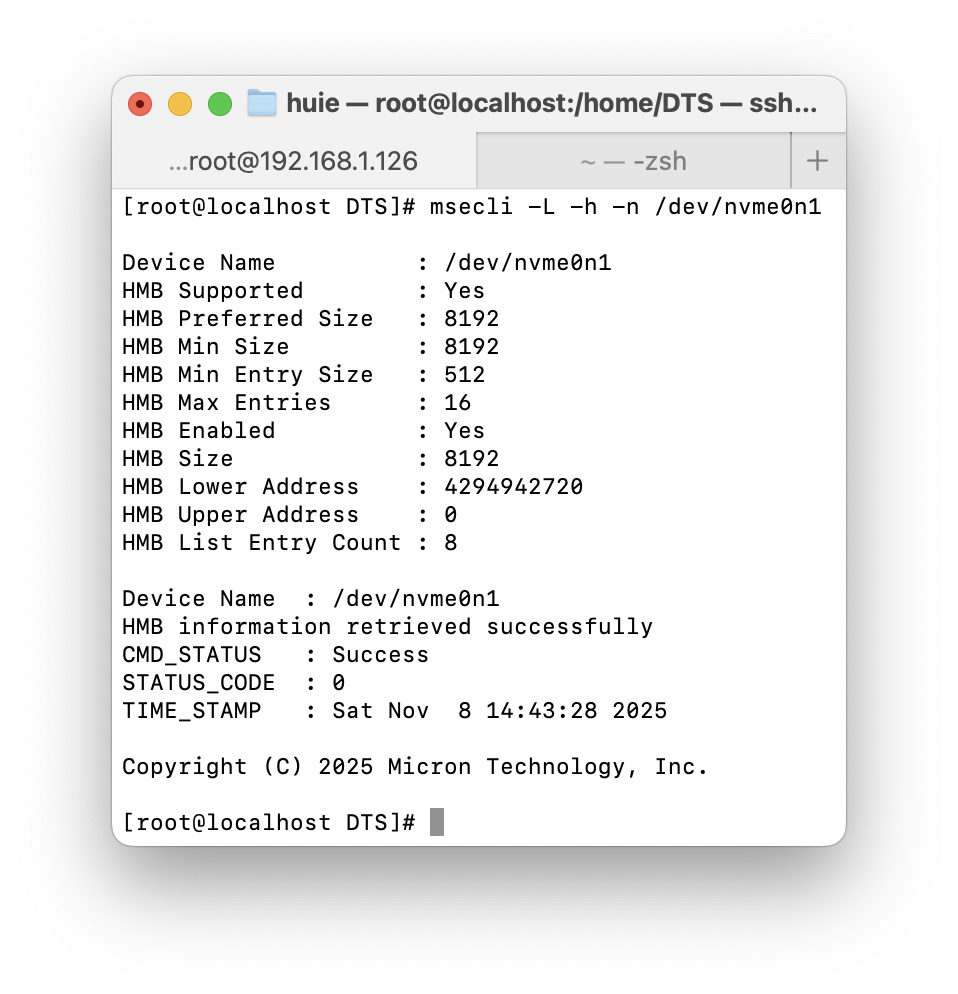

HMB (Host Memory Buffer)

DRAM은 실장되지 않았지만, HMB(Host Memory Buffer) 기능은 지원합니다. Linux의 msecli로 확인한 결과, HMB Size : 8192임을 확인할 수 있습니다. 이는 Micron 만의 기능은 아니며, NVMe 사양대로 구현했다면, nvme get-feature 명령어를 통해 얻을 수 있는 결과이기도 합니다.

NVMe 표준 사양에 의하면 이 HMB Size는 곧바로 용량을 나타내는 것이 아닌, memory page size units를 통해 계산할 수 있습니다. 일반적으로 이는 4kiB이기에 8192를 곱해주면, 32MiB가 HMB로 할당되었다고 할 수 있겠습니다.

사실, dmesg로 더 간단하게 확인할 수 있습니다. 찍어놓은 이미지가 없으니, 다른 리뷰에서 보여드릴게요.

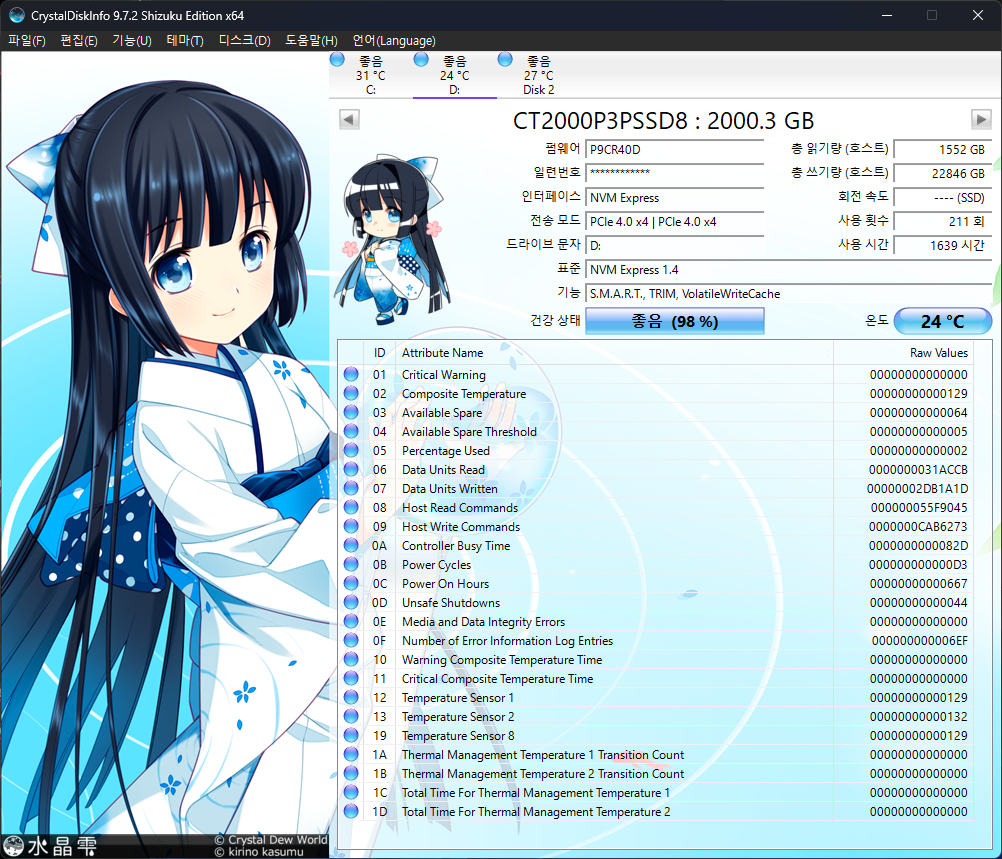

SW Report

CDI의 스크린샷입니다. 처음엔 RW의 값이 각각 977GB / 3.32TB 였는데, 벤치마크를 조금 수행하니 1.5TB / 23TB로 변해버렸습니다. 건강 상태도 100%에서 98%로...

smartmontools와 NVMe-CLI의 id-ctrl 결과는 GitHub에 첨부하도록 하겠습니다.

DUT Summary

벤치마크를 진행할 DUT에 관한 요약입니다.

MICRON CT2000P3PSSD8 [Crucial P3 Plus] | |||

| Link | PCIe 4.0 x4 | NVMe Version | NVMe 1.4 |

| Firmware | P9CR40D | LBA Size | 512B / 4096B |

| Controller | Phison E21T | Warning Temp | 85 °C |

| Storage Media | Micron G5 QLC | Critical Temp | 95 °C |

| Power State | Maximum Power | Entry Latency | Exit Latency |

| PS0 | 6.00 W | 0 μs | 0 μs |

| PS1 | 3.00 W | 0 μs | 0 μs |

| PS2 | 1.50 W | 0 μs | 0 μs |

| PS3 | 0.0250 W | 5000 μs | 1900 μs |

| PS4 | 0.0030 W | 13000 μs | 100000 μs |

초기에 제공되는 펌웨어가 업데이트된 것을 확인할 수 있었습니다. Critical Temp도 조금 높게 설정되어 있나요? PS4의 Exit Latency는 0.1s에 달합니다. 좀 늘어지네요.

Comparison Device

비교군은 아래와 같습니다.

| Name | Why? |

| PM981a 256GB [3L1QEXH7] | 마땅한 cSSD가 없어서 꺼내온 친구 |

원래라면 PM9A1을 꺼냈을 텐데, 벤치마크의 환경이 달라졌으니 새로 측정을 수행한 cSSD만 꺼냈습니다. 데이터를 쌓기 위해서 노력해야 할 타이밍이네요.

참고로, PM9E1은 너무 압도적이라 제외했습니다.

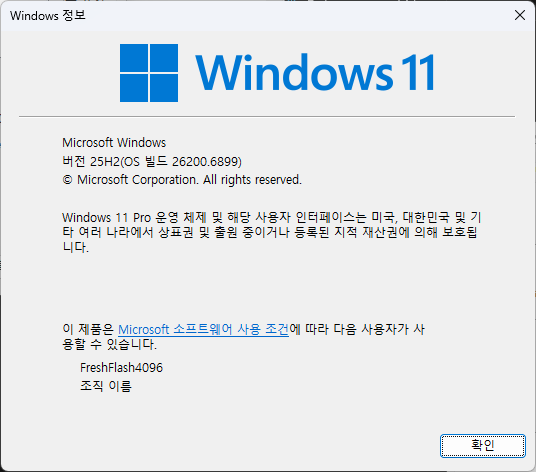

Test Platform

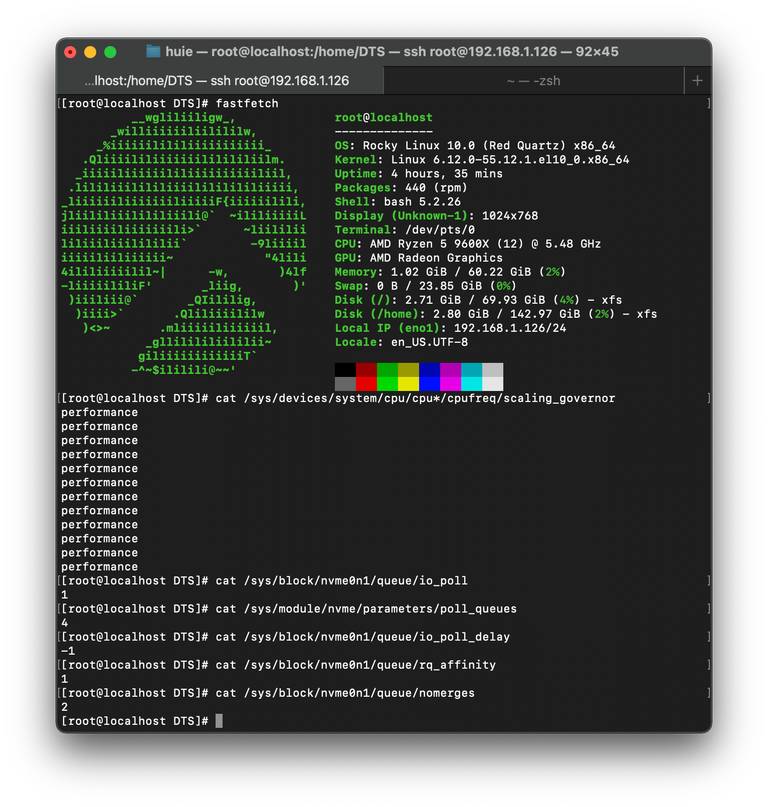

테스트 환경은 위와 같습니다. Windows 25H2(26200.6899)에 종속되는 도구들을 제외하고는 모두 FIO 3.41을 통해 Rocky Linux 10(6.12.0-55.12.1.el10_0)에서 실행되며, io_uring과 Polling을 적극적으로 활용합니다. 또한, 양쪽 다 기본 Inbox Driver를 사용합니다.

HW 사양에 대해서는 상단 우측의 fastfetch를 통해서 확인할 수 있지만, 다시 언급하자면, AMD의 9600X를 사용하고 있습니다. DUT는 5.0 x16 연결이 가능한 PEG 슬롯에 장착됩니다.

자세한 벤치마크 방법론에 대해서는 이전에 작성한 Refresh Benchmark를 참고해 주시길 바랍니다.

cSSD Benchmarking

start /wait Rundll32.exe advapi32.dll/ProcessIdleTasks Windows에서는 위의 명령어를 실행하고 15분 뒤를 IDLE 상태로 정의해 벤치마크를 진행합니다. 각 벤치마크 사이에는 5분의 휴식 시간이 부여되며, Purge는 Linux에서 nvme format 명령어를 통해 수행했습니다.

CrystalDiskMark 9.0.1

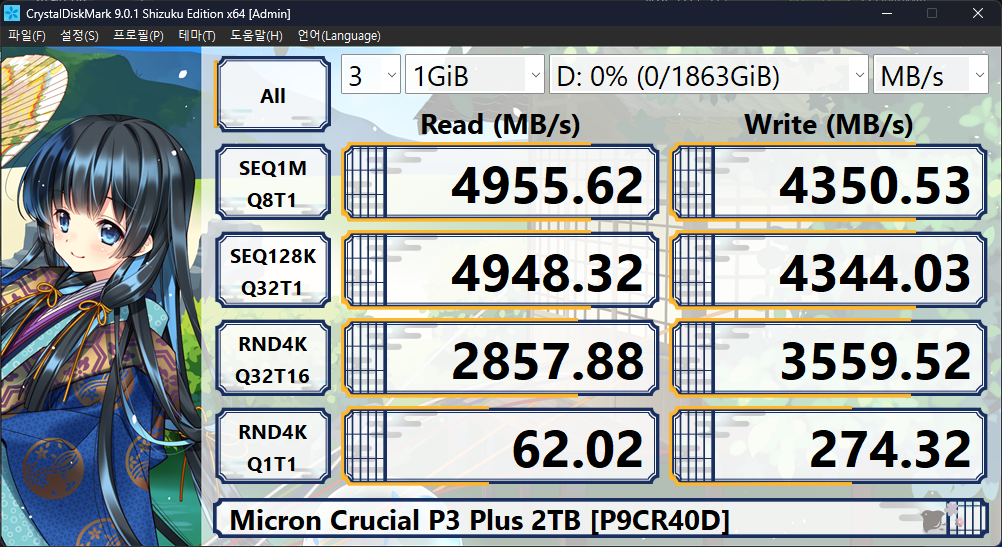

Windows에서 인식하는 용량은 1,863GiB임을 확인할 수 있습니다.

스펙 시트는 순차 읽쓰기를 5,000/4,200 MB/s로 보고하였지만, 읽기 성능이 아슬아슬 미달하는 것을 확인했습니다. 오차라고 하고 넘어가 줄까요?

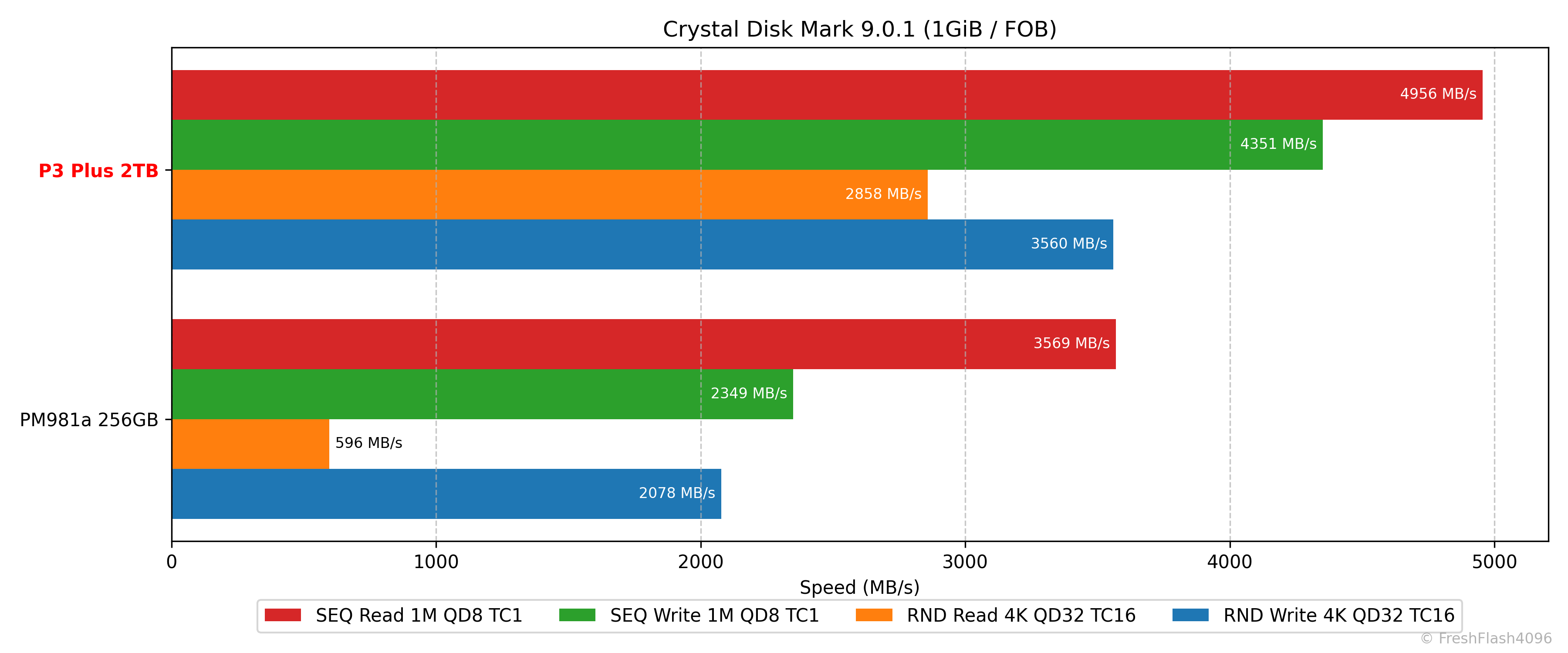

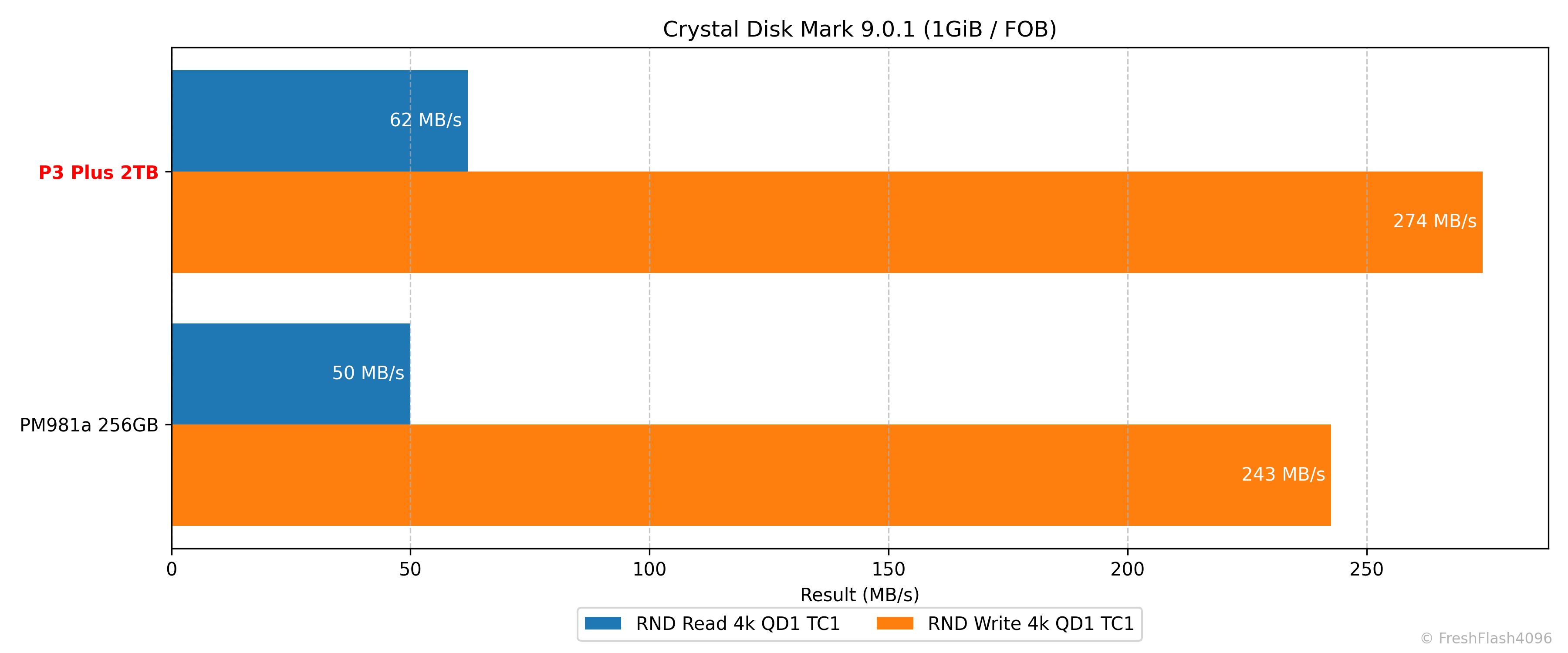

Die의 개수도 우위, 인터페이스도 우위. 컨트롤러는 DRAMless 구조에 4채널이지만, 단기간의 Burst 성능에서는 PM981a에 질 이유가 없습니다. 실제로 모든 케이스에서 우세한 모습을 보입니다.

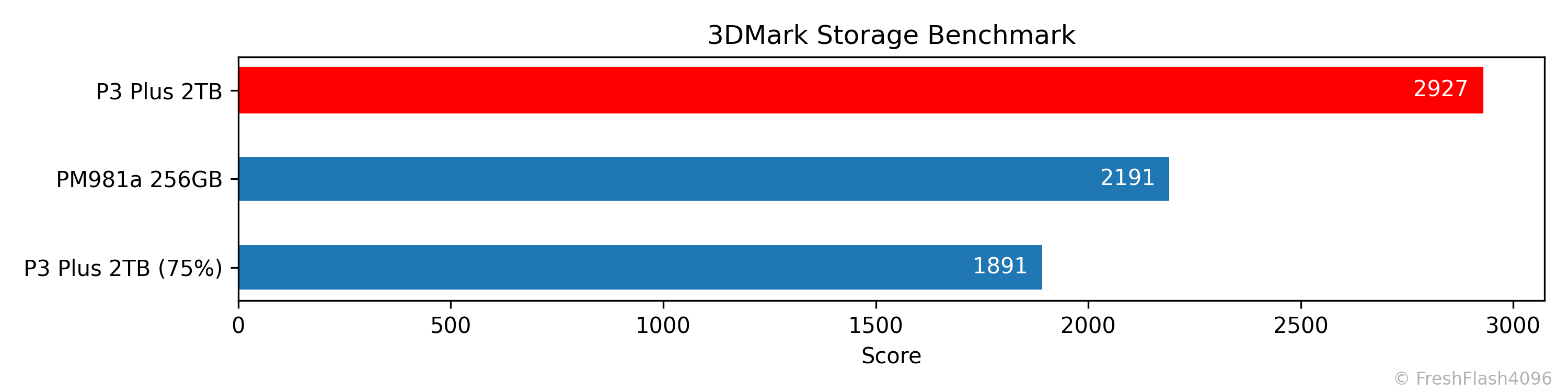

3DMark Storage Benchmark

3DMark에서는 용량이 채워진 정도에 따라 점수의 차이가 발생하는 것을 확인했습니다. PM981a 256GB는 이런 현상이 발생하지 않았으며, 동일하게 75%가 채워진 상태에서는 P3 Plus가 더 낮은 점수를 받았습니다.

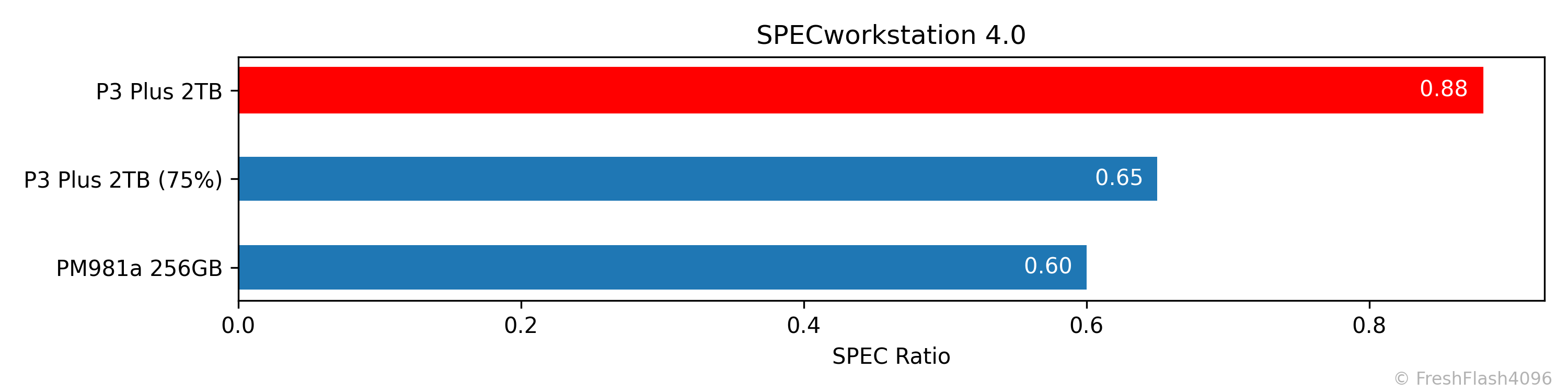

SPECworkstation 4.0

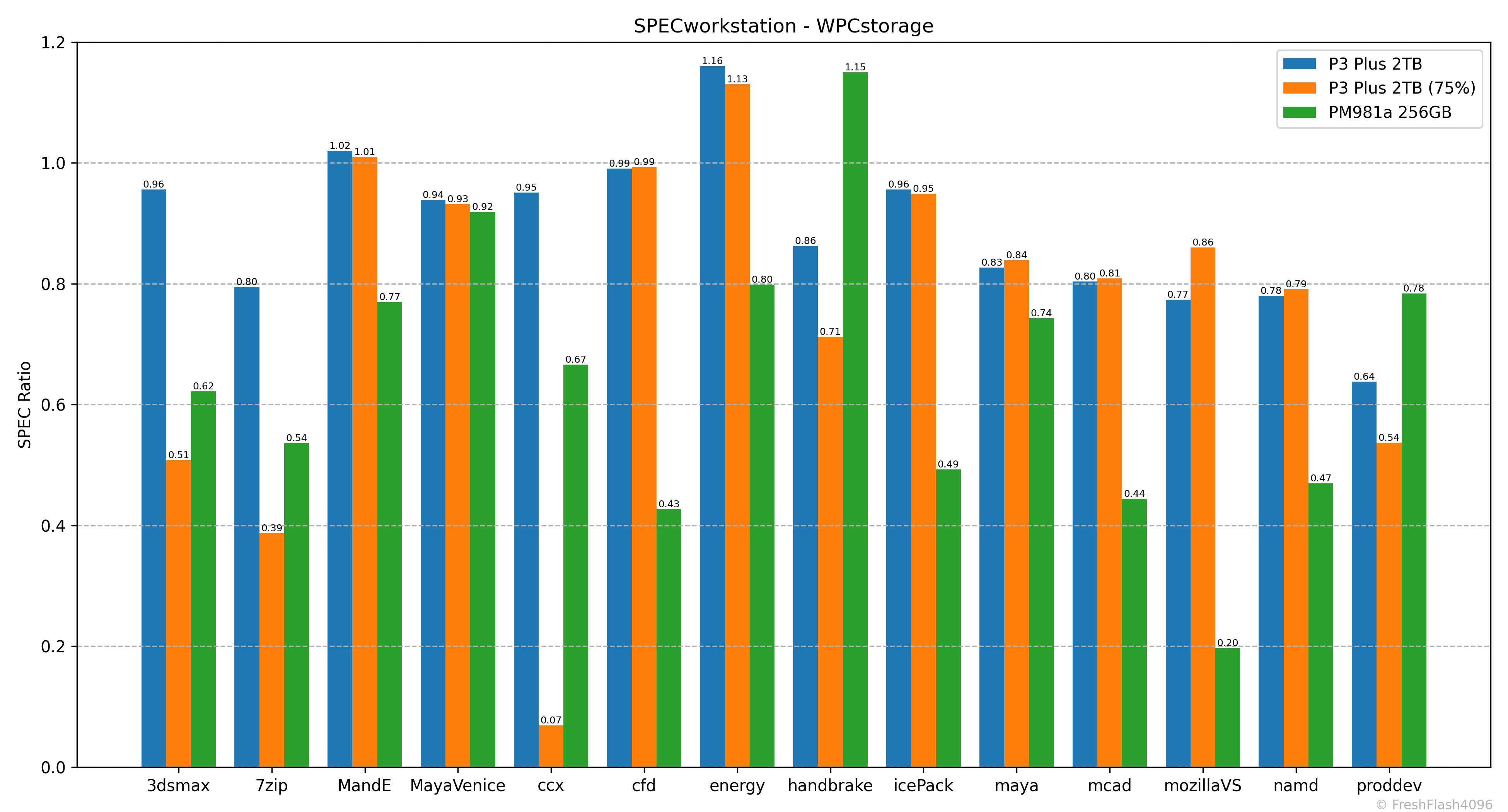

SPECworkstation에서는 3DMark와 조금 다른 모습을 보였습니다. 75%가 채워지더라도 PM981a 256GB보다 우세한 모습을 보였습니다. 뭐, 점수가 낮아지는 것은 확실하지만요.

각 워크로드에 대해 자세하게 보면, 용량이 채워져도 큰 성능 하락이 없는 워크로드(MandE, icePack)도 있지만, 급격한 성능저하를 보이는 워크로드(3dsmax, ccx)도 존재했습니다.

물론, PM981a가 가장 우세한 워크로드(handbrake, proddev)도 존재합니다.

재밌는 부분은 일부 워크로드에선 채워진 쪽이 더 우수한 성능을 보였다는 점이겠죠. 이 경향성이 가장 뚜렷한 것은 mozillaVS 워크로드이며, 약 11.7% 우수했습니다. 읽기 집약적인 워크로드라고 생각되는데, 오차라고 볼 수 있을까요?

Fill Drive

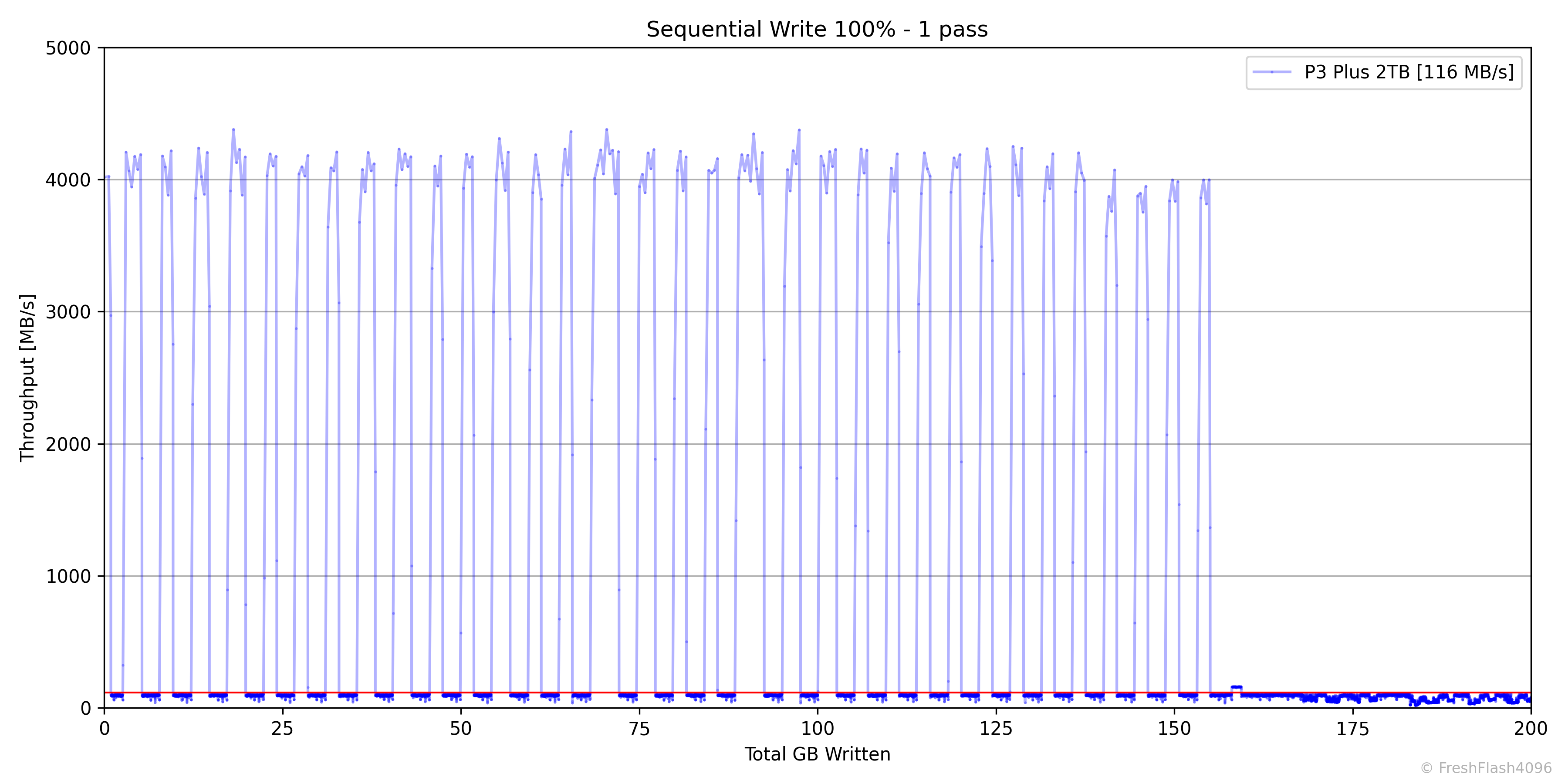

나래온 더티테스트와 비슷한 벤치마크입니다. FOB상태로 시작하여, SEQ 128k QD256으로 드라이브 전체를 2회 채우며, 0.1s 단위로 값을 측정합니다. 1회차와 2회차 사이의 휴식은 충분히 부여됩니다.

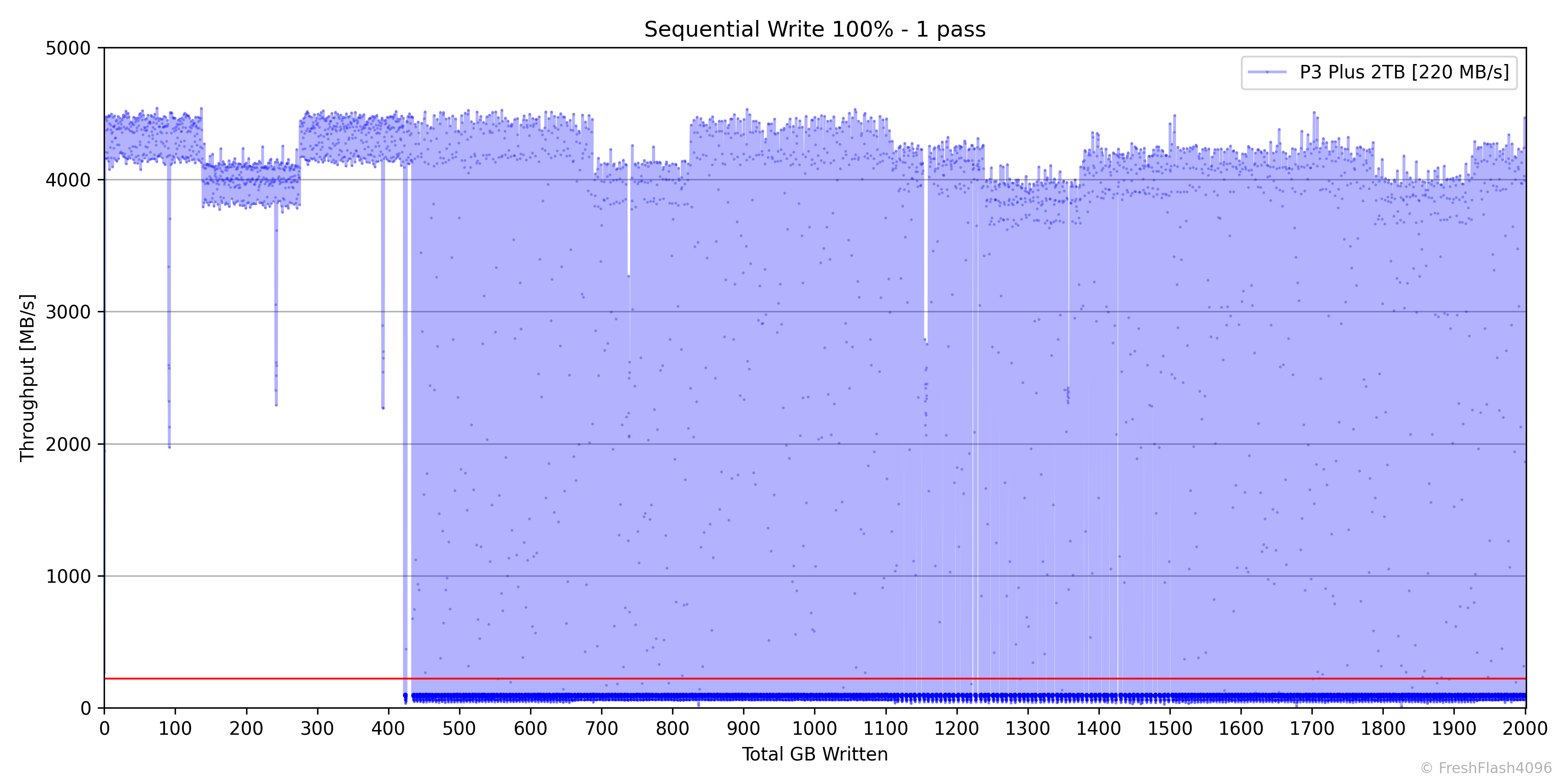

첫 번째 채우기입니다. 전체 평균 속도는 220MB/s이며, 쓰기를 무조건 SLC Cache에 받은 후 QLC로 이동하는 과정을 거치는 것으로 보입니다.

완전한 SLC Cache 부분입니다. 성능은 일관적이지 않으나, 평균적으로 4,181MB/s의 속도를 보여주었습니다. 용량도 400GB 이상으로, 2TB SSD라는 것을 생각하면 꽤 넉넉하게 가지고 있습니다.

드라이브의 상당한 부분을 SLC Cache로 사용하려는 것으로 보입니다.

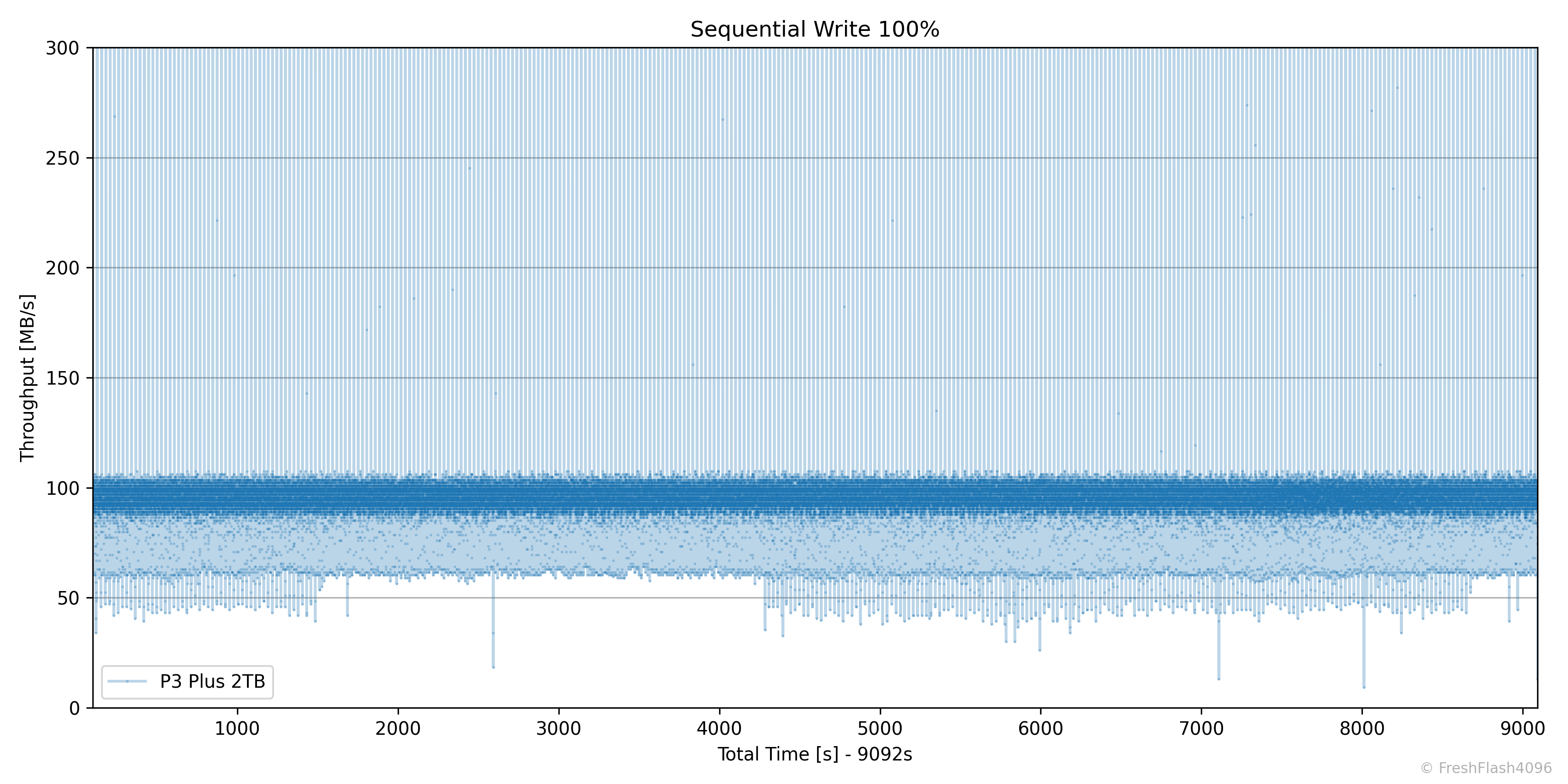

SLC Cache 외부에서 아래쪽을 확대해 보았습니다. 그래프 축의 변화에 주목해 주세요. Y축은 300MB/s로 제한되며, X축은 100초를 시작으로 하는 시간 축으로 변경했습니다.

속도 분포에 따른 중앙값은 다음과 같습니다. 표본 개수는 파악하기 쉽도록 반올림 처리했습니다.

| 75 MB/s ~ 125 MB/s | 95.68 MB/s (표본 85,000개) |

| 50 MB/s ~ 75 MB/s | 61.60 MB/s (표본 2,900개) |

| 0 MB/s ~ 50 MB/s | 44.56 MB/s (표본 350개) |

QLC에 기입되는 속도는 100MB/s 가량으로 보입니다. 그 이하는 SLC Cache에서 QLC로 Flush(Write back, Folding이라고도 하죠?)를 수행하는 것으로 예상되는데, 전 영역에 걸쳐 4,000MB/s 이상의 속도가 종종 보이는 것으로 보아, 계속해서 Flush가 발생하는 것으로 보입니다.

Flush 과정에서는 약 45~60MB/s의 속도가 관찰되었습니다.

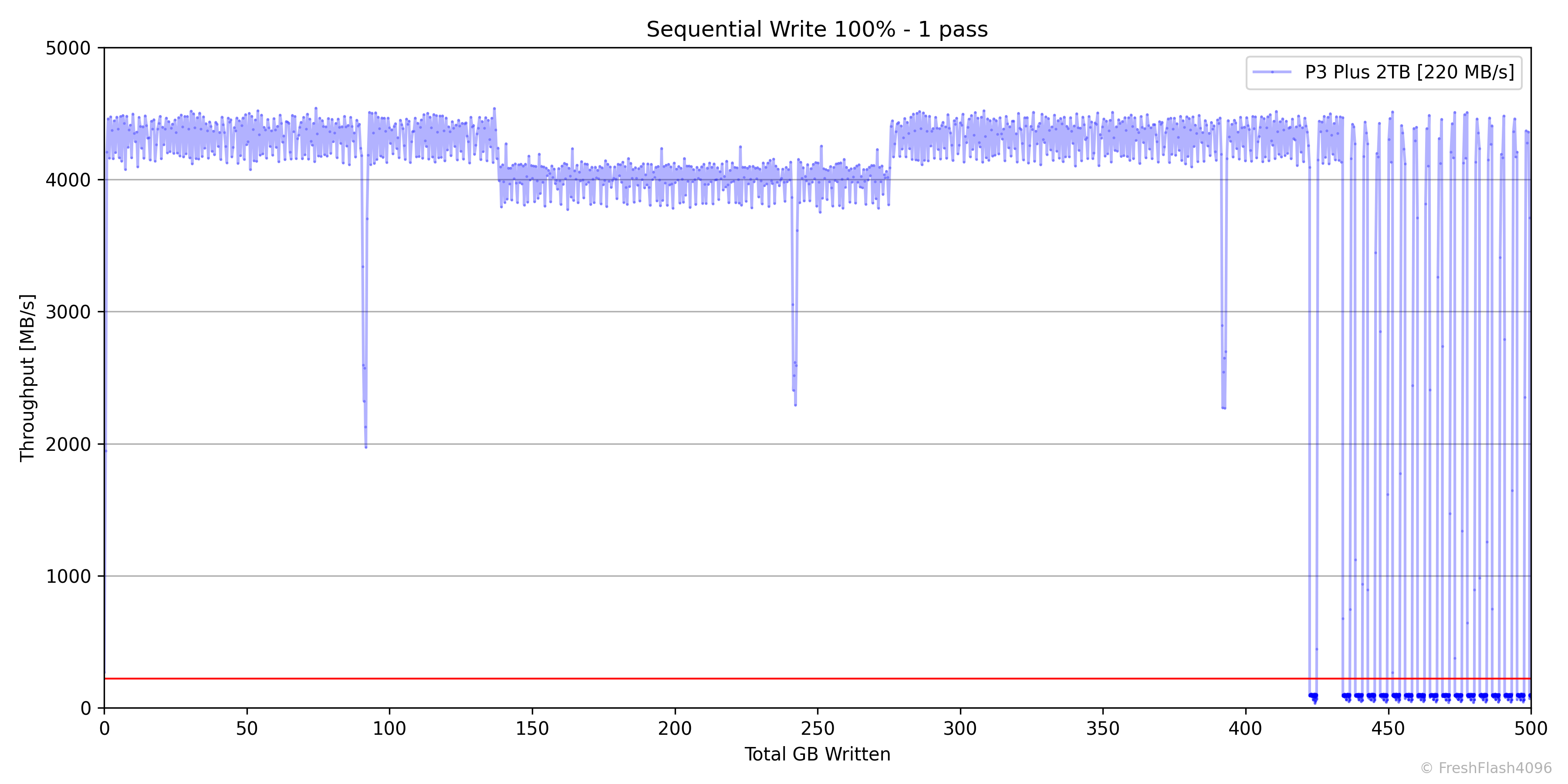

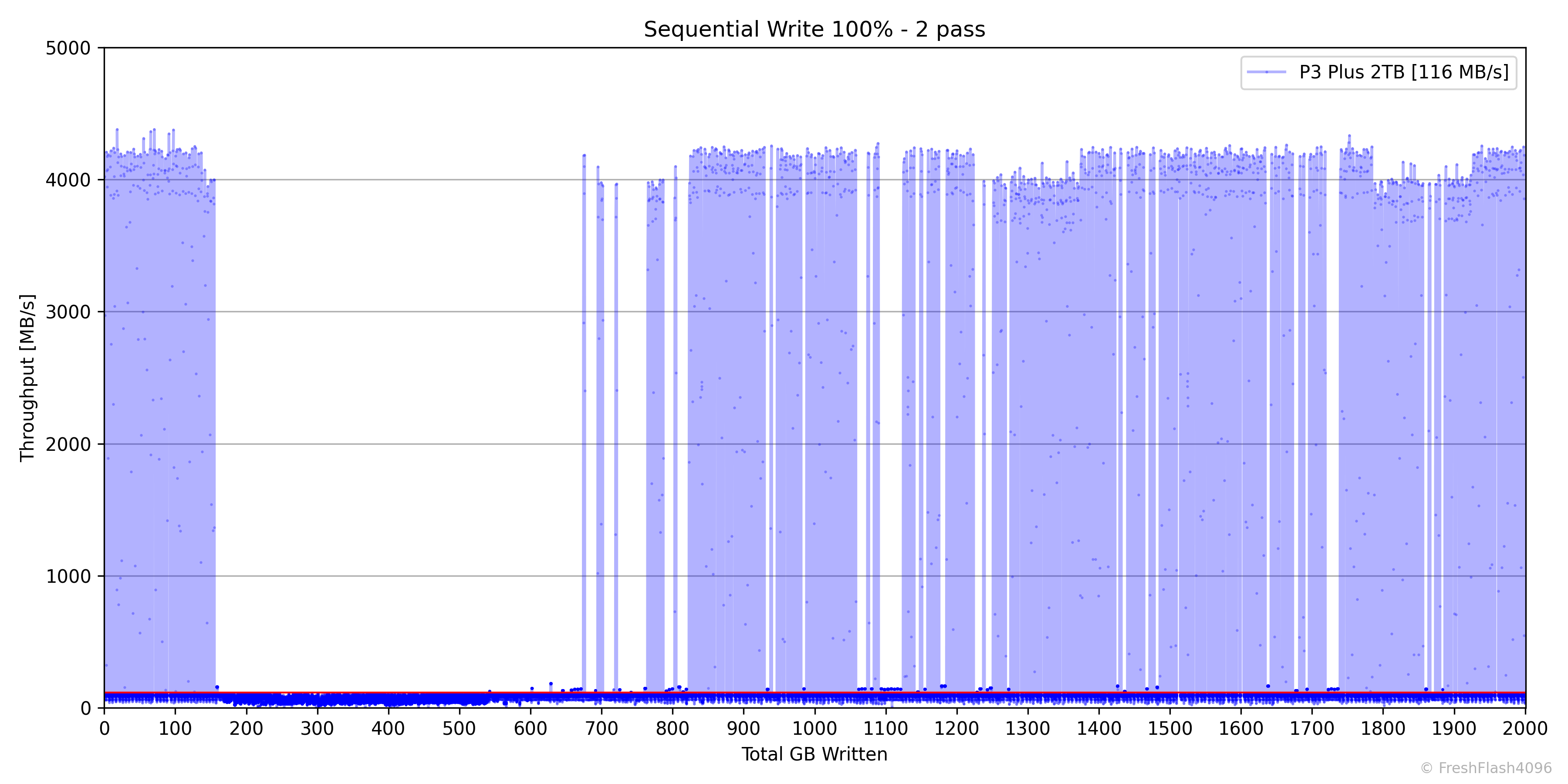

그럼, 휴식을 부여한 뒤, 두 번째 쓰기 작업을 시작합시다. 여긴 이전보다 더 예상치 못한 그래프를 보여주네요.

일단, 이 두 번째 Fill Drive는 소위 말하는 최소의 SLC Cache, Static SLC Cache의 크기를 확인하기 위해서 수행합니다. 그런데, 시작부터 장난 아니네요.

Cache의 크기를 확인하기보다는, 이전 쓰기 작업의 연장선처럼 보입니다. 다른 부분은, 150GB 가량 쓰기가 진행된 이후, 500GB 쓰기가 진행 중일 때는 SLC Cache가 작동하지 않는 것처럼 보이기도 합니다. 아래에서 더 자세히 보시죠.

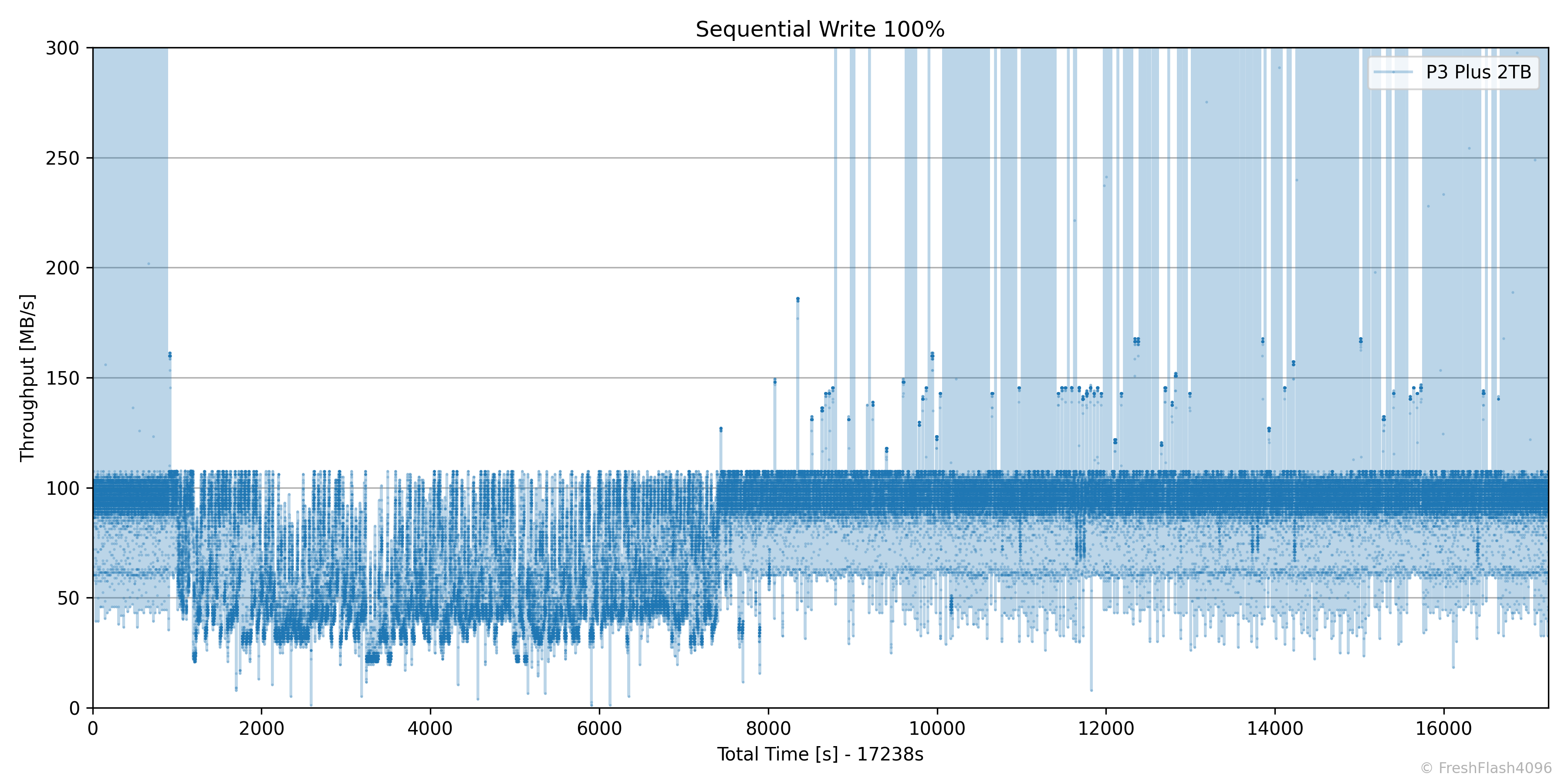

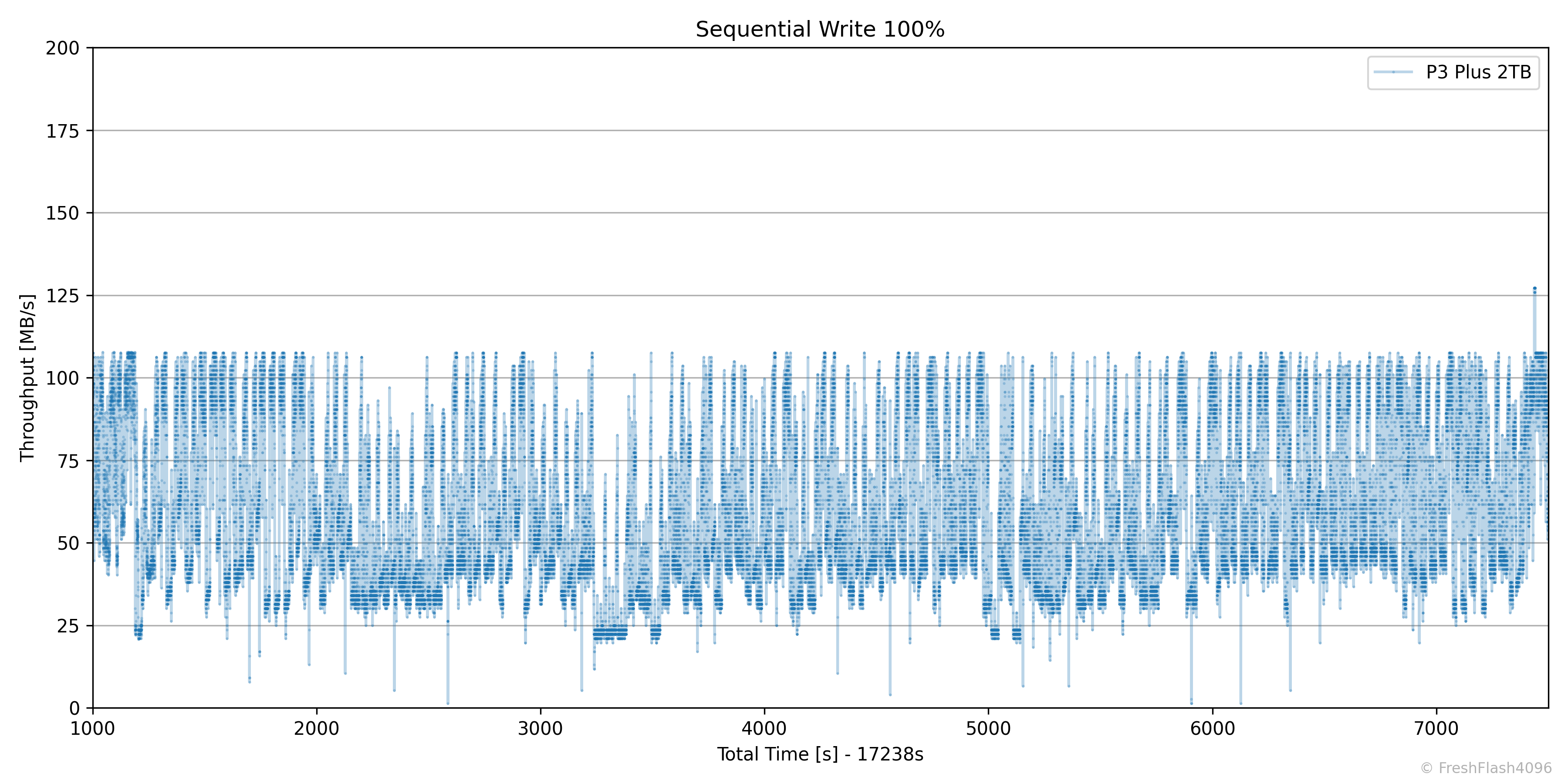

이번에도 최댓값을 제한한 Y축이지만, 시작부터 끝까지 전체 시간을 X축으로 삼았습니다. SLC Cache가 작동하지 않는 것처럼 보이는 부분은 바로 보이겠지만, 1,000~7,500초 가량의 시간대입니다.

징그러울 수 있지만, 더 자세히 보기 위해서 확대해 보았습니다. 최대 상한선이 어느 정도로 정해져 있는 것을 확인할 수 있습니다. 이 구간의 상위 1% 값은 106.17MB/s이며, 첫 번째 Fill Drive에서 중앙값으로 확인한 값과 유사성이 있을 것입니다. QLC 쓰기 속도겠죠.

다만, 아래 쪽의 불규칙한 속도의 분포는 어디서부터 핀트를 잡아야 할지 몰라서 포기했습니다. 모든 쓰기를 SLC Cache에서 우선적으로 수용하는 정책일 줄 알았는데, 꼭 그런 것은 아닌 걸까요?

아무튼, 이 구간의 하위 1% 속도는 22.28MB/s 이었습니다. 아래에서 확인할 수 있겠지만, 첫 번째 Fill Drive의 하위 1%와는 상당한 차이입니다.

두 번째 Fill Drive를 수행하는 일반 소비자는 거의 없겠지만, 바로 위의 1,000~7,500초만 넘긴다면 SLC Cache에 해당하는 속도를 조금이라도 볼 수 있다는 희망적인 관측을 하시는 분이 계실 것 같아 말씀드립니다.

총 17,238초의 2번째 쓰기 작업에서 상위 1%의 속도는 186.12MB/s에 불과했습니다. 그래프가 선으로 이어져있어 희망적으로 보일 수도 있겠지만, 실질적으로 SLC Cache에 해당하는 속도는 상당히보기 힘들 것 같습니다.

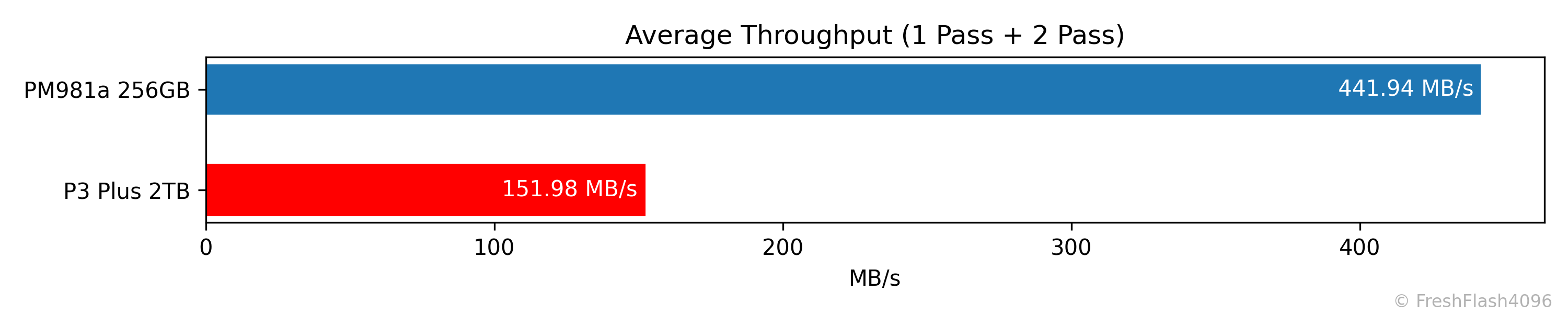

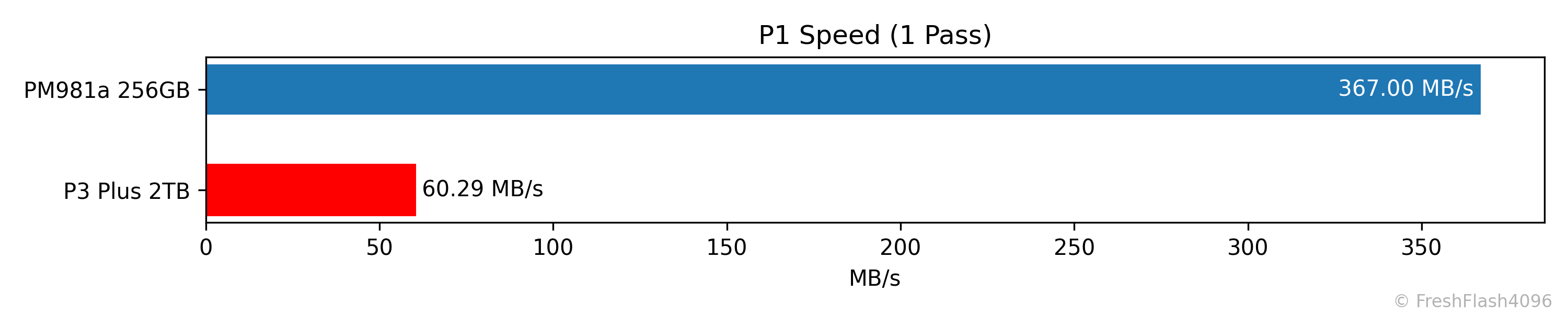

복잡한 건 넘기고, 첫 번째와 두 번째의 Fill Drive에 대한 전체 평균값은 위와 같습니다. 쉴 틈 없이 계속해서 순차 쓰기를 가하시는 분들은 차라리 870 EVO 같은 SATA SSD의 구매가 더 좋아 보입니다.

물론, 그런 건 소비자 워크로드라고 하기 좀 어렵고, 애초에 P3 Plus라는 제품 특성상, 제값을 주고 구매하시는 분은 적을 것 같습니다.

첫 번째 Fill Drive에 대한 하위 1% 속도입니다. 앞서 살펴본 SLC Cache 외부의 속도 중, 두 번째에 해당하는 값과 유사하네요.

그래도 느린 것은 느린 거죠.

Sync Performance

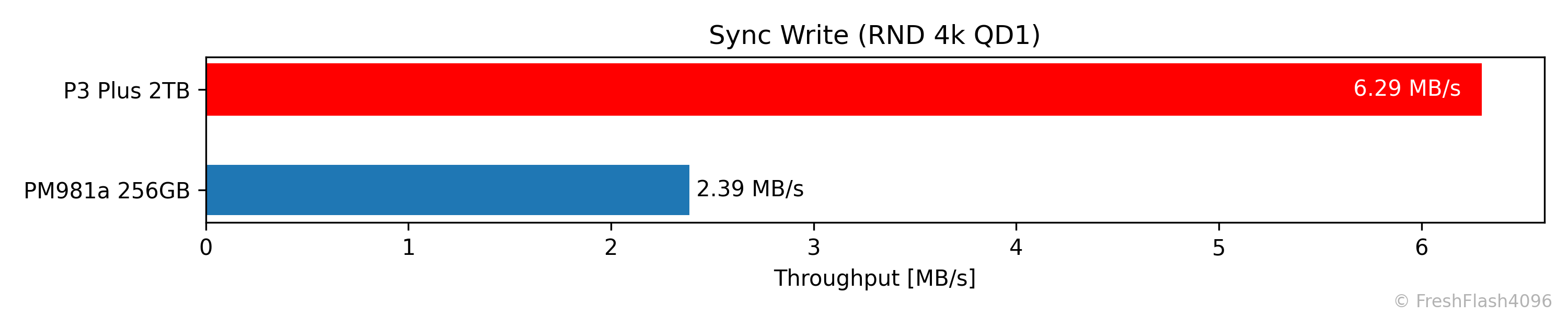

자체적인 Pre-Conditioning 이후, 해당 영역에 한해서 측정됩니다. 쓰기량은 총 500MiB이며, 최대 소모 시간은 2분으로 제한합니다. sync=1 옵션을 활용했습니다.

6.29 MB/s라는 속도를 보여주었습니다. 평범하네요.

Low QD Performance by RW Ratio

이전과 마찬가지로 Pre-Conditioning 이후에 측정하며, Burst 성능을 측정하기 위해서 각 단계에서 가해지는 I/O의 양은 GB 단위가 되지 않습니다. 다시 말해, 매우 가벼운 부하입니다. 전체 용량의 75%는 이미 채워져 있지만요.

다른 쪽은 평범하지만, 100% 쓰기에서 QD1, QD2, QD4의 성능 간 큰 차이가 발생하지 않았습니다. 쓰기가 90%의 비율로 가해져도 나름의 차이가 보였는데 말이죠.

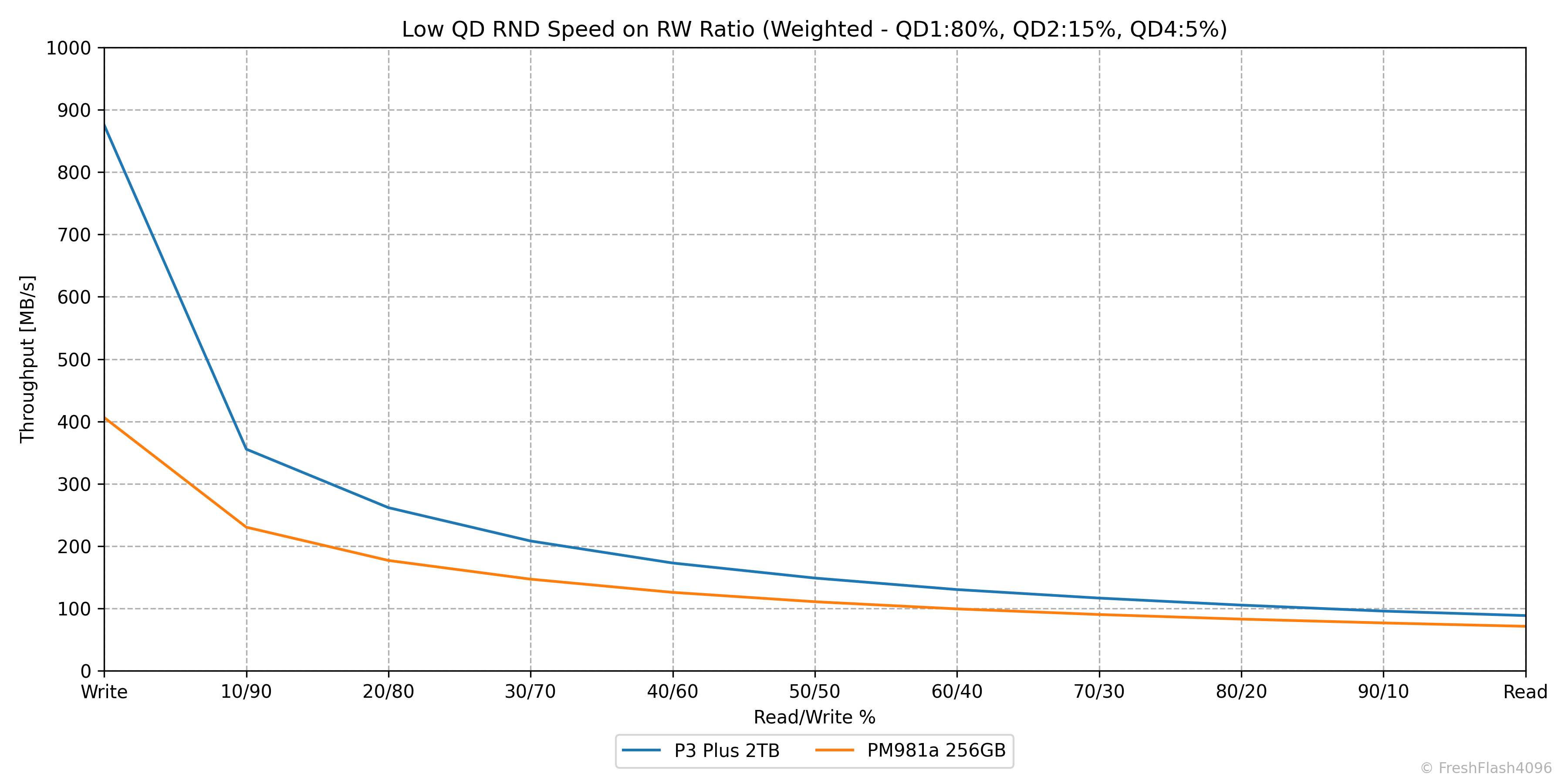

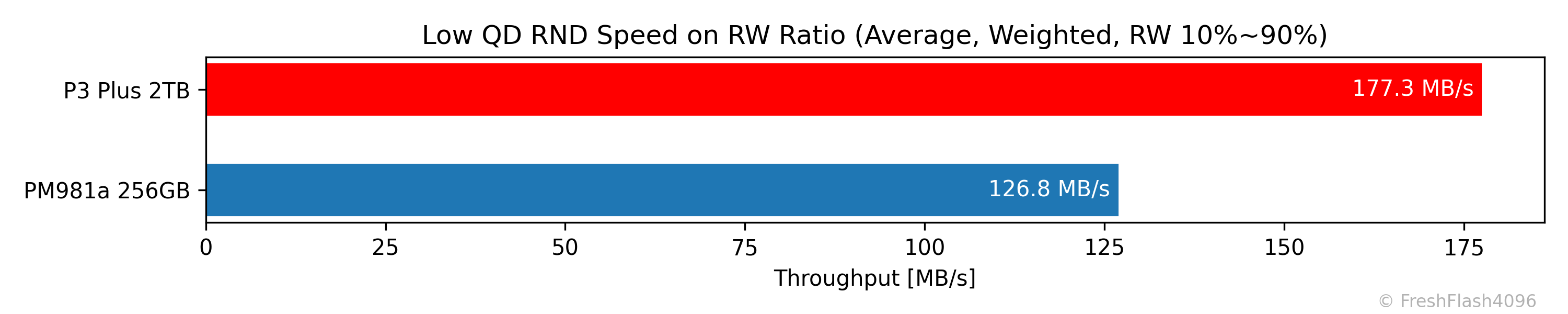

Weighted Graph

QD1 80%, QD2 15%, QD4 5%로 가중치를 부여해 보기 쉽게 나타냅니다.

가중치 그래프에서는 모든 측면에서 PM981a보다 앞서는 모습을 보여줍니다. 아무래도 가벼운 워크로드인 것이 QLC라는 단점을 상쇄해 줄 수 있으니, 최신 드라이브일수록 유리할 수밖에 없습니다.

용량이 8배이기도 하지만요.

완전한 읽쓰기를 제외하고 산출한 평균값입니다. 앞서 가중치 그래프에서 본 것과 같이 P3 Plus가 더 우수한 모습입니다. 비교군이 부족한 게 아쉽네요.

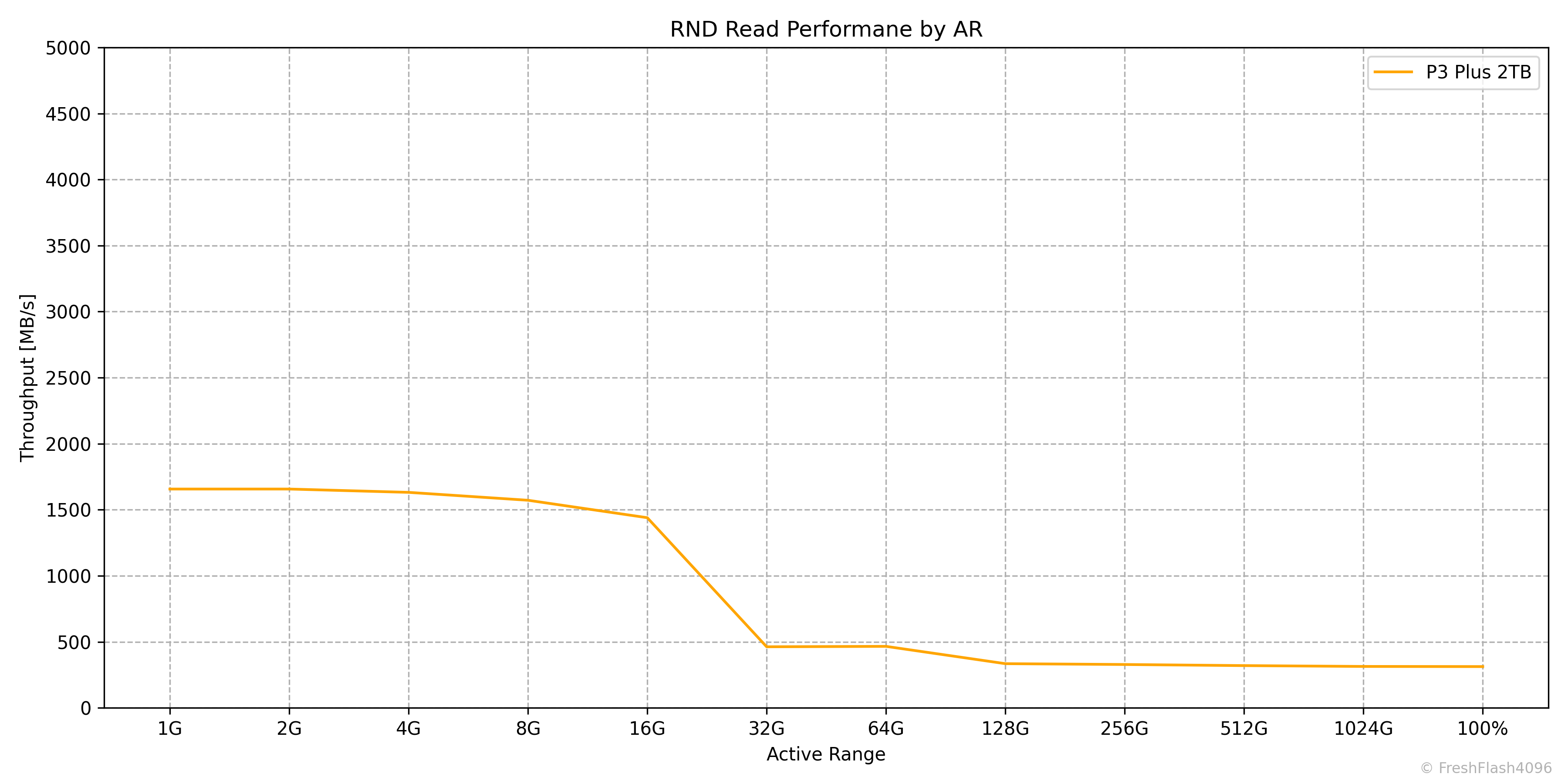

Performance by Active Range

접근하는 범위를 2배로 늘려가며 RND 4k QD256의 읽기를 가합니다. I/O 지역성을 낮추어 L2P Table에 대한 Cache miss를 발생시키는 것이 목적입니다.

일반적인 DRAM:NAND = 1:1000의 비율을 따르는 SSD들은 성능 변화가 거의 없지만, 이 비율을 따르지 않고 단순하게 Caching을 진행했거나 DRAMless 구조를 채용했다면, 드라이브의 넓은 영역에 걸쳐 발생하는 I/O에 대해 성능이 하락합니다.

P3 Plus 2TB는 DRAMless SSD이지만, HMB가 활성화되어 있었습니다. 이 용량은 32MiB가 보고되었으며, 실제로 딱 맞게 대응하는 32GiB부터 성능이 크게 하락하는 것을 확인할 수 있었습니다.

"32MiB의 L2P Table이 Caching 되어 있다면, 32GiB 까진 성능이 유지되어야 하는 것이 아닌가?" 하는 의문이 있을 수 있습니다. 간단하게 답변을 해드리자면, 이 벤치마크는 다른 cSSD 벤치마크와 다르게 각 용량 포인트 사이에 휴식 시간이 부여되지 않습니다. 그렇기 때문에 16GiB의 영역의 테스트를 수행한 이후, 더 넓은 32GiB의 영역에 대해 Cache miss가 발생하여 속도가 하락할 가능성이 있습니다.

애초에, 휴식 시간을 부여하더라도 HMB에 Caching하는 L2P Table의 갱신이 적극적으로 이루어지지 않는다면 결과는 비슷하리라 생각됩니다. 실제로 해보진 않아서 확신은 할 수 없지만 말이죠.

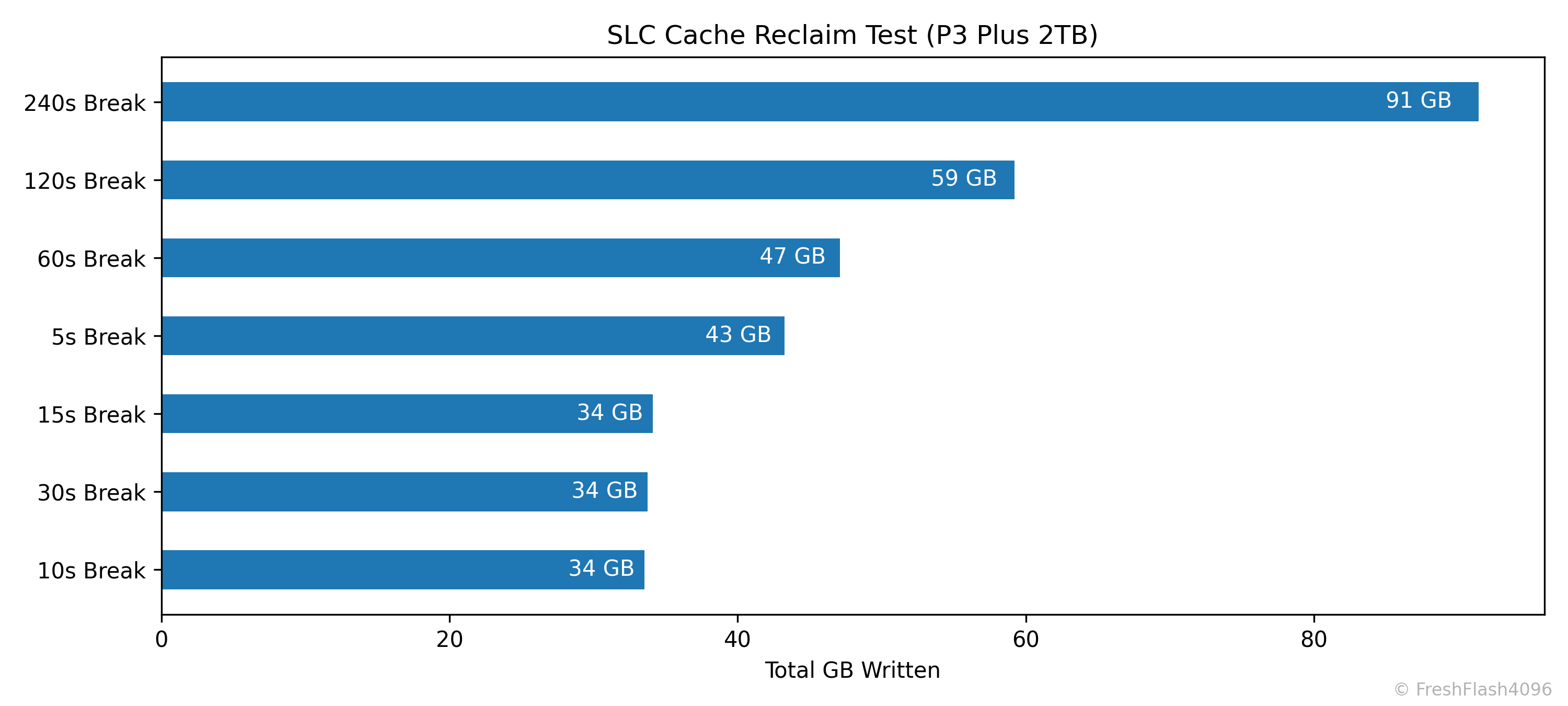

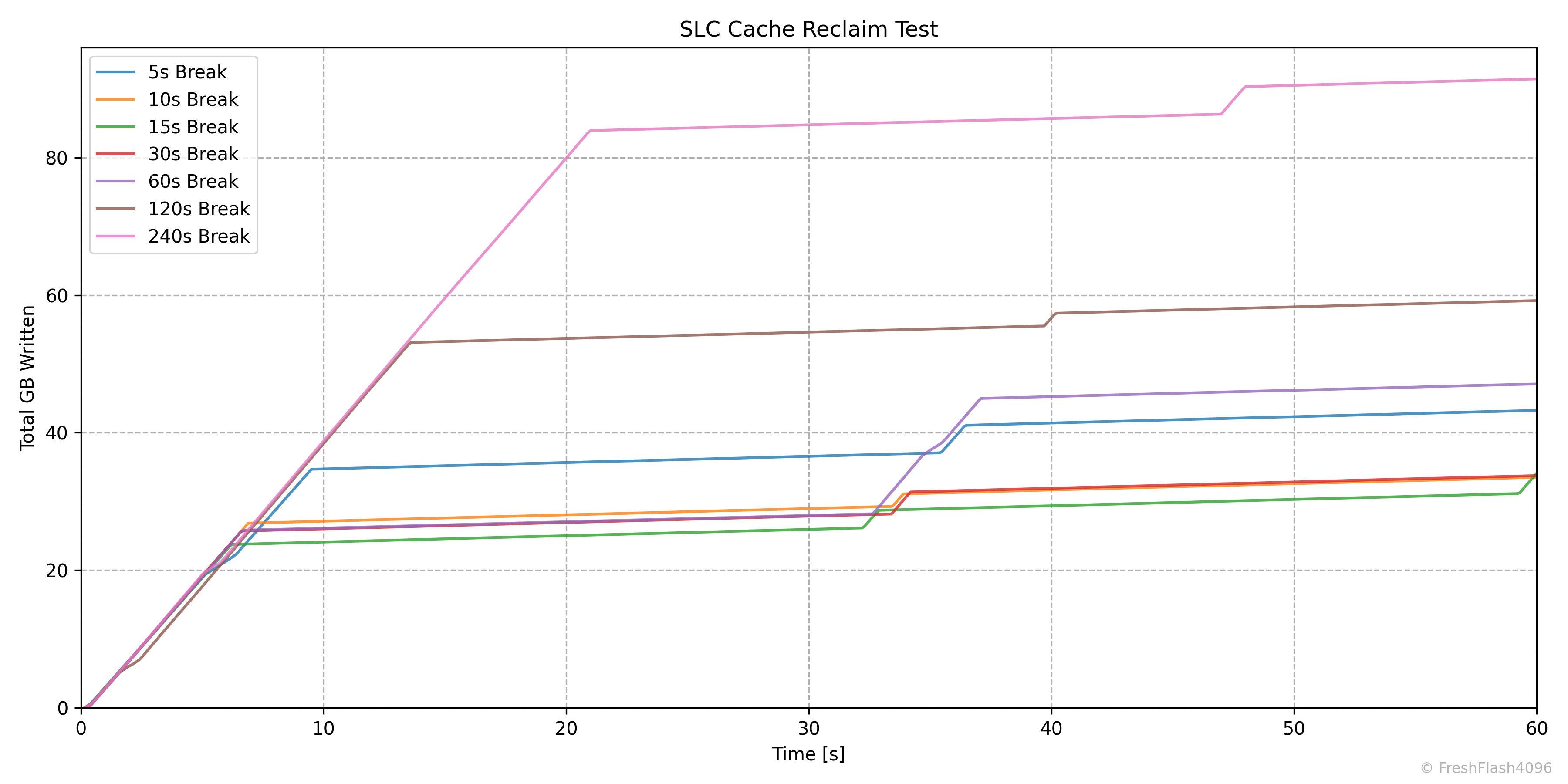

SLC Cache Reclaim

SLC 캐시의 회복에 대해서 알아보기 위해 설계되었습니다. Purge를 수행하고, User Capacity의 50%를 SEQ 128k QD256로 채운 뒤, 잠깐의 휴식을 취합니다. 이후, SEQ 128k QD256 쓰기를 1분간 진행합니다.

이 휴식 시간을 늘리며 테스트를 7회 진행합니다. 그래프들은 휴식 이후 1분간의 I/O에 대한 결과입니다.

최대 쓰기량은 2분의 휴식이 부여된 후, 91GB가 발생했습니다. 당연하지만, 240초 - 120초 - 60초 순으로 우수했습니다. 10초, 15초 30초는 SLC Cache에 대해 크게 의미 있는 회복이 진행되지 않아 34GB로 총 쓰기량이 동일하네요.

다만, 이상한 것은 5초의 휴식 시간이 부여된 회차입니다. 어째서 중간 순위에 들 수 있던 걸까요?

그래프의 기울기가 속도에 해당합니다. 모두가 초기 이후, SLC Cache에 해당하는 속도를 중간에 한 번 더 경험하고 있습니다. 그리고 5초의 휴식 시간이 부여된 지점은, 초기 SLC Caching의 혜택을 많이 받는 것을 확인할 수 있었습니다.

이해할 수 없는 일이네요. 사전 준비로 50%의 쓰기 작업은 제대로 수행되어 1TB의 쓰기량을 보고하고 있습니다. 휴식 시간을 잠깐 부여해 SLC Cache도 회복되었습니다. 그런데 너무 많이 회복되었네요.

고민을 좀 해봤지만, 답을 떠올릴 수 없는 문제였습니다. 아쉽지만 넘깁시다. 확실한 것은, 2분의 휴식 시간이 부여되면 80GB 이상의 SLC Cache를 회복하며, 이는 QLC로 곧 320GB 이상을 뜻합니다.

50%가 채워진 상태에서도 남아있는 공간을 최대한 SLC Cache로 활용하려는지는 모르겠지만, 만약 그렇다고 한다면, 2분은 조금 모자랐던 시간이었을 수도 있겠네요.

뭐, SLC Cache의 구현에 대한 자세한 내용은 대부분 내부 문서로 존재해 일반 소비자는 확인할 수 없지만요. 비교적 자세히 알고 있는 것은 SanDisk의 nCache인데, 나중에 한 번 풀어보겠습니다.

eSSD Benchmarking

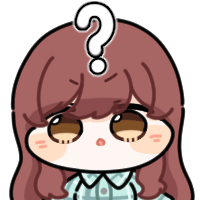

Boot Workload (OCP BootBench)

eSSD 벤치마크는 Steady State를 측정하는 것이 목표입니다. 하지만, 고성능의 cSSD를 제외하면 Steady State에 진입하는 시간 자체가 굉장히 오래 걸리며, 진입하지 못할 수도 있습니다.

따라서, 비교적 가벼운 OCP BootBench를 통해 eSSD 테스트의 수행 여부를 결정합니다. 하이퍼스케일에서 Boot SSD를 위해 정의된 테스트이며, 동기 쓰기와 TRIM, 읽기가 동시에 진행됩니다. 결과의 IOPS는 읽기이며, 60k IOPS를 넘겨야 통과입니다. 물론, 지정된 TRIM, 쓰기 속도를 달성하지 못해 테스트 자체가 실패할 수 있습니다.

P3 Plus 2TB는 이 테스트에 실패했습니다. PM981a도 25k IOPS로 기준선인 60k IOPS에는 도달하지 못하였지만, 테스트는 완수했죠.

아무리 인터페이스와 용량이 앞서도 이런 무거운 워크로드에서는 힘을 쓰지 못하는 것을 확인할 수 있었습니다. 아쉽지만(?) P3 Plus 2TB의 eSSD 테스트는 이것으로 종료합니다.

Closing

저는 너무 좋은 것만 보고 자랐나 봅니다. 생각해보니 지금까지 DRAMless SSD를 사용해본 경험이 테스트용의 WD Green이나 중국산 SSD 말고는 만져본 기억도 없거든요. QLC도 eSSD만 사용해 보았습니다.

이번이 QLC+DRAMless cSSD와 첫 만남인데, 사람들이 왜 꺼리는지 알 것 같다는 느낌이 드네요. 물론, 모든 드라이브가 그렇지는 않을 것이라고 희망을 품고 있습니다. P3 Plus는 크게 마음에 들진 않았지만요. 특히 75%가 채워져 있는 상태의 성능은 예상보다 크게 하락하였습니다.

"용량을 채우지 않고 쓰면 저용량의 PM981a보다 좋아요!"라고 할 수 있겠죠. 그럴 거면 2TB SSD를 왜 구입하냐는 딜레마에 빠지게 됩니다만.

그럼에도 불구하고, P3 Plus 2TB는 비교적 공간을 여유롭게 두고 읽기 작업 위주로 사용하시는 걸 권장하고 싶습니다. 많은 QLC SSD가 그렇겠지만, SLC Cache에 상당히 의존하는 SSD로 보이네요.

날씨가 급격하게 추워졌습니다. 오버클럭과 홈랩의 계절이 찾아왔네요. 모두들 난방을 끄고 컴퓨터를 풀로드합시다. 저도 벤치마크를 열심히 돌리는 중이니, 이른 시일내에 다음 리뷰로 찾아뵙도록 하겠습니다. 아마 eSSD의 리뷰가 될 것 같아요.

P3 Plus 2TB를 빌려주신 지인분께 이 글로 감사 인사를 전합니다. 사실, 두 제품을 빌려주셨는데, 다음다음다음 리뷰로 올라갈 것 같아요.

Comments