내가 SSD가 될 수 있을 리 없잖아, 무리무리! (※무리가 아니었다?!) [RMS-200 8GB]

Change log

2026.01.10 - Microchip 태그 추가

컴퓨터는 계층 구조를 이루고 있습니다. CPU를 다룰 때는 메모리가 그렇게 느리지만, 보조 기억장치를 다룰 때는 메모리가 굉장히 빠른 물건이 되어버리죠. 따라서 다음과 같은 생각을 할 수 있습니다.

주 기억장치인 메모리에 데이터를 직접 저장하는 것은 어떨까?

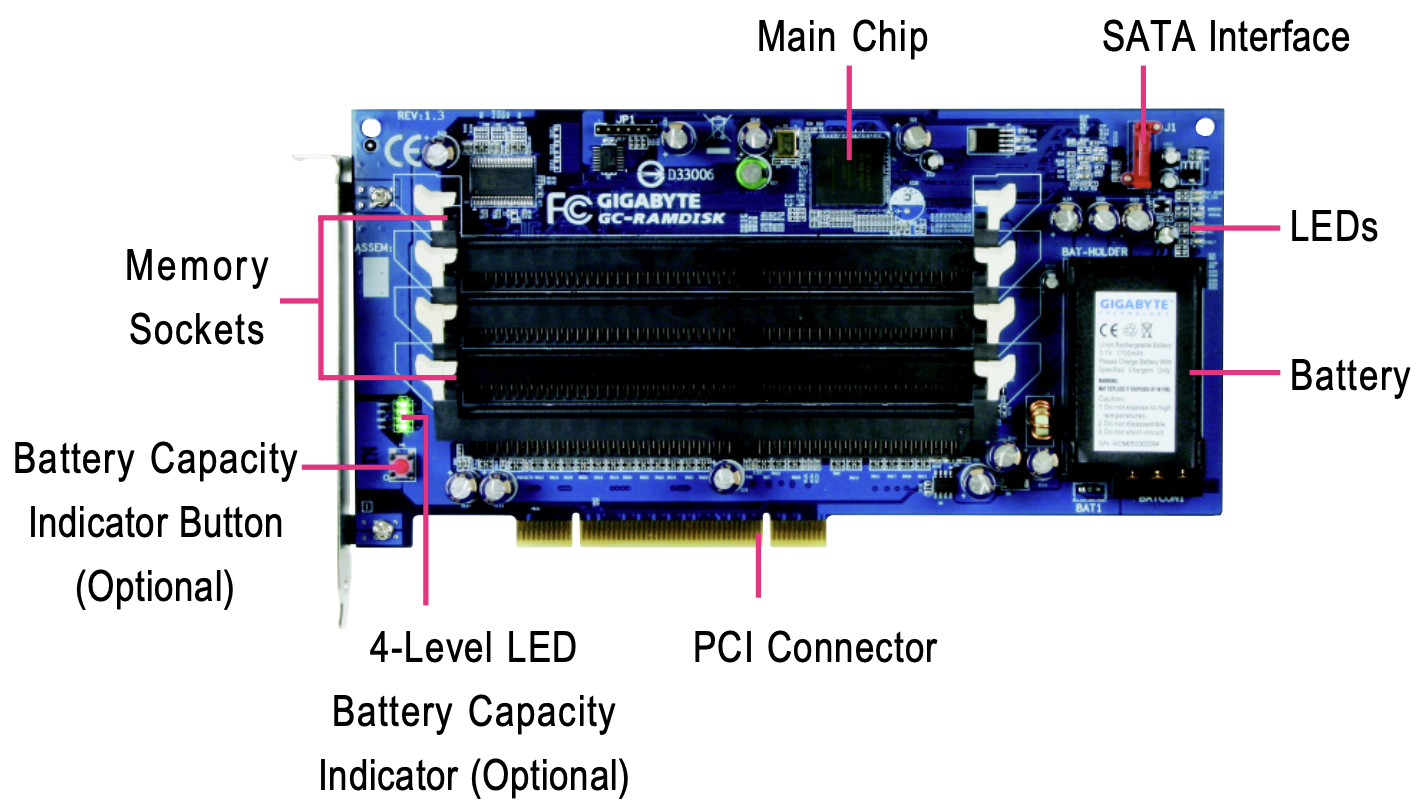

그리고 이 발상으로 나온 결과물을 흔히 RAMDISK(램디스크)라고 합니다. Primo Ramdisk처럼 SW를 통해 호스트 메모리의 일부를 직접 사용하는 방식도 있지만, GIGABYTE i-RAM처럼 HW로 구현한 방식도 있습니다.

i-RAM은 PCI 커넥터를 통해 파워를 공급받고, 실제 데이터의 입출력은 SATA 인터페이스로 진행됩니다. 20년 전의 제품으로 보이는데, (아마) SSD가 보급되지 않은 당시를 기준으로 한다면, 성능은 좋았을 것으로 생각됩니다.

SSD가 충분히 보급된 최근에는 이러한 램디스크의 효용이 떨어졌을 것으로 생각되지만, 여전히 램디스크를 구성하는 사용자들은 있습니다. SSD의 수명을 고려하거나 자기만족을 위해서 구성하는 것으로 보이는데, 일반 소비자가 접근하고 사용할 수 있는 솔루션이 제한된 만큼 대부분은 SW를 이용합니다.

여기까지만 말하면 이번 리뷰에서는 SW 기반의 램디스크들을 비교할 것 같지만, 크게 관심이 있는 것도 아니며, 유료 SW도 많고, 벤치마크가 꽤 어려울 것으로 생각되기에 생략합니다.

오늘은 10년 전에 출시된 것으로 보이는 HW 기반의 램디스크, RMS-200의 성능을 측정해 보려고 합니다. 구하기도 쉽고 평범하게 사용할 수 있는 램디스크 중에선 최근에 출시되어 NVMe SSD로 사용할 수 있는 것이 특징입니다. CXL과 같은 진짜 최신 기술들은 잠깐 잊어주세요.

목차

Appearance

외관은 굉장히 투박합니다. 후면은 별도의 백플레이트가 없고, 소자들이 많이 실장되어 있기에 장착 시 주의해야 합니다.

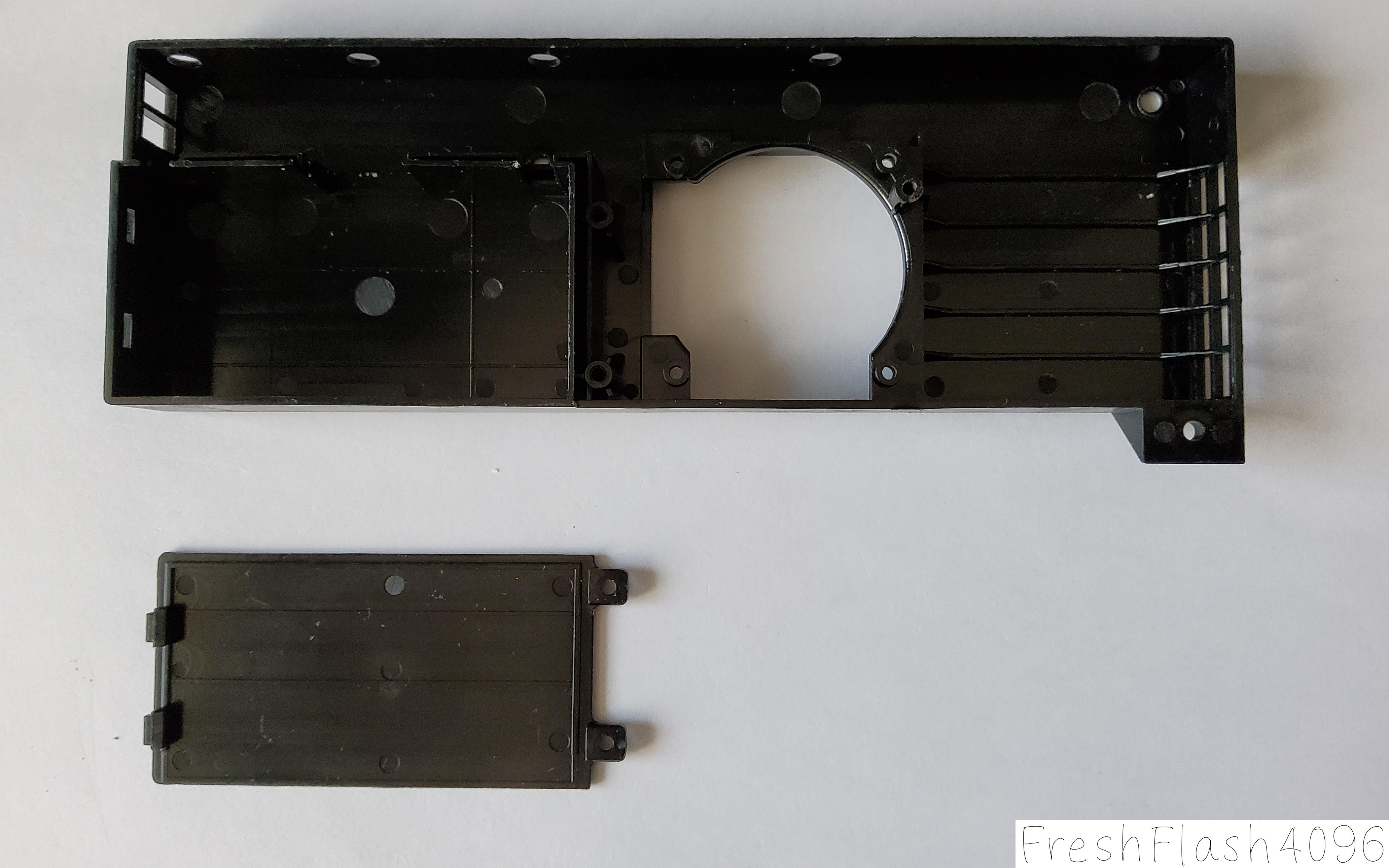

외관부를 분리한 모습입니다. HHHL 타입의 eSSD에서 볼 수 있었던 방열판은 아니며, 플라스틱으로 된 케이스입니다. 물론, 공기 흐름을 어느 정도 유도하는 역할은 해주는 것으로 보입니다.

아래의 분해 사진에서 예상할 수 있겠지만, 커패시터 구역은 칸막이로 분리가 되었습니다.

Internal Components

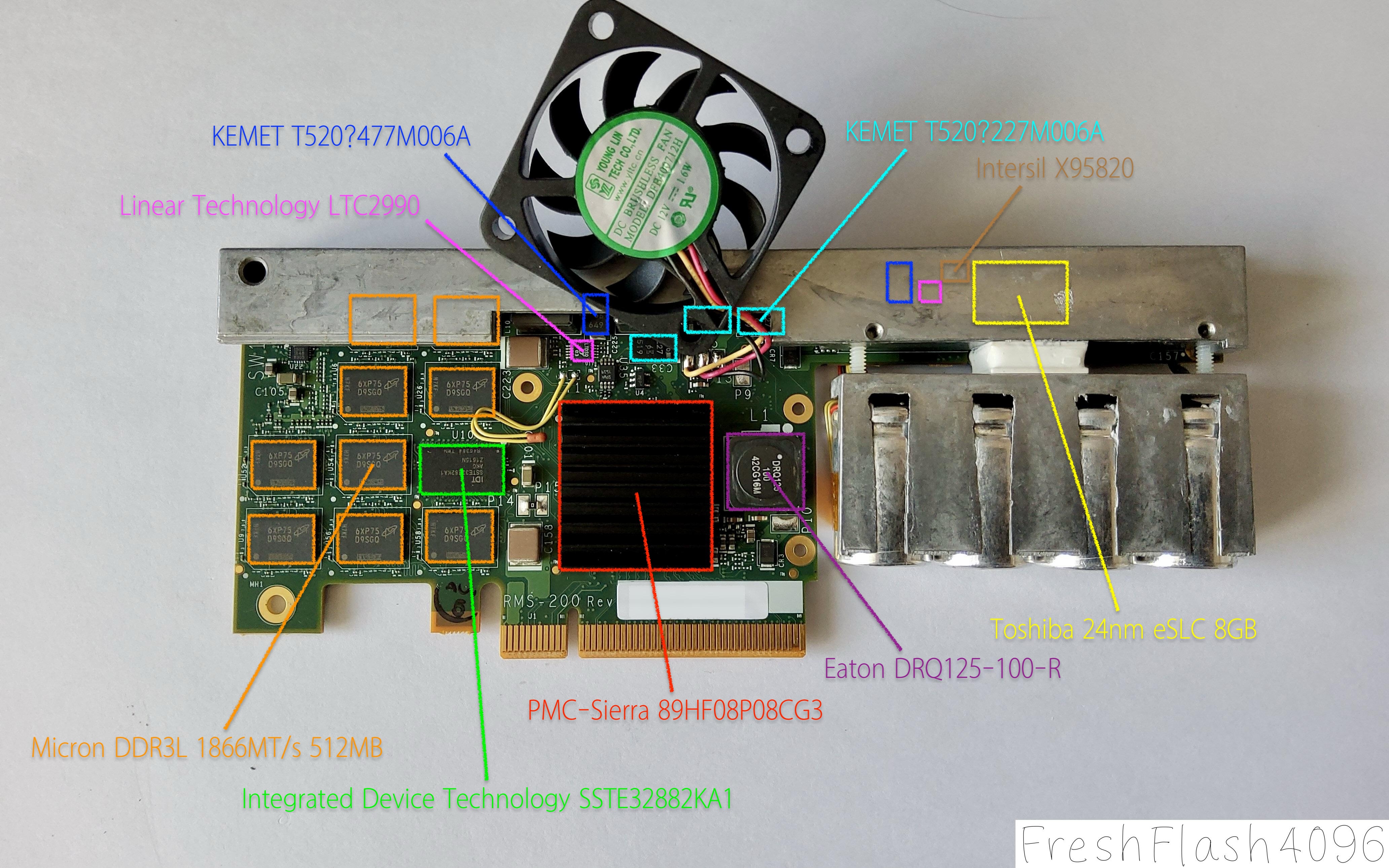

문외한의 입장에서 일부 IC만 찾아보았으며, 제조시기 등에 따라 변경될 가능성이 있습니다.

맞지 않을 확률이 상당히 높으니 재미로만 읽어주세요.

| Radian Memory Systems RMS-200 (8GB, HHHL) | Launch Date: 2014? |

| PMC-Sierra 89HF08P08CG3 | KEMET T520?227M006A *3 |

| Micron MT41K512M8DA-107:P *9 | КЕМЕТ Т520?477M006A *2 |

| Toshiba TH58TEG6H2HBA4C | Eaton DRQ125-100-R |

| IDT SSTE32882KA1 | Intersil X95820 |

| Linear Technology LTC2990 *2 |

팬은 YLTC DFB400712H를 사용했습니다. 12V 팬이며, 7500RPM, 6.51CFM, 3.25mmH2O 등의 스펙을 가지고 있습니다. 정확한 정보는 데이터시트를 참고하시면 좋을 것 같습니다.

벤치마크 중에는 많이 시끄러웠지만, 수명이 다했기에 그랬던 것으로 생각됩니다. 또한, 기판에 납땜이 되어있기에, 인두기 같은 것을 키우지 않는 일반인인 제가 교체하는 것은 힘들어 보였습니다.

컨트롤러는 PMC-Sierra 89HF08P08CG3를 사용합니다. 8채널의 엔터프라이즈용 컨트롤러이며, TSMC 공정과 Tensilica Xtensa 아키텍처가 채용되었습니다. NAND 인터페이스의 속도는 400MT/s인데, 이것만 봐도 얼마나 구형인지 알 수 있는 부분입니다.

참고로, PMC-Sierra는 2016년에 Microsemi에 인수되었으며, Microsemi는 2018년에 Microchip에 인수되었습니다. 제 블로그에서 본 기억이 있다면, 아마 7300 MAX의 리뷰입니다.

7300 MAX의 컨트롤러는 NVMe2108HC이며, Microsemi에서 제작하였죠. 이 친구는 Flashtec G2 플랫폼이었는데, RMS-200에 사용된 컨트롤러가 속한 시리즈는 Flashtec G1 플랫폼으로 편입되었습니다. 다만, 편입된 것은 16채널과 32채널이며, 8채널은 제외되었습니다.

DRAM은 Micron MT41K512M8DA-107:P입니다. DDR3L 1866MT/s CL13 4Gb의 사양을 가지며, 전면에 9개가 실장되었습니다. 여기선 클럭을 기억해 주시길 바랍니다.

NAND는 Toshiba TH58TEG6H2HBA4C이며, 8GB의 eSLC NAND입니다. 24nm 공정이 사용되었으며, 32Gb Die가 2개 패키징된 구조입니다. Toggle 인터페이스에 Page Size는 8kB, Block Size는 1MB임을 데이터시트에서 명시하고 있습니다.

IDT SSTE32882KA1은 DDR3용 RCD입니다. CUDIMM에는 CKD가 있다면, 본래 서버용인 RDIMM에는 RCD, Register Clock Driver가 있습니다. 일반적으로 서버용 메모리에서 한 가운데 박혀있는 칩이라고 생각하시면 됩니다.

호스트의 CPU와 메모리 사이에서 버퍼링을 수행하는데, RMS-200에서의 활용 방식도 유사할 수 있겠습니다.

Linear Technology LTC2990은 온도, 전압, 전류를 모니터링할 수 있는 칩입니다.

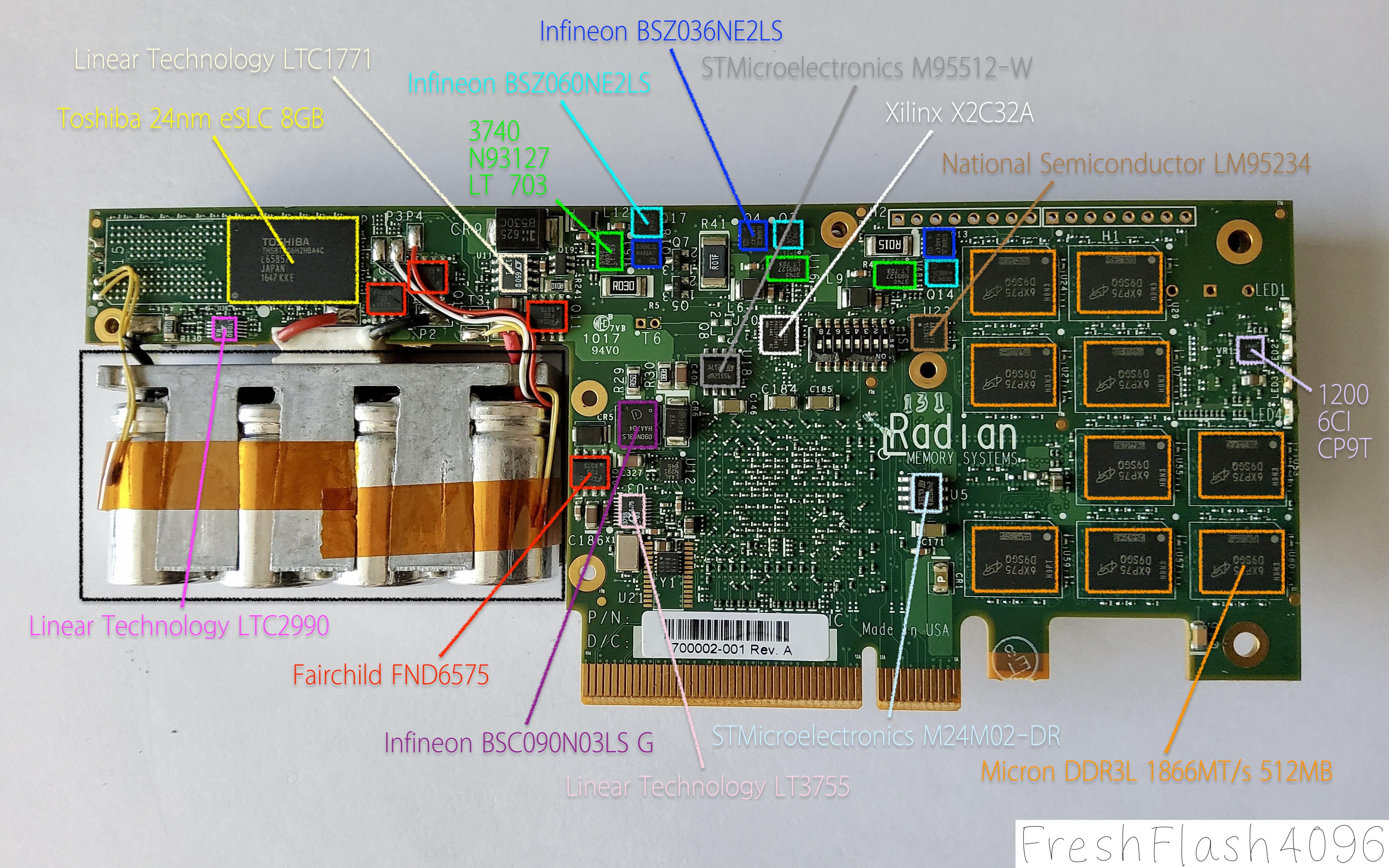

| Radian Memory Systems RMS-200 (8GB, HHHL) | Launch Date: 2014? |

| Fairchild FND6575 *4 | Infineon BSZ060NE2LS *3 |

| Micron MT41K512M8DA-107:P *9 | Infineon BSZ036NE2LS *3 |

| Toshiba TH58TEG6H2HBA4C | Infineon BSCO90NO3LS G |

| Linear Technology LTC2990 | National Semiconductor LM95234 |

| Linear Technology LT3755 | Linear Technology LTC1771 |

| STMicroelectronics M24M02-DR | Xilinx X2C32A |

| STMicroelectronics M95512-W |

DRAM인 Micron MT41K512M8DA-107:P는 전면에서 봤던 것과 개수까지 동일합니다. 다시 말해, RMS-200에 실장된 4Gb(512MB)의 칩은 총합 18개로, 약 9GB의 용량을 이루고 있습니다. 용도에 대해선 여러 가지 추정이 가능하나, 데이터시트를 통해 ECC를 위한 용량인 것으로 생각할 수 있습니다.

NAND, Toshiba TH58TEG6H2HBA4C는 전면에서 확인했던 것과 동일합니다. 의문점이라면, 이것으로 총합 16GB의 NAND가 SSD에 있다는 것입니다. 실제 데이터를 저장하는 공간은 8GB인데 말이죠. 자세한 것은 아래에서 다시 다루겠습니다.

Linear Technology LT3755는 45V 입력과 75V 출력의 LED 컨트롤러라고 합니다. 고전류의 LED를 사용할 때 투입되는 것으로 보이는데, RMS-200에는 후면에 깜빡이는 4개의 LED밖에 없습니다.

사용사례에서는 High Power LED도 있지만, Battery Chargers도 기재되어 있습니다. 아마 후자의 사례로 활용된 것이 아닌가 생각됩니다.

STMicroelectronics M24M02-DR은 2Mb의 EEPROM입니다.

STMicroelectronics M95512-W는 512kb의 EEPROM입니다.

National Semiconductor LM95234는 온도 센서입니다. 다만, 칩이 실장된 위치의 온도를 측정하는 것이 아니라, 최대 4개의 원격의 다이오드를 통해 값을 읽어오는 것으로 보입니다.

실제로 온도를 측정하는 것으로 보이는 부분이 4개 정도 보였습니다. 컨트롤러 부근과 전면부의 낸드 위쪽, 커패시터 부근의 2개입니다.

Xilinx X2C32A는 FPGA겠죠. 다만, 검색을 시도하면 XC2C32A 위주로 결과가 나오며, X2C32A에 대한 결과는 많지 않습니다.

검은색 사각형은 울트라 커패시터입니다. 별도의 스펙은 알 수 없었으며, 기판과 4개의 전선(-+-+)으로 연결되었습니다.

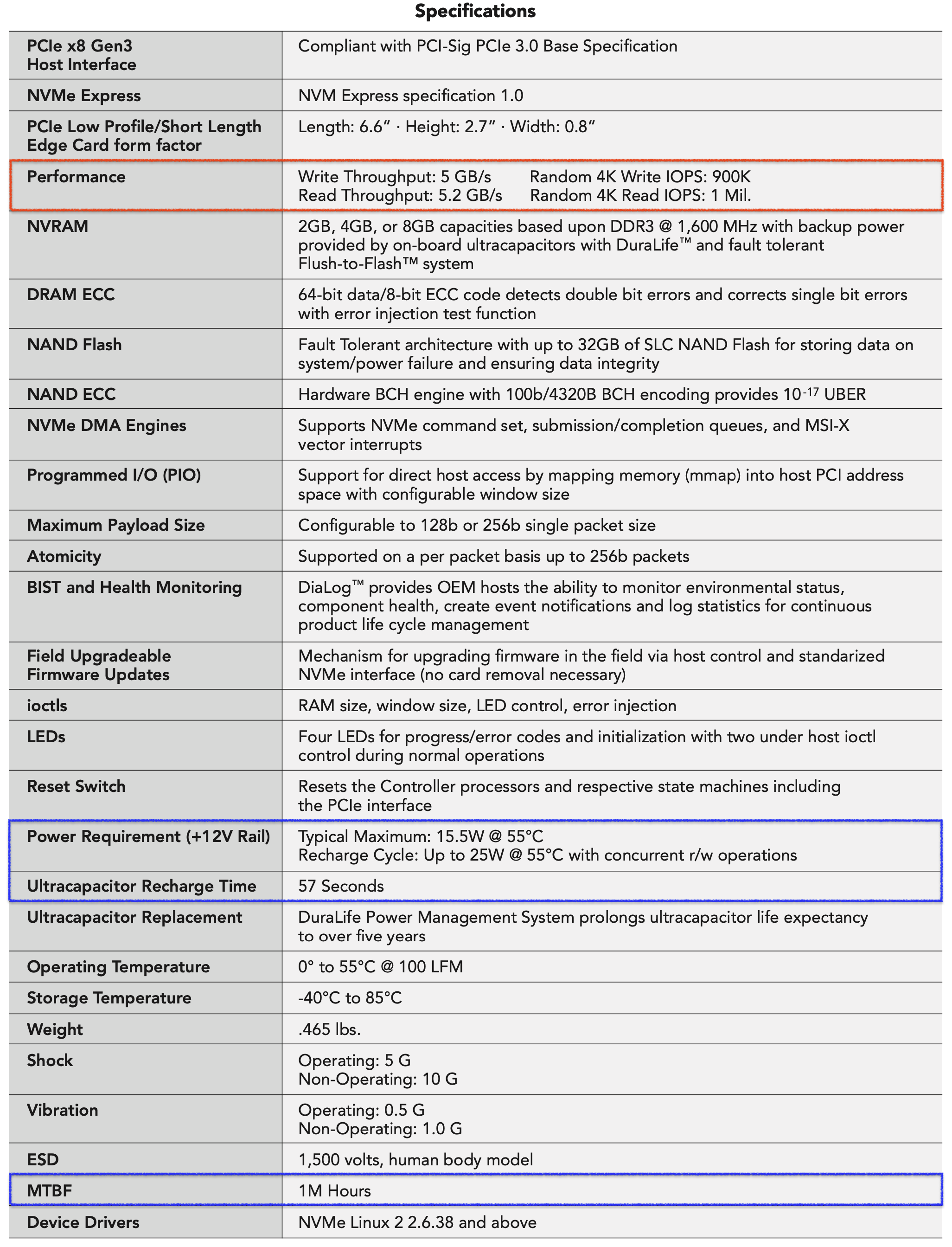

Datasheet

눈에 띄는 부분은 꽤 많습니다. 아래에서 중복으로 다룰 부분을 제외하고 한 번 짚어보도록 하겠습니다.

우선, 용량입니다. 2GB, 4GB, 8GB의 용량이 존재한다고 하지만, 홈페이지에서는 16GB의 용량을 옵션으로 선택 가능하다고 합니다. 아마 아래의 최대 32GB NAND Flash라는 것은 16GB의 RMS-200에 대한 이야기로 보입니다.

분해를 진행했을 때, 확인할 수 있던 것은 Micron사의 DDR3L 1866MT/s 9GB 메모리였습니다. DRAM ECC 부분에서 64bits + 8bits의 구조에 의해 SECDED(Single Error Correction Double Error Detection)가 가능하며, 1GB에 해당하는 메모리는 이를 위해 저장공간에서 제외될 수 있는 것을 생각할 수 있습니다.

하나 더 보자면, NVRAM에서 DDR3 @ 1,600MHz라고 명시된 부분입니다. SSD에서 갖가지 이유로 DRAM이나 NAND의 모든 성능을 활용하지 못하는 경우는 많으며, RMS-200에서도 이를 관찰할 수 있었습니다.

NAND ECC 부분의 BCH 엔진은 RMS-200에 탑재된 컨트롤러의 제품군에서 기본적으로 지원하는 기능입니다. 후속작이라고 볼 수 있는 Flashtec G2 플랫폼부터는 BCH가 아닌 LDPC를 사용합니다.

파워 요구 사항(12V)는 섭씨 55도에서 15.5W로 평가됩니다. 단, 울트라 커패시터가 충전 중일 때는 최대 25W인데, 충전 시간은 57초로 명시되어 있습니다. 충전은 전원이 켜지면서 시작될 것으로 생각되는데, 그렇다면 전원이 켜진 직후가 가장 전력을 많이 소모한다고도 볼 수 있겠습니다. 25W는 RW작업과 경쟁하는 상태라고는 하지만, NAND의 내용을 DRAM에 올릴 필요도 있을테니 말이죠.

마지막으로는 엔터프라이즈답지 않은 MTBF도 눈에 띕니다.

그 외에도 데이터시트에서 언급하는 재미난 기능이 많으나, 제조사의 소프트웨어 지원이 있어야 사용할 수 있는 것으로 보입니다. 이를 위해서는 당연히 NDA 계약 체결이 필요하고요.

Notable Points

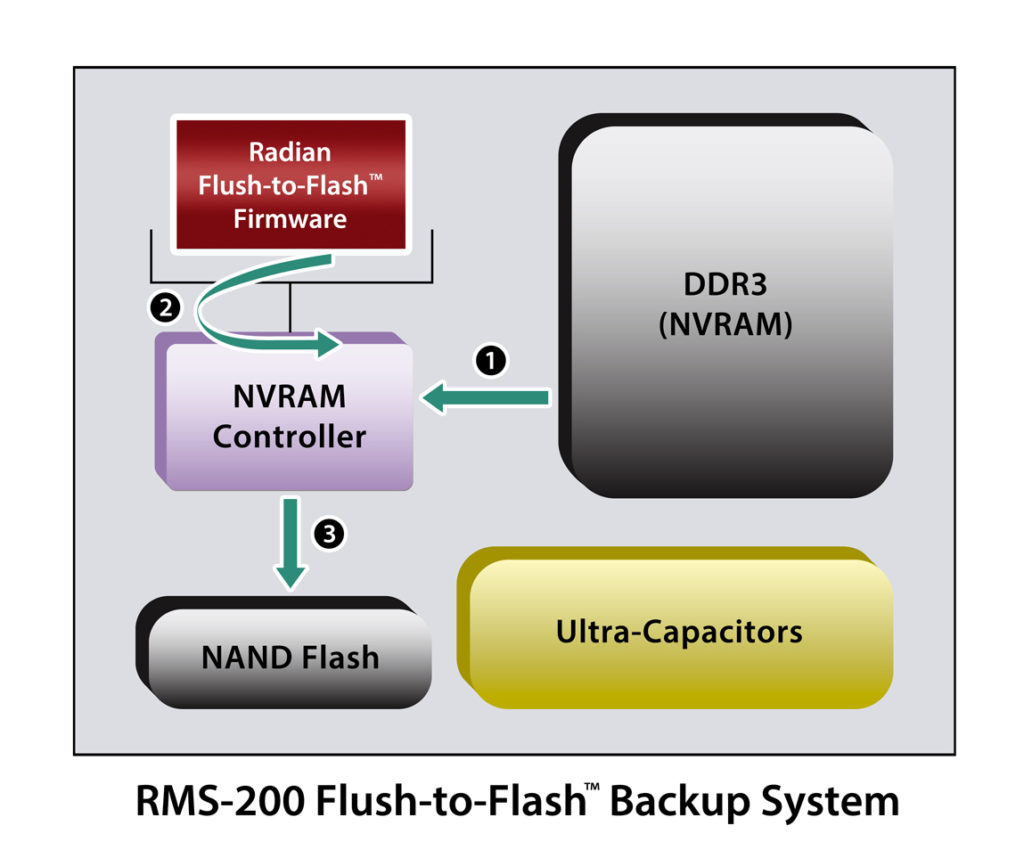

Flush-to-Flash

대부분의 eSSD는 갑작스러운 전원 이상에 대비하고 있습니다. 휘발성인 DRAM의 내용을 온전하게 보존하기 위해서인데, RMS-200은 DRAM을 캐시가 아닌 실제 저장공간으로 사용하기에 더 적극적으로 대비할 필요가 있습니다.

서론에서 언급했던 GIGABYTE의 i-RAM은 평상시 PCI 슬롯을 통해 전원을 공급받다가, 전원 공급이 손실되면 배터리를 통해 데이터를 보존합니다. 단, 영구적인 저장소가 없기에 보존 가능 시간은 배터리의 용량에 의존할 것이며, 여러 리뷰를 찾아보면 하루를 가지 못했던 것으로 보입니다.

분해한 이미지에서 보았듯, RMS-200 8GB에는 16GB의 SLC NAND와 울트라 커패시터가 실장되어 있습니다. 대략적인 작동은 위 이미지와 같습니다. 전원 공급에 이상이 발생하면, 울트라 커패시터에서 전원을 공급받기 시작하고, DRAM에 있는 데이터들이 펌웨어에 의해 NAND Flash로 Flush 됩니다.

Radian Memory Systems는 이를 Flush-to-Flash Backup System이라고 칭하며, 이 시스템과 NAND 어레이는 내결함성 아키텍처를 기반으로 합니다. 따라서 16GB의 SLC NAND는 RAID 1과 같은 모습을 취하고 있을 가능성이 높다고 보입니다.

울트라 커패시터의 역할이 굉장히 중요하다는 것을 제조사는 인지하고 커패시터의 용량을 필요 이상으로 충분히 확보, DuraLife라는 기술을 통한 수명의 연장, DiaLog라는 기술을 통해 여러 요소를 측정한다고 데이터시트에서 밝혔습니다.

다만, 개인이 구할 수 있는 RMS-200은 상당히 소모된 중고품일 테니 사용할 때는 반드시 데이터가 보존되는지 확인할 필요성이 있겠습니다.

SW Report

이례적으로 CDI는 2개의 캡쳐본을 첨부합니다. 슬프지만, 하나가 벤치마크 도중 사망에 이르러, 하나를 더 구했기 때문입니다. 양쪽 모두 400~500PB의 쓰기량을 보입니다. 그래도 기대 수명은 아직 한참 남았는데, 이는 역시 메모리가 저장매체로 사용되기 때문입니다. Optane SSD와 다르게 데이터를 더 쓰더라도 건강 상태는 줄어들지 않을 것 같습니다.

물론, NAND에는 수명이 존재하지만, 제품의 특성상 꺼질 일이 그렇게 자주 발생하지도 않을 것이고, 고내구성을 위해 SLC NAND가 채용된 것을 생각해 보면, NAND의 수명 걱정보단 DuraLife가 적용되었다고는 하지만, 커패시터의 수명을 걱정하는 것이 맞지 않나 싶습니다. 아니, 그보다 다른 소자의 수명을 걱정해야 할까요? 확실한 것은 팬이 가장 수명이 짧을 것 같습니다.

smartmontools와 NVMe-CLI의 id-ctrl 결과는 GitHub에 첨부하도록 하겠습니다.

DUT Summary

벤치마크를 진행할 SSD에 관한 요약입니다.

Radian Memory Systems RMS-200 8GB | |||

| Link | PCIe 3.0 x8 | NVMe Version | NVMe 1.0 |

| Firmware | ae34b8cc | LBA Size | 512B (+8B) / 4kB (+8B) |

| Controller | PMC 89HF08P08CG3 | Warning Temp | X °C |

| Storage Media | DDR3 @ 1600MHz | Critical Temp | X °C |

| Power State | Maximum Power | Entry Latency | Exit Latency |

| PS0 | 25.00 W | 100 μs | 100 μs |

Warning Temp, Critical Temp가 모두 명시되지 않았습니다. Thermal Throttling의 작동 여부가 궁금해졌으나, 실험해 보진 않았습니다.

그 외에 특이한 점은 정확한 용량이 8,581,545,984 [8.58 GB]로 보고된다는 점입니다. 일반적으로 저장장치 용량을 말할 때 사용하는 GB, TB 단위가 아닌, 2의 제곱수를 활용하는 GiB를 사용한 것에 가깝다고 볼 수 있겠습니다.

메모리를 저장 미디어로 사용하기에 기본적인 OP는 필요하지 않을 것으로 보이는데, 정확한 8GiB의 값(8,589,934,592)과는 일치하지 않습니다. 펌웨어를 올려놓는 영역인지 모르겠으나, 조금은 흥미롭습니다.

Comparison Device

비교군은 아래와 같습니다.

| Name | Why? |

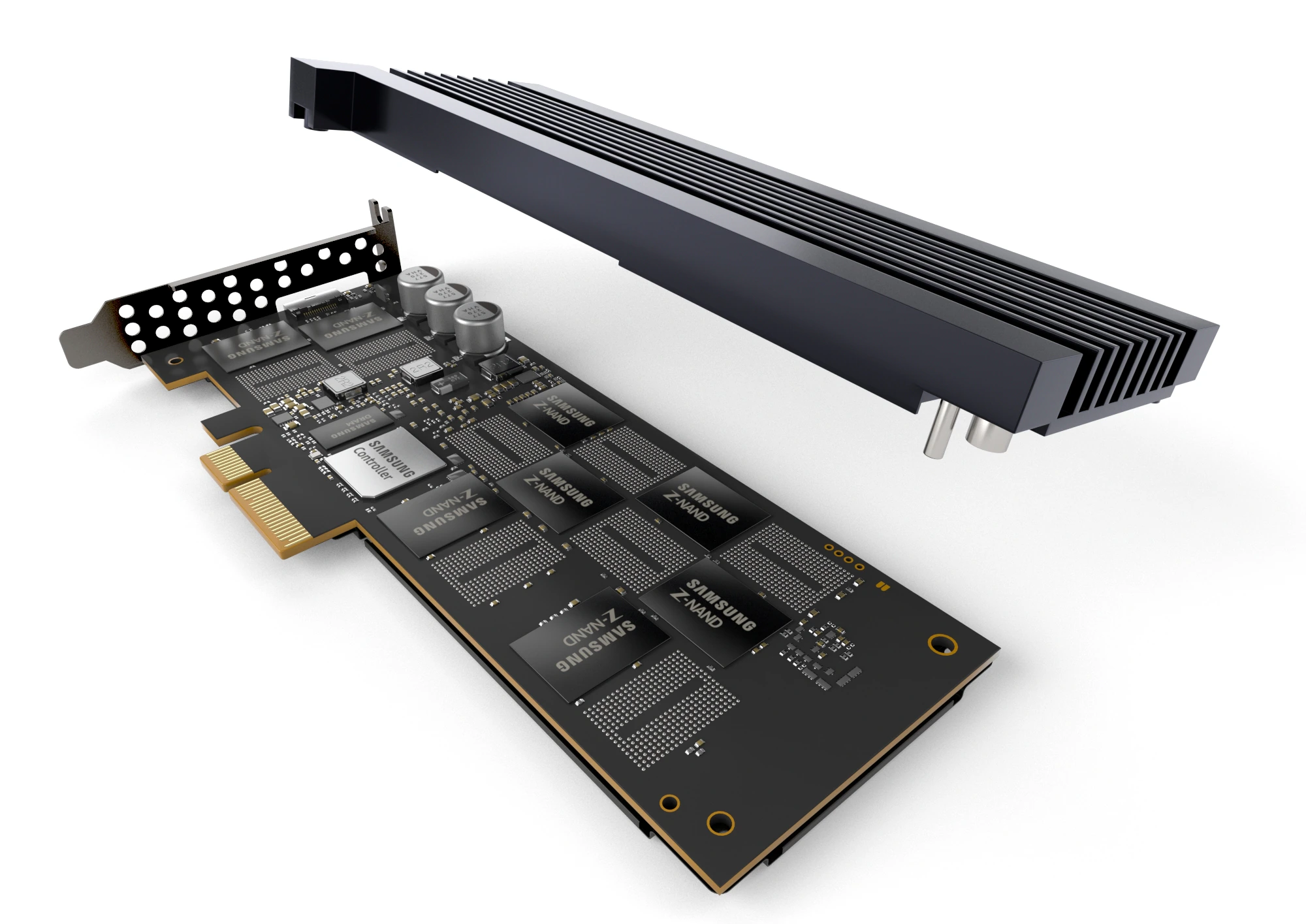

| 983 ZET 960GB [EEZ90R56] | Optane SSD의 자리를 노렸던 Z-SSD |

| P4800X 750GB [E2010650] | NAND가 아닌 3D XPoint를 기반으로 한 Optane SSD |

| 7450 MAX 1.6TB [E2MU300] | 4.0 x4의 인터페이스로, DUT의 3.0 x8와 유사한 대역폭 |

이번엔 좀 확실한 비교군을 가지고 올 수 있었습니다. 테스트를 진행했던 SCM(Storage Class Memory)급의 SSD와 유사한 대역폭의 인터페이스(3.0 x8 - 4.0 x4)를 가진 SSD로 구성했습니다.

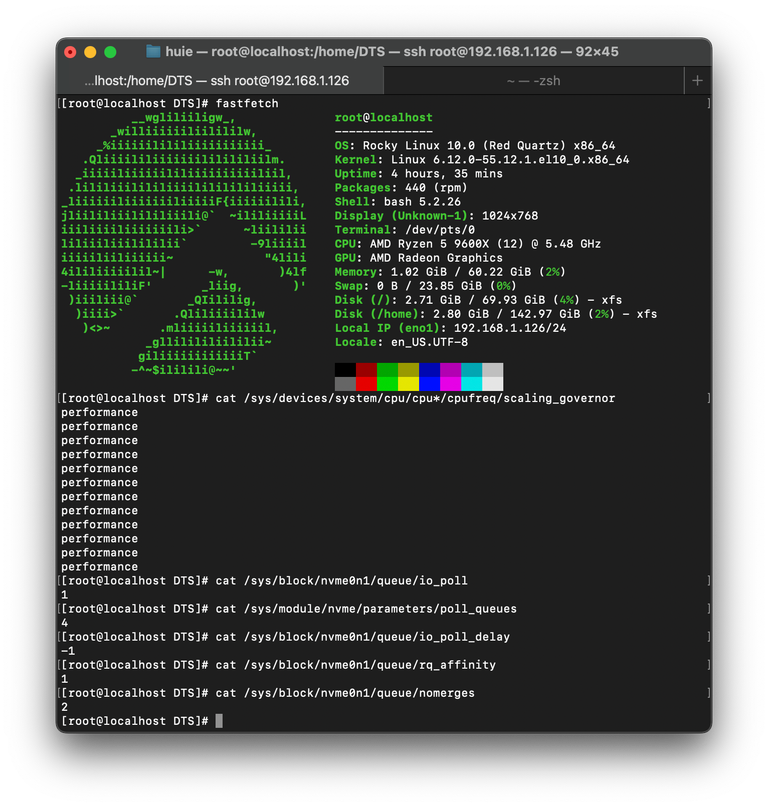

Test Platform

테스트 환경은 위와 같습니다. Windows 25H2(26200.6899)에 종속되는 도구들을 제외하고는 모두 FIO 3.41을 통해 Rocky Linux 10(6.12.0-55.12.1.el10_0)에서 실행되며, io_uring과 Polling을 적극적으로 활용합니다. 또한, 양쪽 다 기본 Inbox Driver를 사용합니다.

HW 사양에 대해서는 상단 우측의 fastfetch를 통해서 확인할 수 있지만, 다시 언급하자면, AMD의 9600X를 사용하고 있습니다. DUT는 5.0 x16 연결이 가능한 PEG 슬롯에 장착됩니다.

자세한 벤치마크 방법론에 대해서는 이전에 작성한 Refresh Benchmark를 참고해 주시길 바랍니다.

cSSD Benchmarking

start /wait Rundll32.exe advapi32.dll/ProcessIdleTasks Windows에서는 위의 명령어를 실행하고 15분 뒤를 IDLE 상태로 정의해 벤치마크를 진행합니다. 각 벤치마크 사이에는 5분의 휴식 시간이 부여되며, Purge는 Linux에서 nvme format 명령어를 통해 수행했습니다.

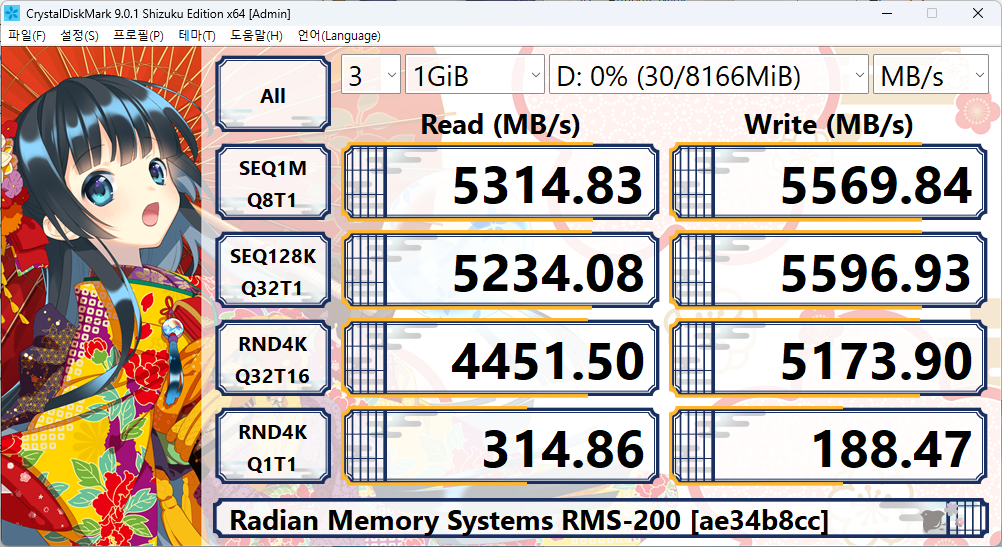

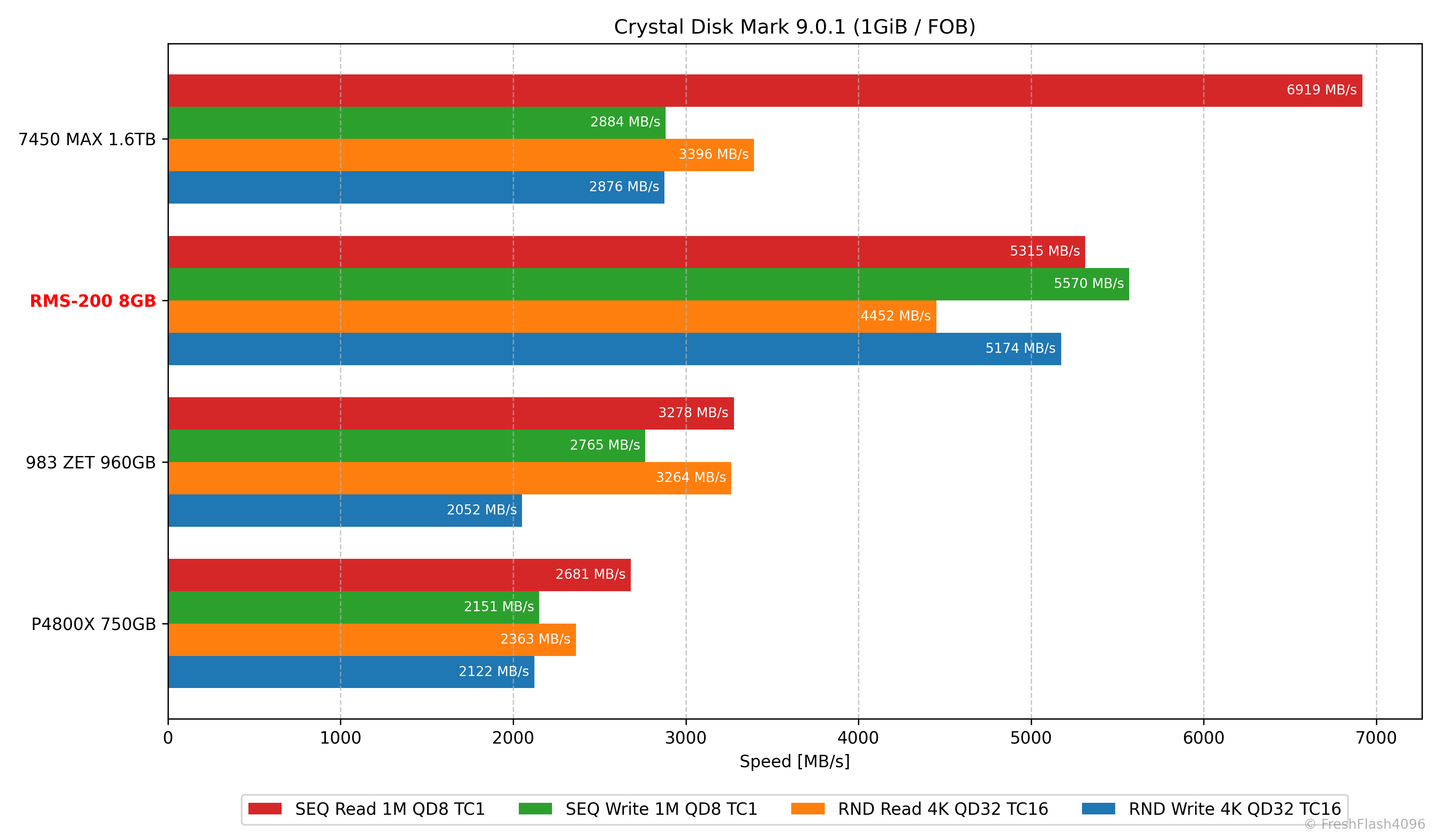

CrystalDiskMark 9.0.1

Windows에서 인식하는 용량은 8166MiB임을 확인할 수 있습니다. 앞에서 DUT를 요약할 때도 언급했지만, 일반적으로 8GB = 7629.39MiB라고 계산할 수 있다는 것을 떠올린다면, 약간 이득 본 기분이네요.

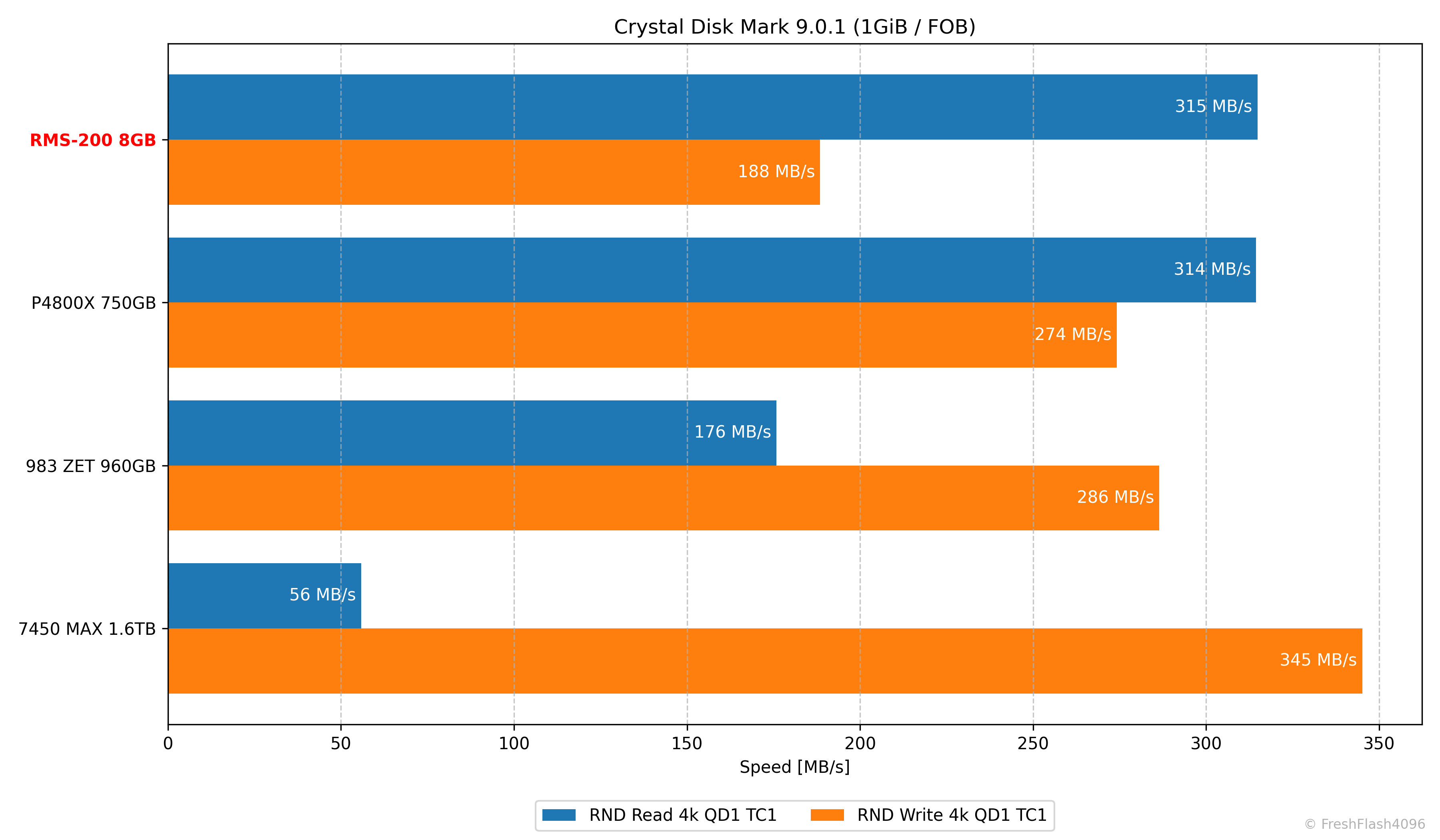

CDM의 결과는 위와 같습니다. 높은 QD와 다르게 QD1의 4k 랜덤 쓰기는 떨어지는 모습이네요.

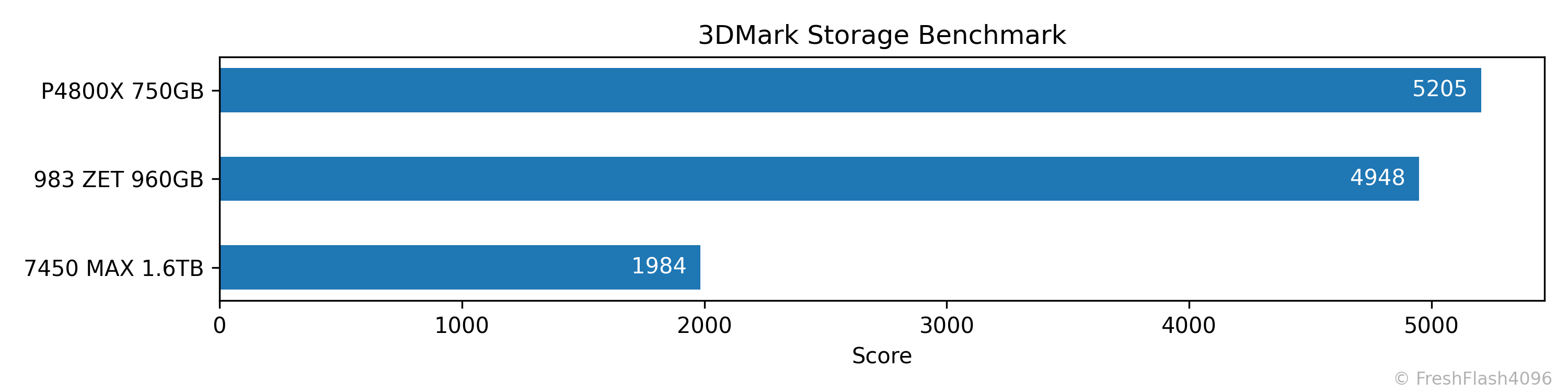

3DMark Storage Benchmark

DUT의 용량이 작아 테스트를 실행하지 못했습니다.

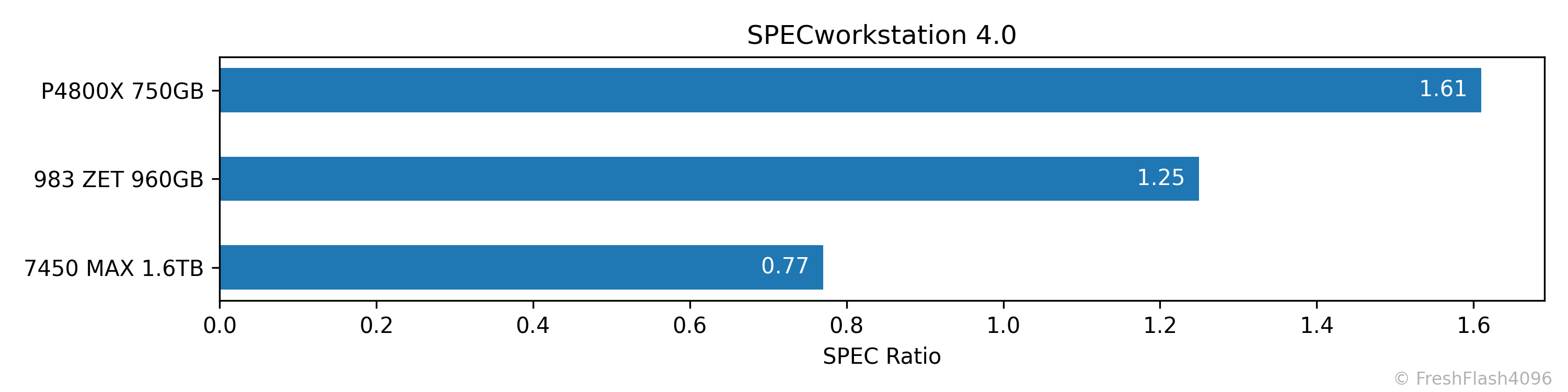

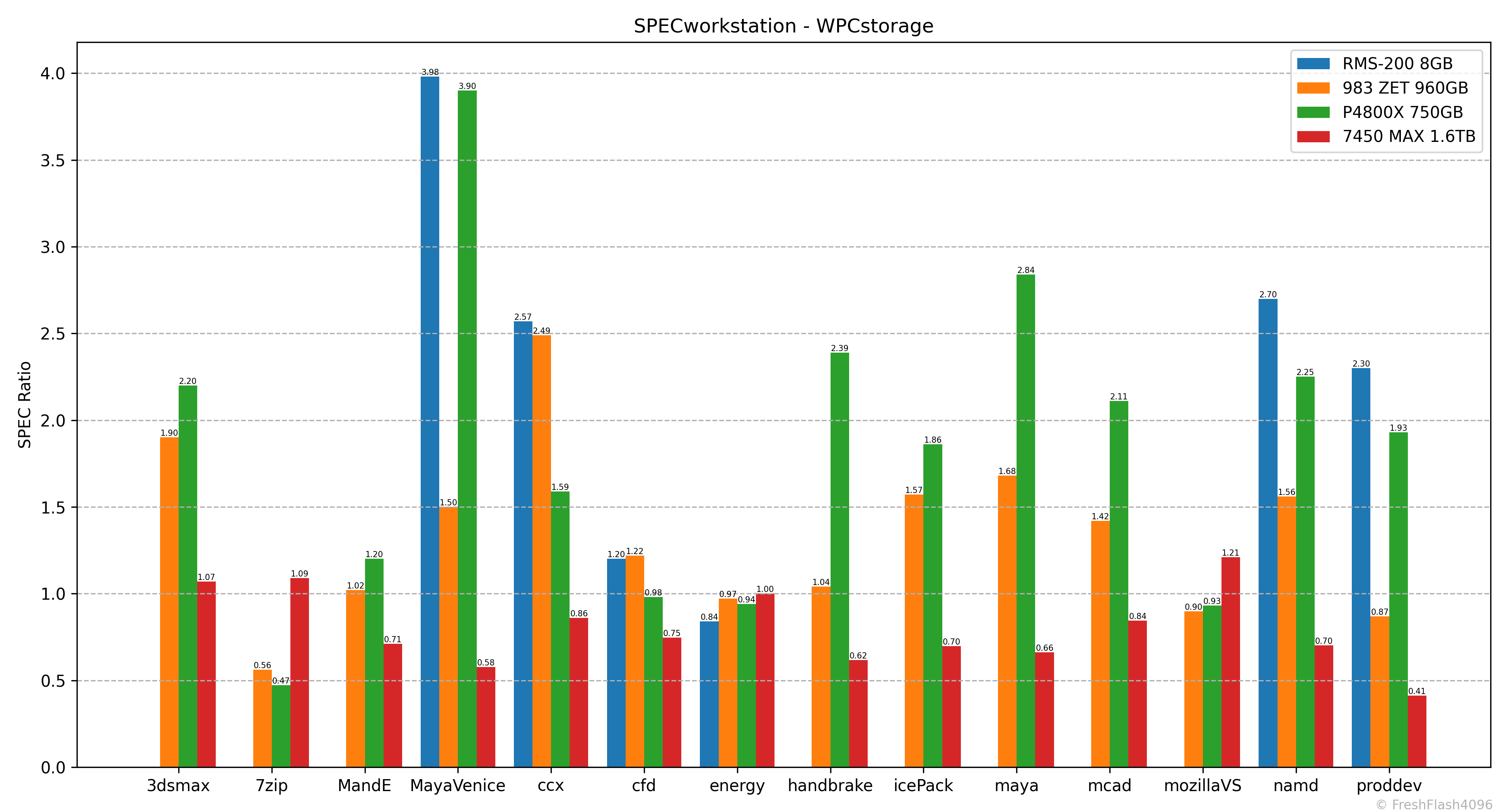

SPECworkstation 4.0

DUT의 용량이 작아 테스트를 실행하지 못했습니다. (2)

단, 일부 워크로드는 실행할 수 있었습니다. 성능은 보이는 대로 P4800X와 유사한 편입니다.

Fill Drive

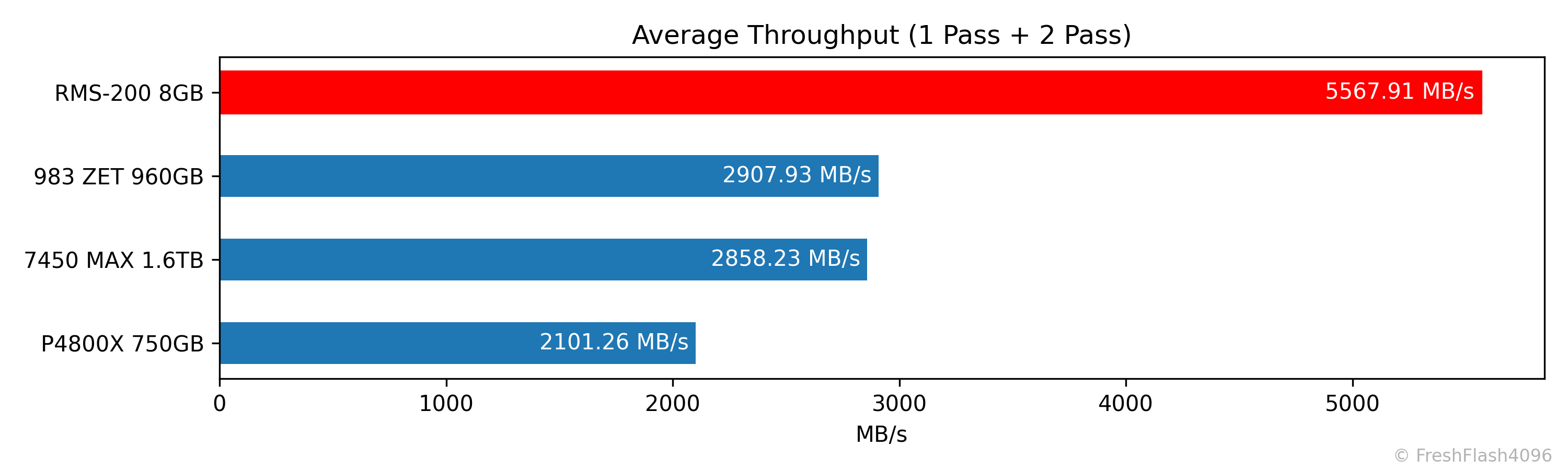

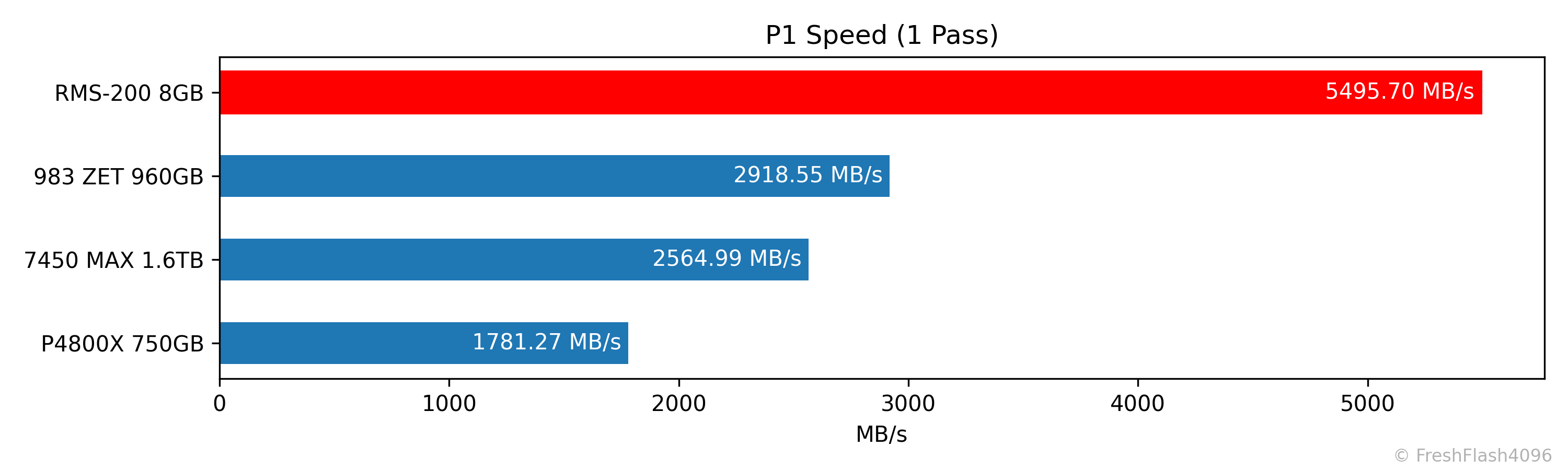

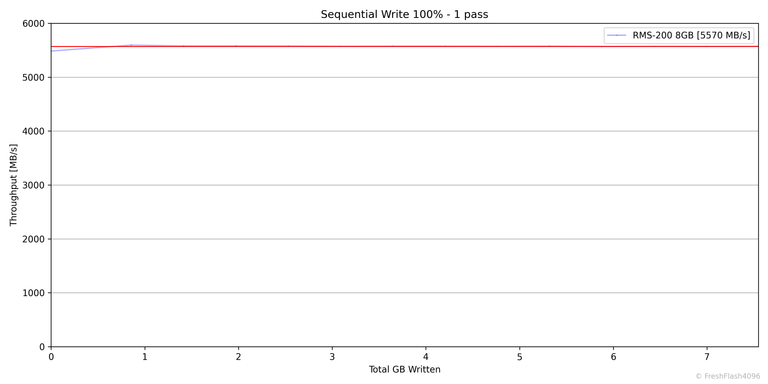

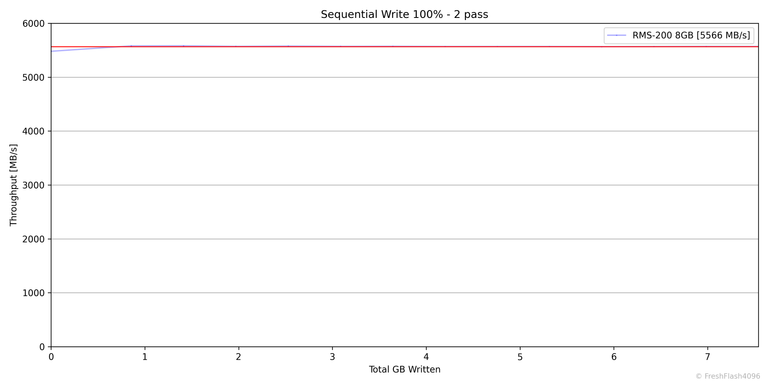

나래온 더티테스트와 비슷한 벤치마크입니다. FOB상태로 시작하여, SEQ 128k QD256으로 드라이브 전체를 2회 채우며, 0.1s 단위로 값을 측정합니다. 1회차와 2회차 사이의 휴식은 충분히 부여됩니다.

2회에 걸친 Fill Drive이지만, 이번엔 용량이 너무 작고 속도는 너무 빨라 상당히 무의미한 그래프가 되어버렸습니다. 둘을 합쳐 로깅값이 30개가 되지 않을 정도니까요...

나중에 로깅 간격을 변경해 다른 그래프를 추가하도록 하겠습니다.

첫 번째와 두 번째의 Fill Drive에 대한 전체 평균값은 5568MB/s로, 제가 테스트해 본 SSD 중 가장 우수했습니다.

첫 번째 Fill Drive에 대한 하위 1% 속도는 약 5496MB/s였지만, 역시 기록된 값의 수가 너무 적어 크게 유의미하진 않습니다. 이 역시 추후 보완토록 하겠습니다.

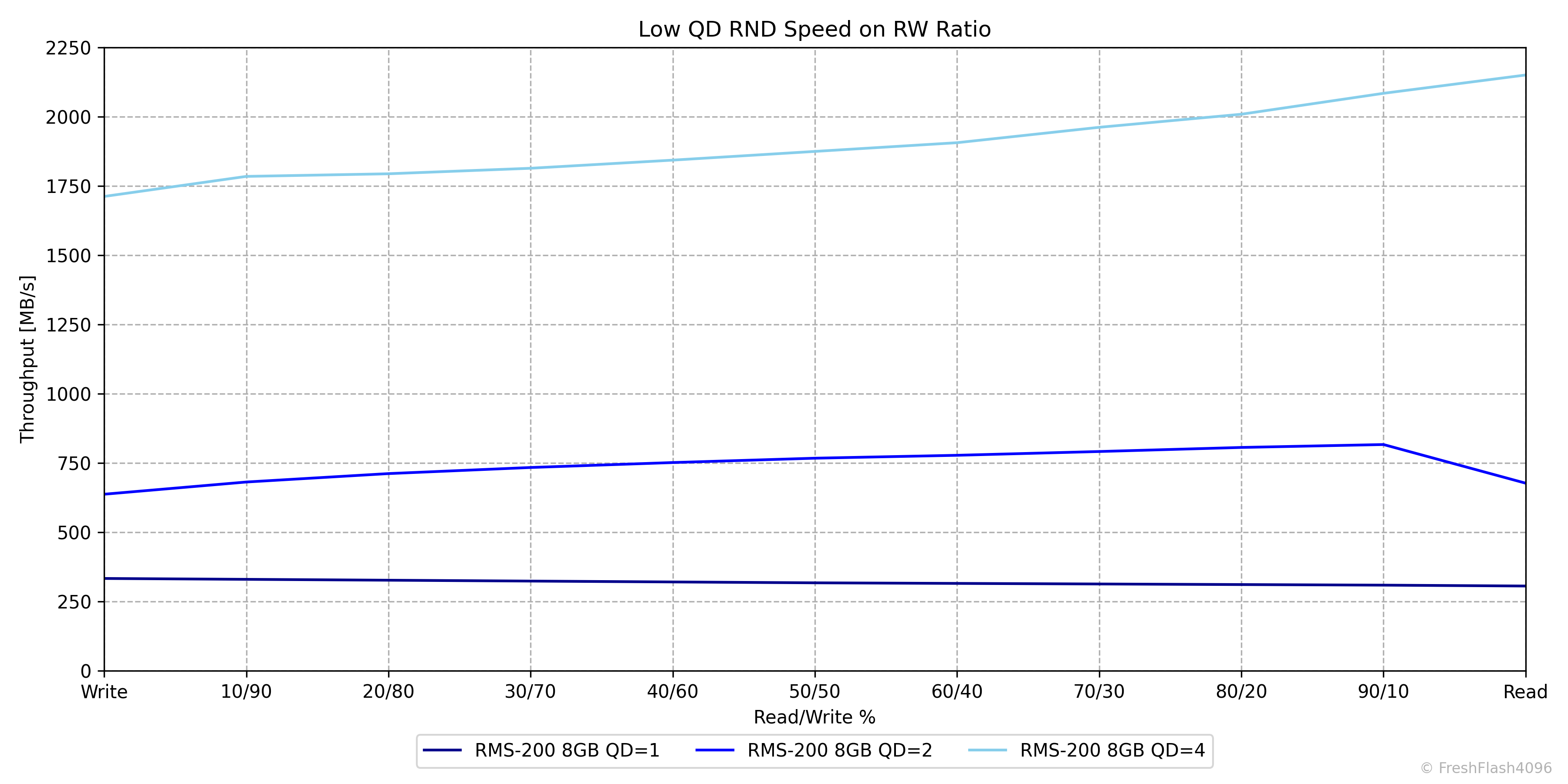

Low QD Performance by RW Ratio

이전과 마찬가지로 Pre-Conditioning 이후에 측정하며, Burst 성능을 측정하기 위해서 각 단계에서 가해지는 I/O의 양은 GB 단위가 되지 않습니다. 다시 말해, 매우 가벼운 부하입니다. 전체 용량의 75%는 이미 채워져 있지만요.

다만, RMS-200은 8GB의 용량을 가지고 있기에 Pre-Conditioning 과정에서 TRIM을 수행하지 않고, 전체가 4kB로 채워진 뒤에 해당 벤치마크가 수행되었습니다.

QD1의 평탄한 모습이 인상적입니다. 그 외에도 일반적인 NAND기반 SSD의 그래프와 다르다는 것은 한눈에 파악할 수 있습니다.

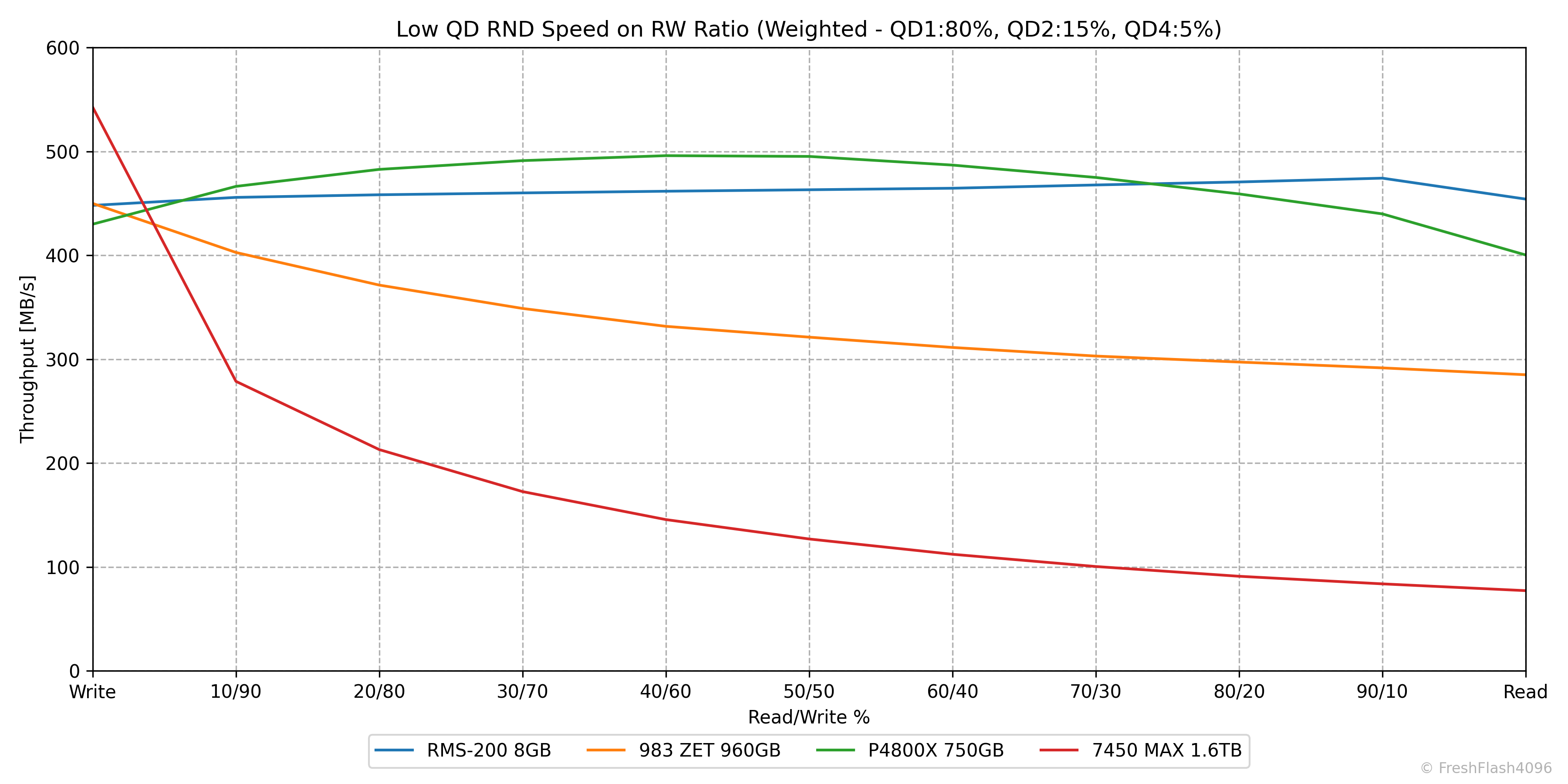

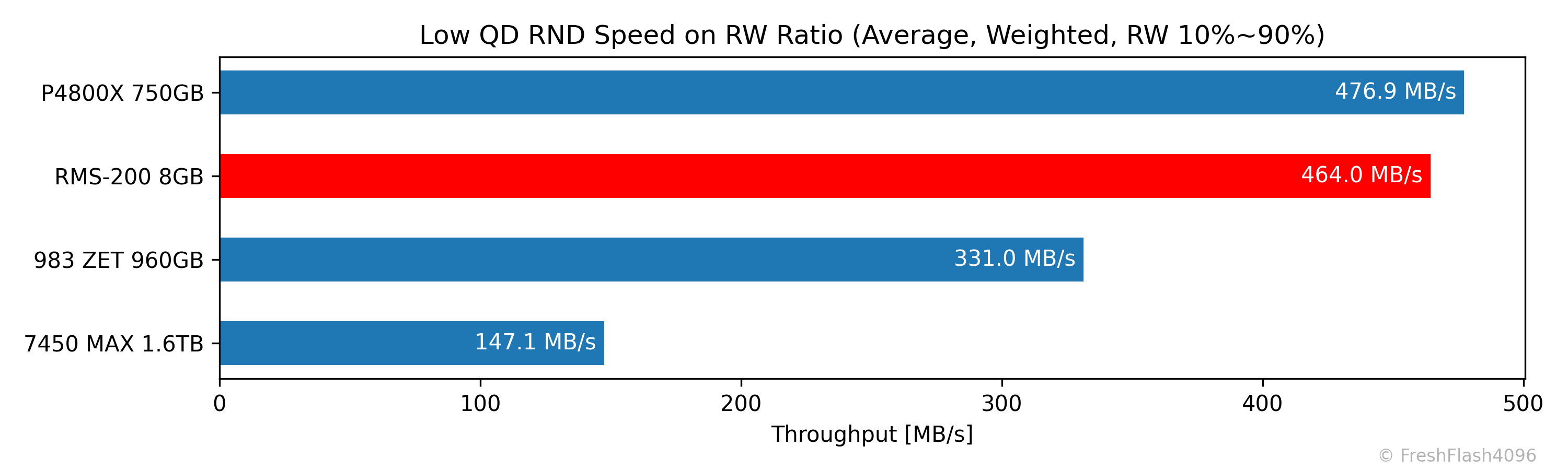

Weighted Graph

QD1 80%, QD2 15%, QD4 5%로 가중치를 부여해 보기 쉽게 나타냅니다.

P4800X와 유사한 모습인 것을 알 수 있습니다. 983 ZET는 여전히 NAND라는 것을 주장하는 것이 보이네요.

완전한 읽쓰기를 제외하고 산출한 평균값입니다. 비교적 쓰기 집약적인 부분에서 P4800X가 약간 더 우수했음에 따라 P4800X에는 밀리는 모습입니다.

eSSD Benchmarking

Purge 직후를 제외한 모든 단계 사이에는 휴식 시간이 부여되지 않습니다. Pre-Conditioning은 User Capacity의 2배를 쓰고나서도 Steady State에 진입할 때까지 이를 계속 진행합니다.

Steady State는 SEQ의 경우엔 대역폭의 기울기가 ±10%인 상태를 30초간 유지하는 것을 기준으로 하며, RND의 경우에는 IOPS의 기울기가 ±10%인 상태를 30초간 유지하는 것을 기준으로 합니다. 이를 달성할 수 없을 땐 User Capacity의 23배까지 쓰기를 진행합니다.

모든 워크로드는 User Capacity의 전체 영역에 대해서 진행하며, 각각 30초의 적응 시간을 가진 후에 5분 동안 성능측정을 진행합니다. 다시 말해, 128k Read 성능을 측정한다면 QD1 ~ QD256까지 총 9개의 작업이 있으며, 모든 작업이 30초의 적응 시간과 5분의 측정시간이 부여됩니다.

역시 자세한 벤치마크 방법론에 대해서는 이전에 작성한 Refresh Benchmark를 참고해주시길 바랍니다.

4-Corners Performance

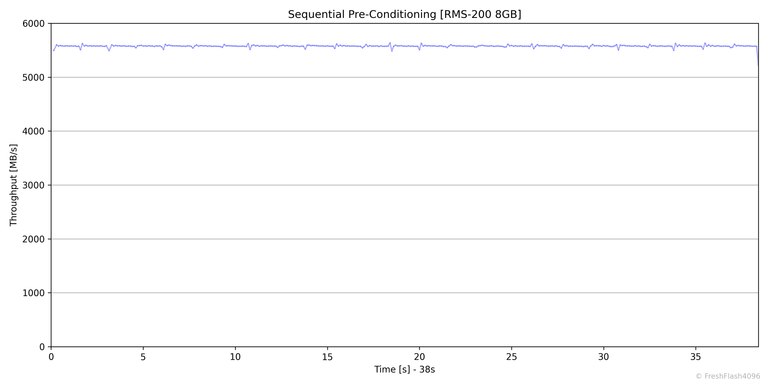

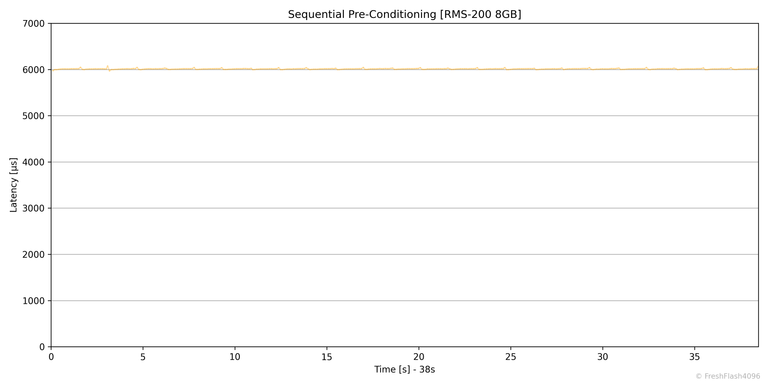

SEQ Pre-Conditioning

기울기가 ±10%인 상태를 30초간 유지하는 것이 제 벤치마크에서 Steady State의 조건입니다. 문제가 있다면, RMS-200은 30초가 되기 전에 드라이브를 여러 번 채울 수 있으며, 실제로 Steady State의 판별이 아닌, 드라이브 용량의 25배가 쓰기 작업으로 채워짐에 따라 성능 측정을 시작했습니다.

애초에 RMS-200이나 P4800X와 같은 SSD들은 Pre-Conditioning으로 별도의 쓰기 작업이 필요하진 않지만요.

결국, RMS-200의 25배가 되는 약 200GB를 채우는 데 38초가 소모되었으며, 평균 5577MB/s의 속도로 종료되었습니다.

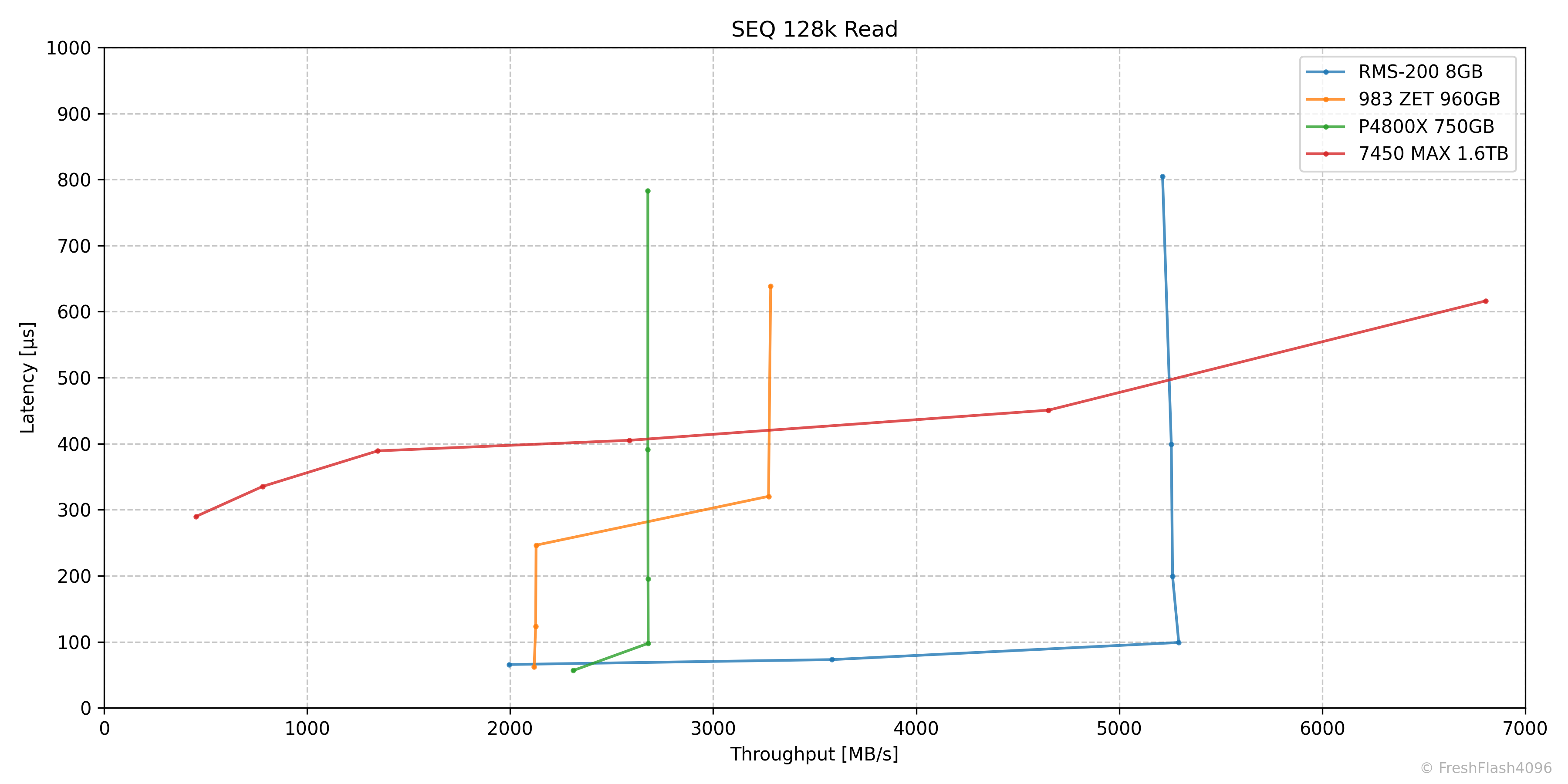

SEQ 128k Read

QD4에서 5293MB/s@99µs를 보여주며, 스펙 시트의 5.2GB/s를 만족한 모습이었습니다.

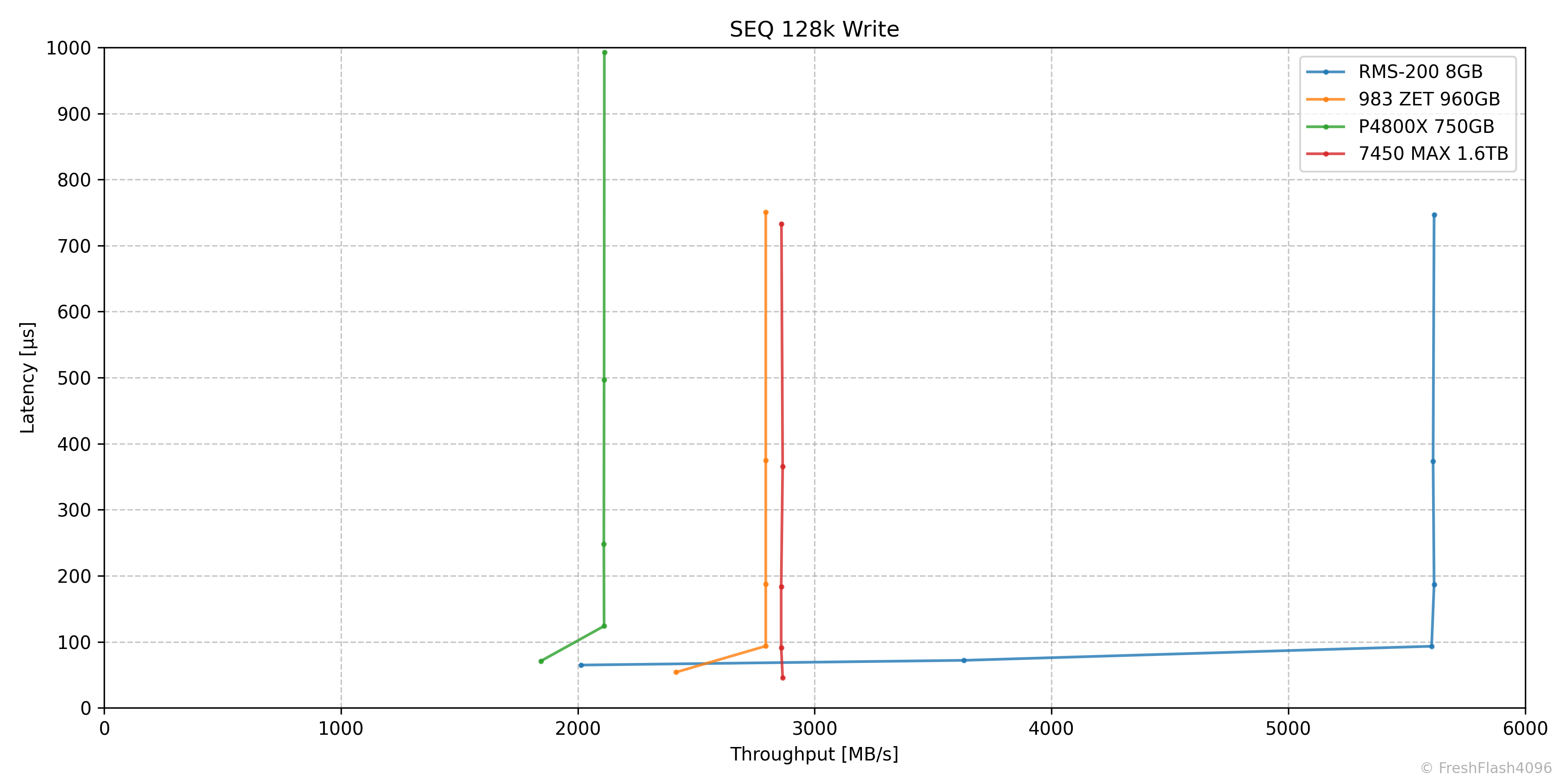

SEQ 128k Write

순차 읽기와 마찬가지로 QD4에서 5605MB/s@93µs가 측정되며, 스펙 시트의 5GB/s를 만족해주었습니다.

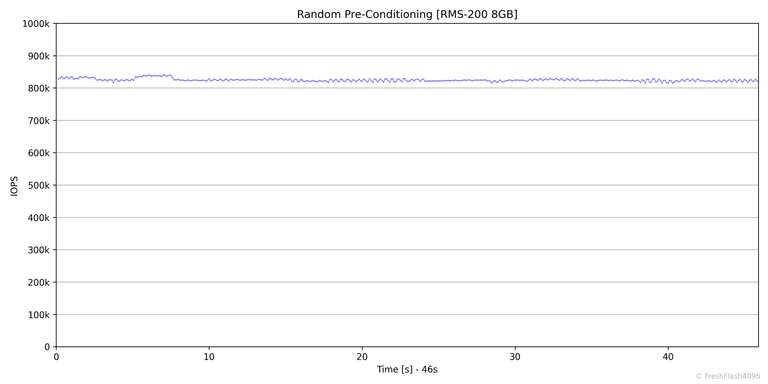

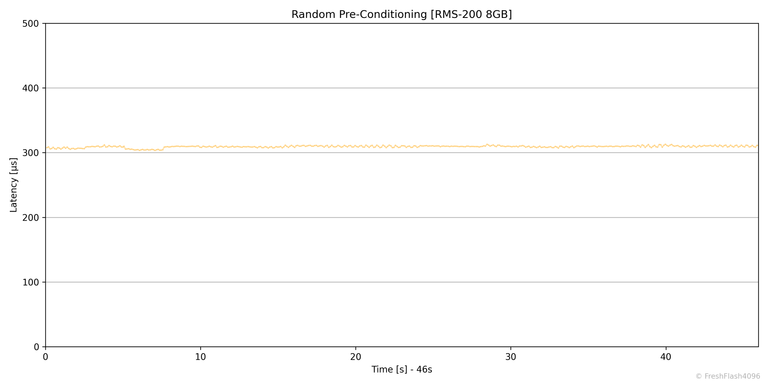

RND Pre-Conditioning

Pre-Conditioning이 필요하진 않지만, 여기선 속도가 조금 더 오래 걸려서(46초) Steady State 판단을 제대로 수행했습니다. 823k IOPS로 진입합니다.

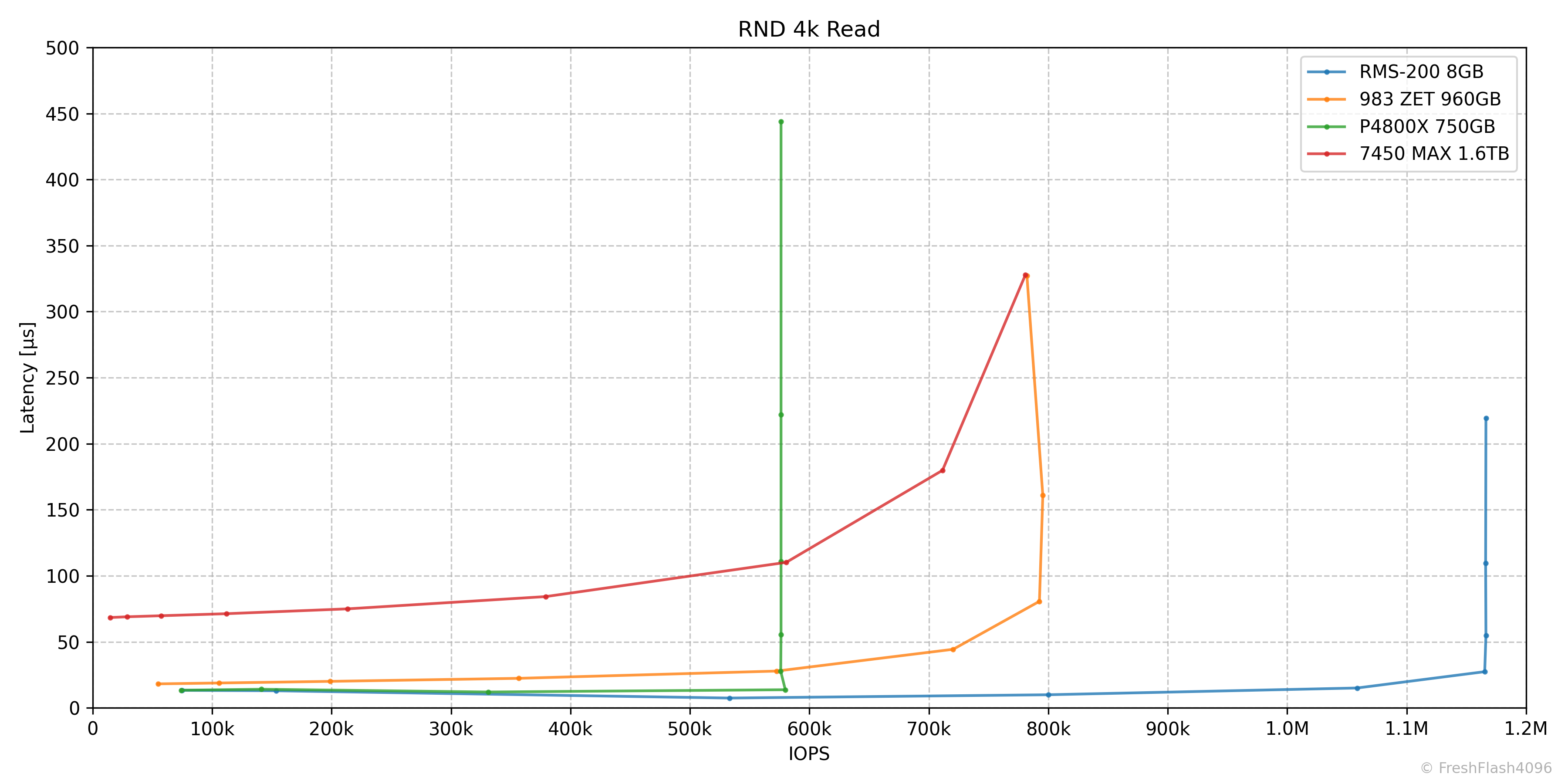

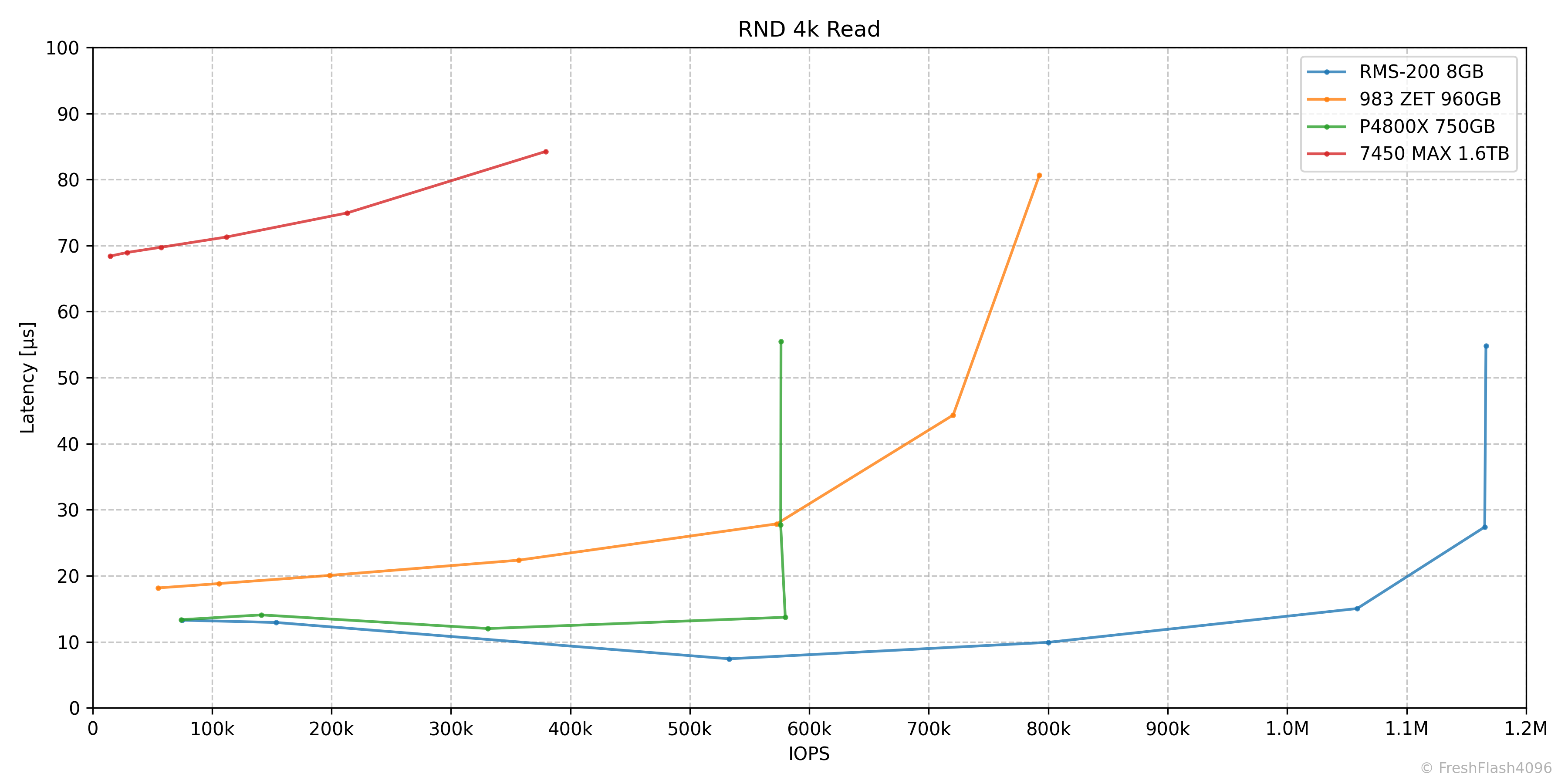

RND 4k Read

스펙시트의 1M IOPS 주장은 QD32에서 1165k IOPS@27µs가 측정되며 충분히 만족할 수 있었습니다.

Low QD에 대해서 자세히 확인하기 위해서 최대 지연시간을 100µs로 줄인 그래프입니다.

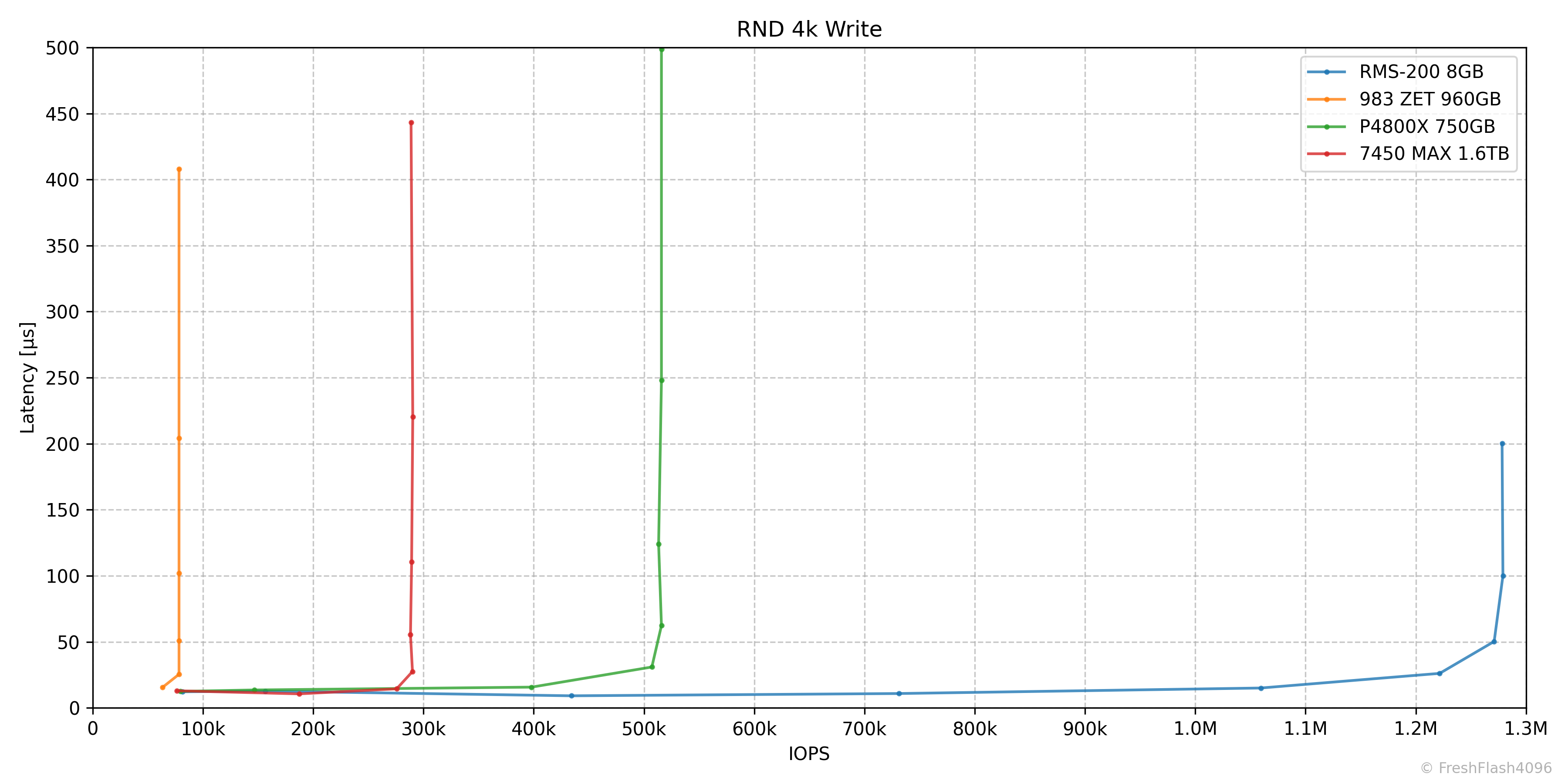

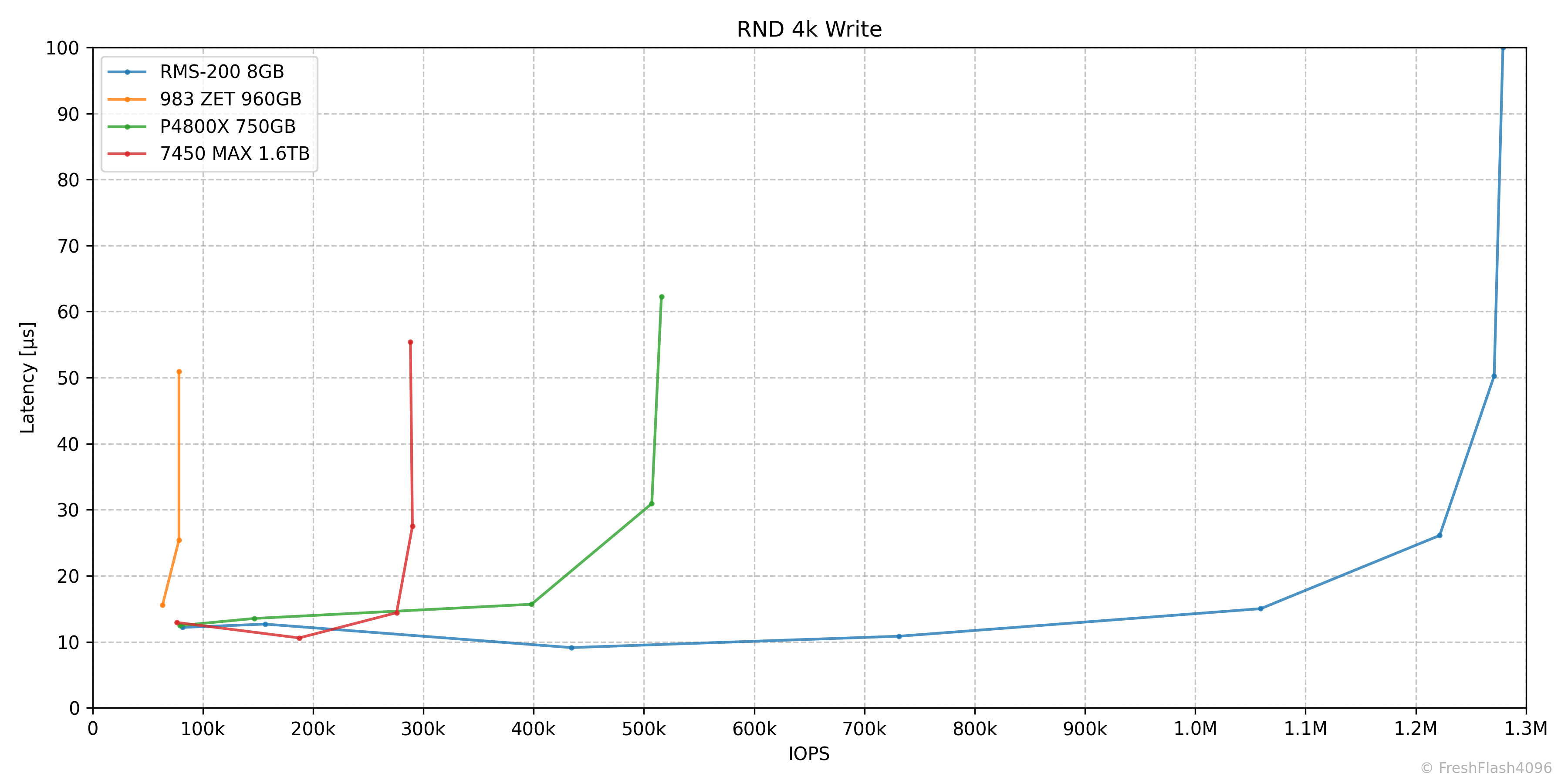

RND 4k Write

QD64에서 1271k IOPS@52µs, QD128에서는 1279k IOPS@99µs가 측정되었습니다. 역시 스펙시트의 900k IOPS를 상회하는 모습입니다.

Low QD에 대해서 자세히 확인하기 위해서 최대 지연시간을 100µs로 줄인 그래프입니다.(2)

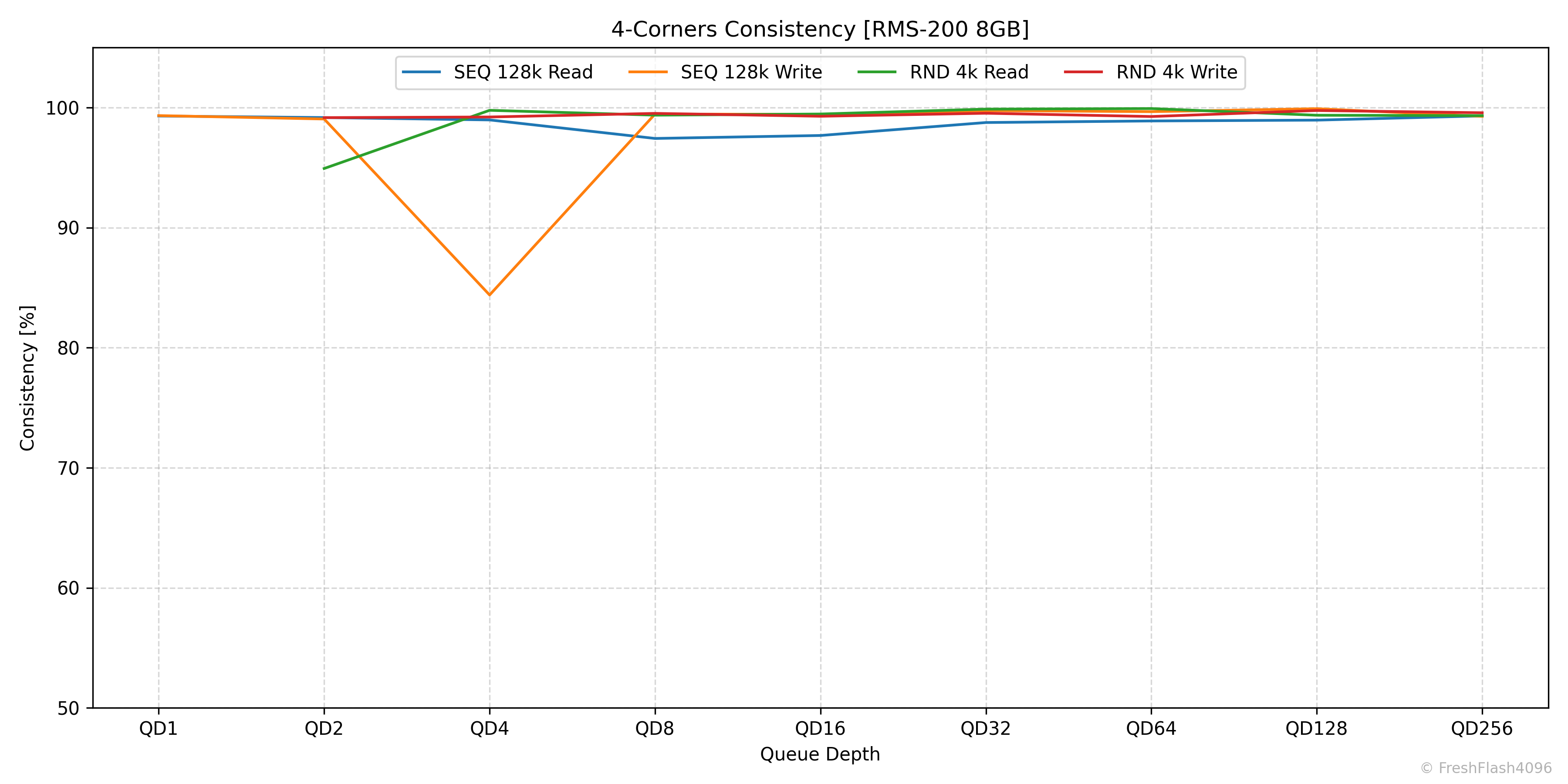

4-Corners Consistency

QD에 따른 4-Corners Performance의 안정적인 정도를 제시합니다. 상위 99.9%값과 평균을 이용하는데, SEQ 128k에서는 Bandwidth를 기준으로, RND 4k에서는 IOPS를 기준으로 계산합니다. 참고로, RND 4k에서 QD1에 대한 값은 이후 Tail Latency에서 자세히 살펴보기에 제외됩니다.

QD4에서의 순차 쓰기의 일관성이 약간 떨어졌지만, 그 외엔 굉장히 우수한 일관성을 보여줍니다.

Specific Workload Performance

4-Corners Performance가 아닌 워크로드를 분리했습니다. 단, 워크로드 이름은 편의상 붙인 것뿐이며, 실제 환경에서는 다양한 Block Size와 RW 비율이 나타난다는 것을 명심해야 합니다. Block Size들의 정확한 비율과 RW 비율을 결정하기 힘들어 대략 분류한, 가상의 워크로드입니다.

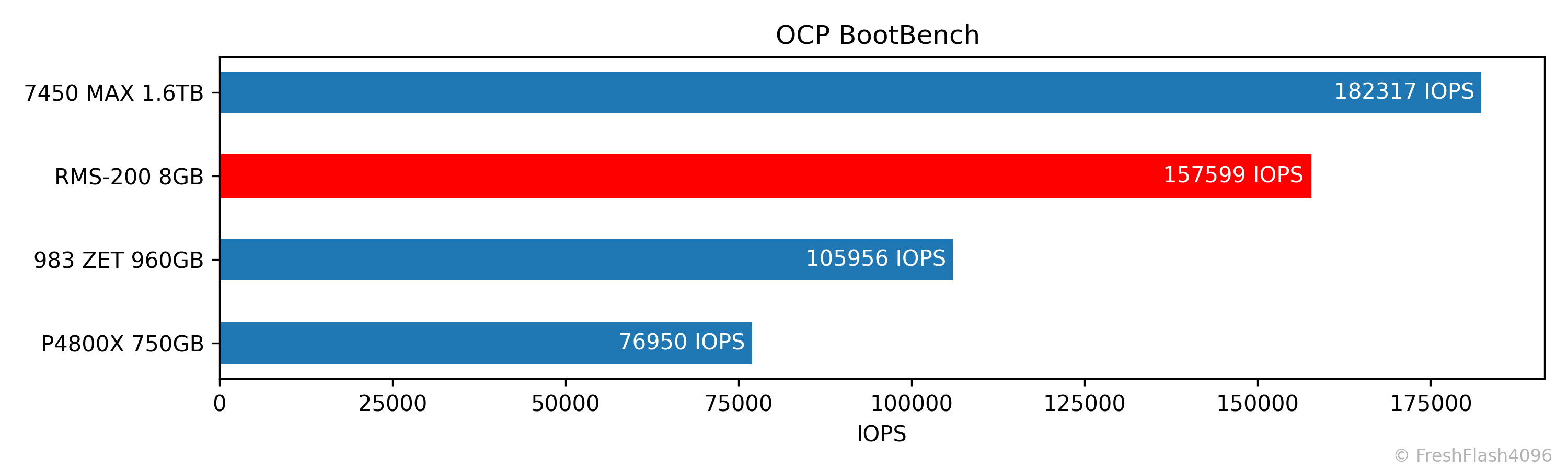

Boot Workload (OCP BootBench)

Hyperscale에서의 Boot Drive로 사용될 때의 성능을 측정하는 벤치마크입니다. SEQ Write로 User Capacity가 2번 채워지면, 동기 쓰기, TRIM, 읽기가 동시에 가해지며, 결과의 지표는 읽기 IOPS입니다. 60k IOPS를 통과하면 합격입니다.

PCIe 3.0 x8의 대역폭을 잘 사용한 모습입니다. 동시에, PCIe 4.0 x4의 SSD에는 밀리는 모습이네요.

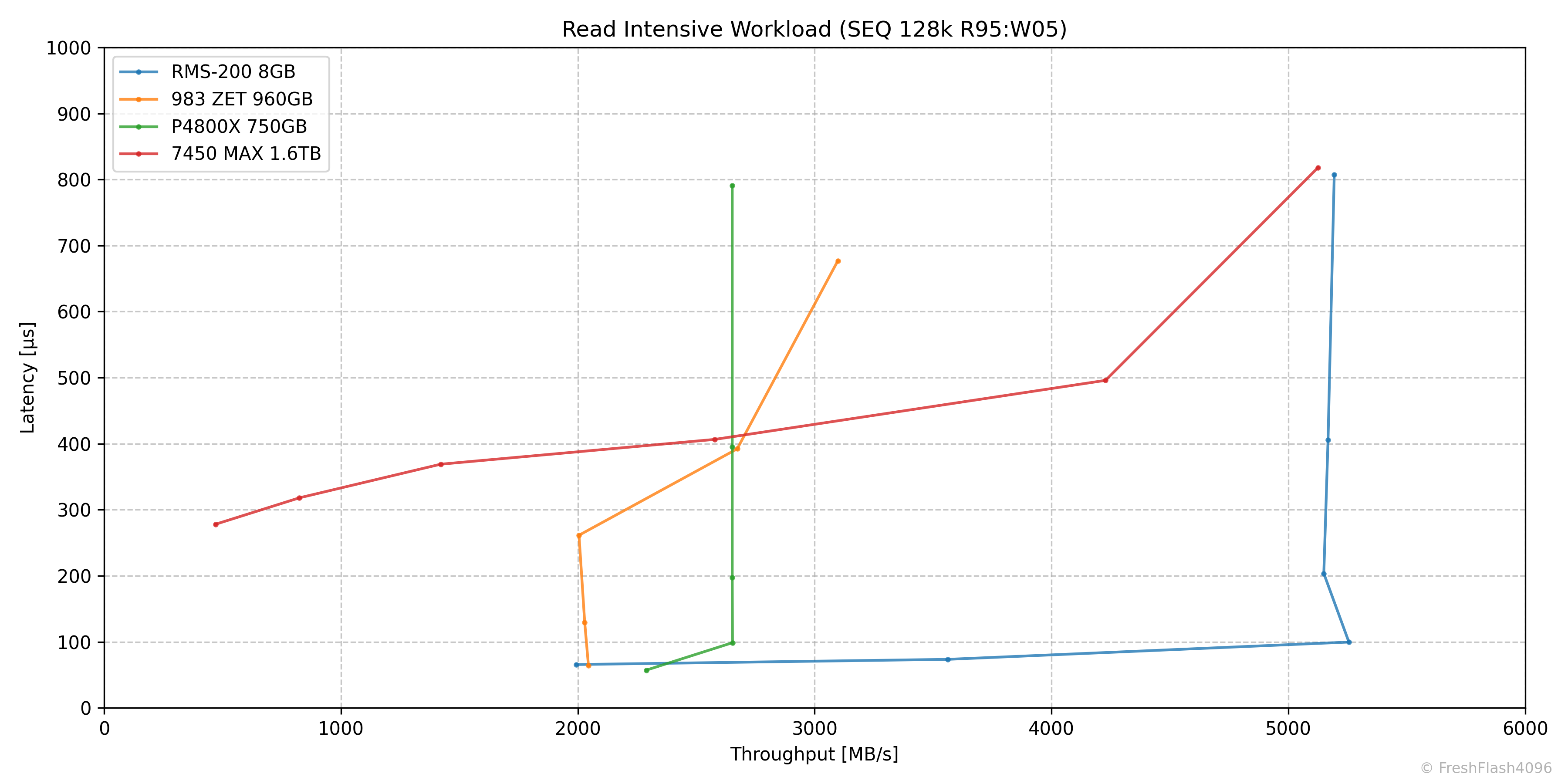

Read Intensive Workload (SEQ 128k R95:W05)

읽기 집약 워크로드는 QD4에서 5256MB/s@100µs가 측정되었습니다.

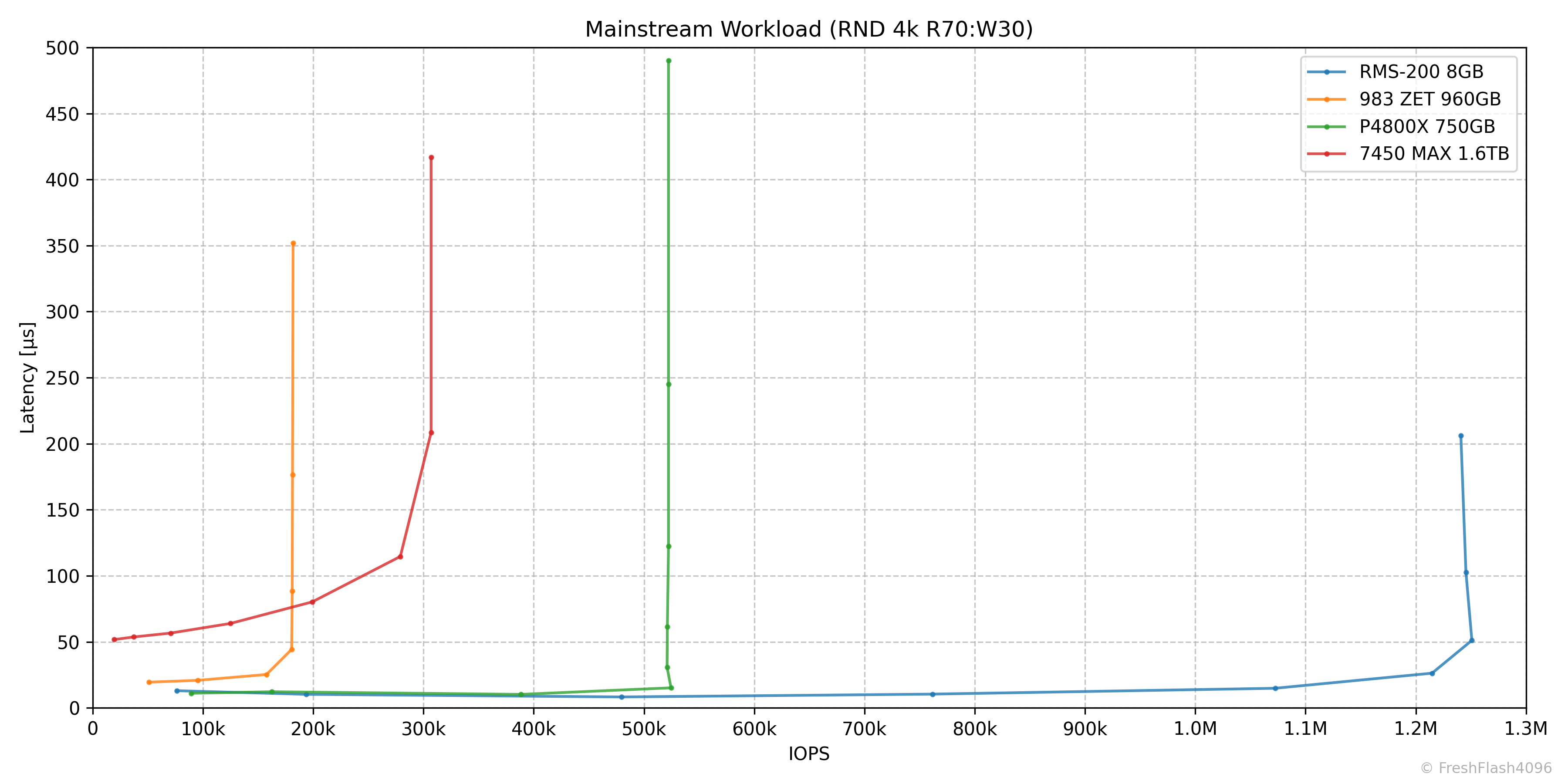

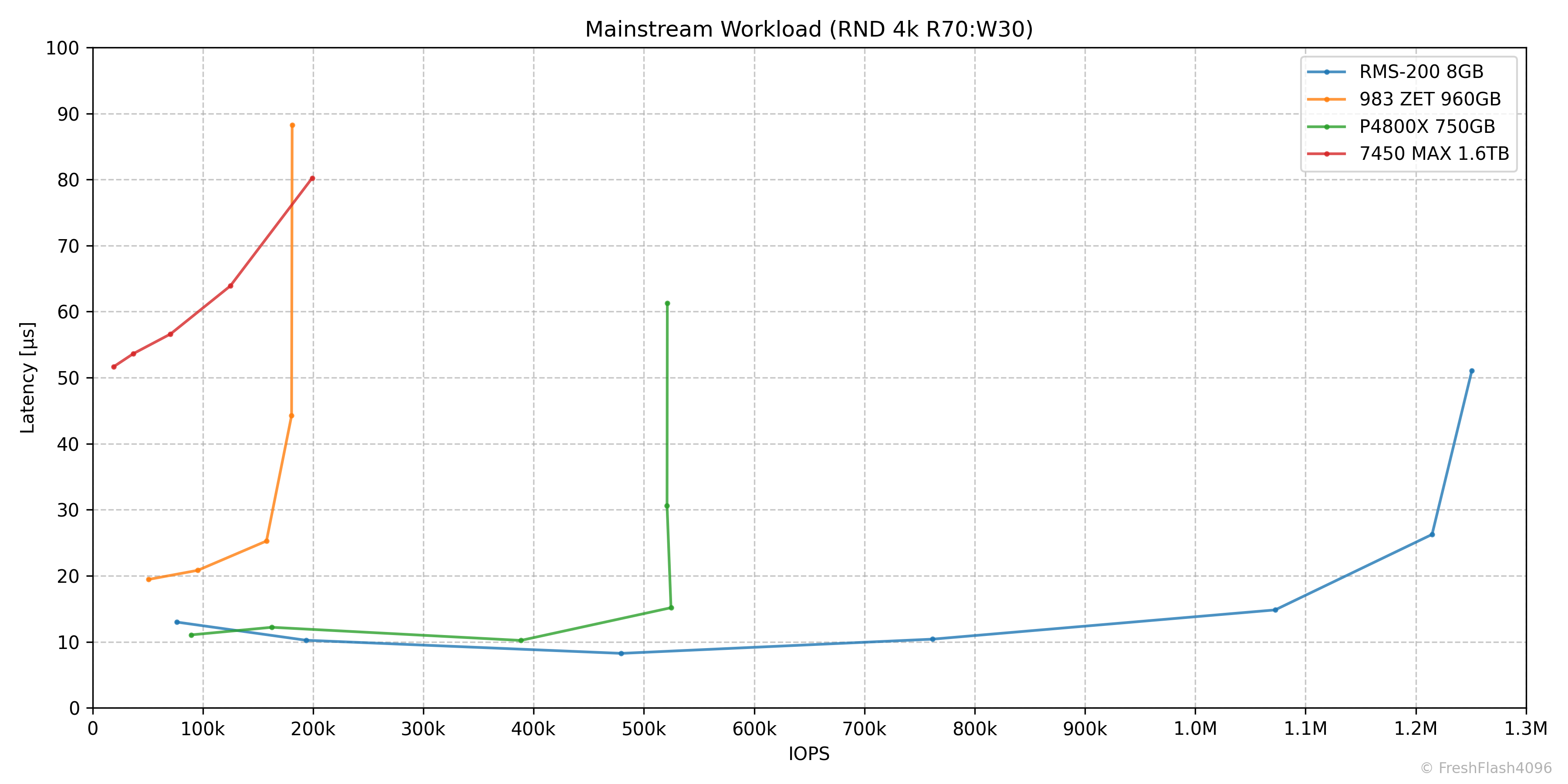

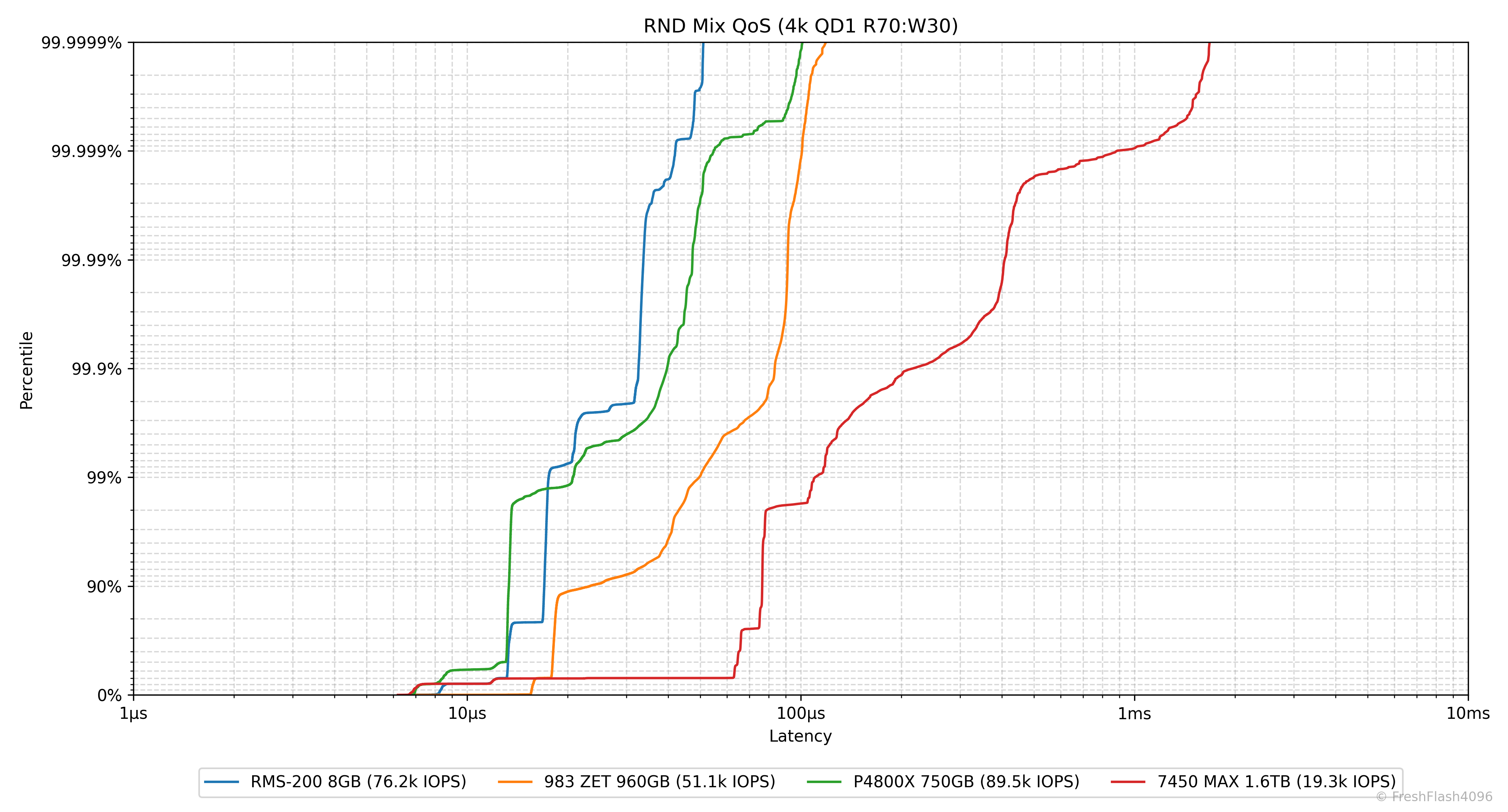

Mainstream Workload (RND 4k R70:W30)

메인스트림 워크로드는 QD64에서 1251k IOPS@53µs가 측정되었습니다.

Low QD에 대해서 자세히 확인하기 위해서 최대 지연시간을 100µs로 줄인 그래프입니다.(3)

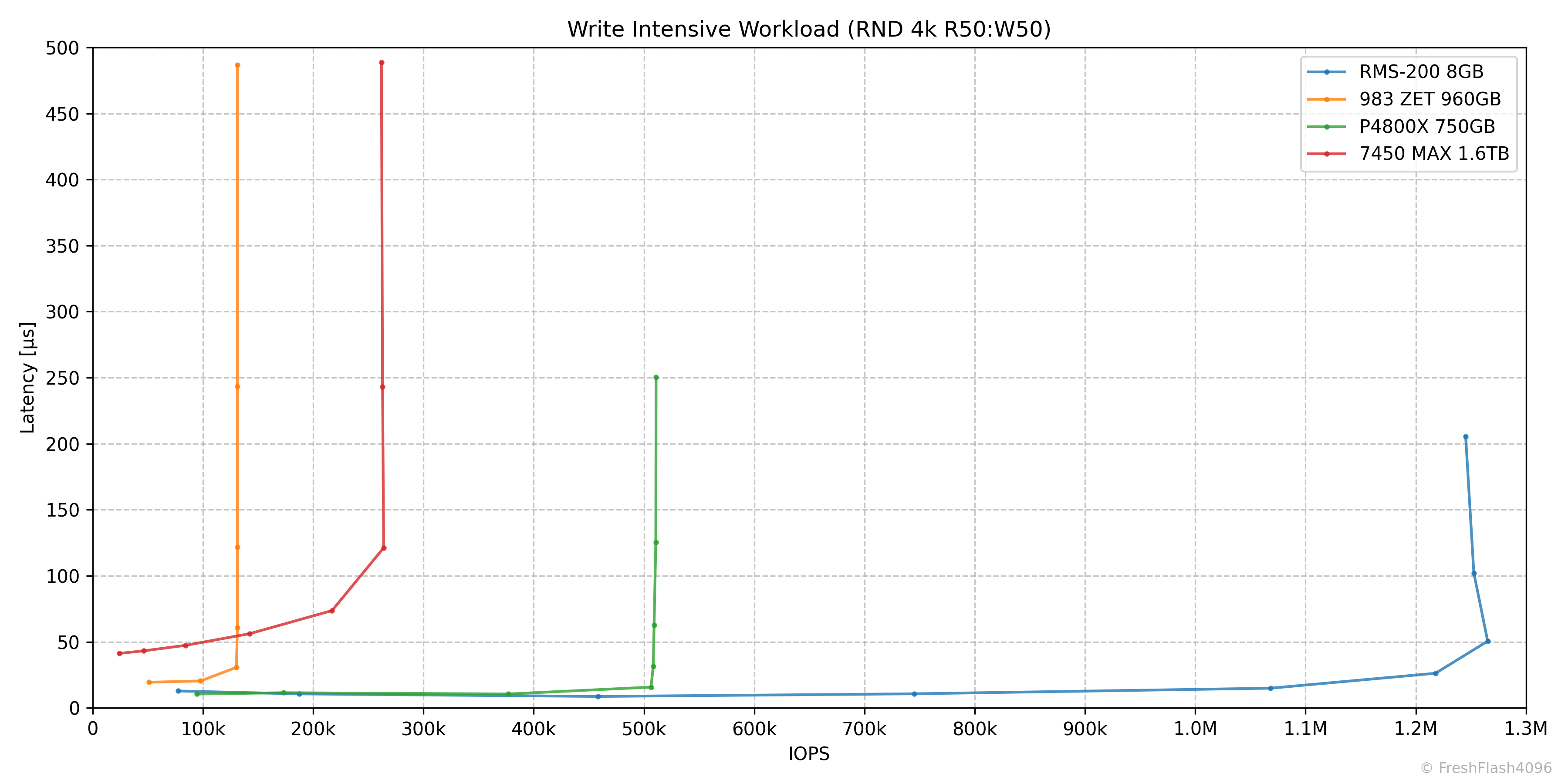

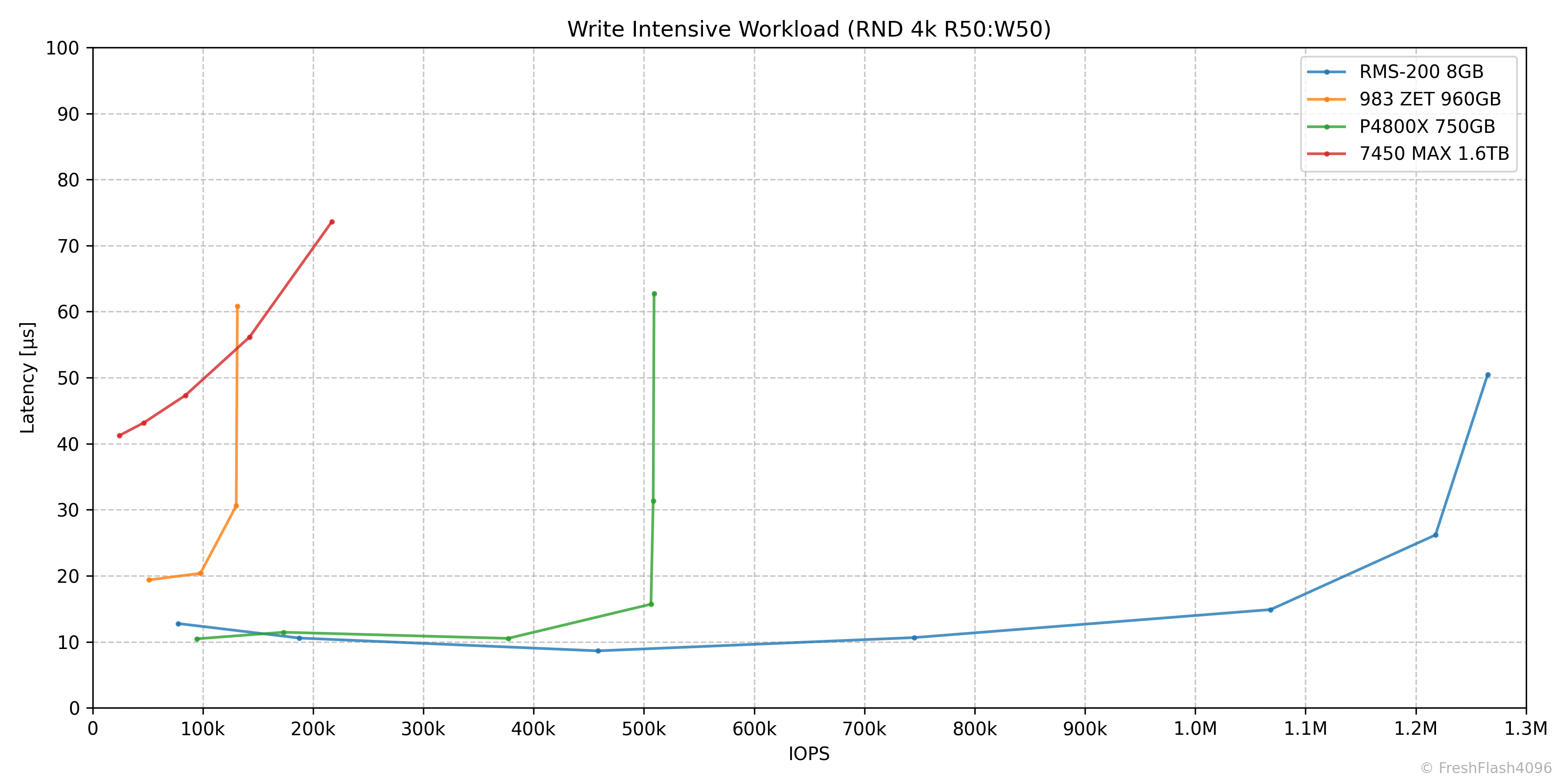

Write Intensive Workload (RND 4k R50:W50)

쓰기 집약 워크로드는 QD64에서 1265k IOPS@51µs가 측정되었습니다.

Low QD에 대해서 자세히 확인하기 위해서 최대 지연시간을 100µs로 줄인 그래프입니다.(4)

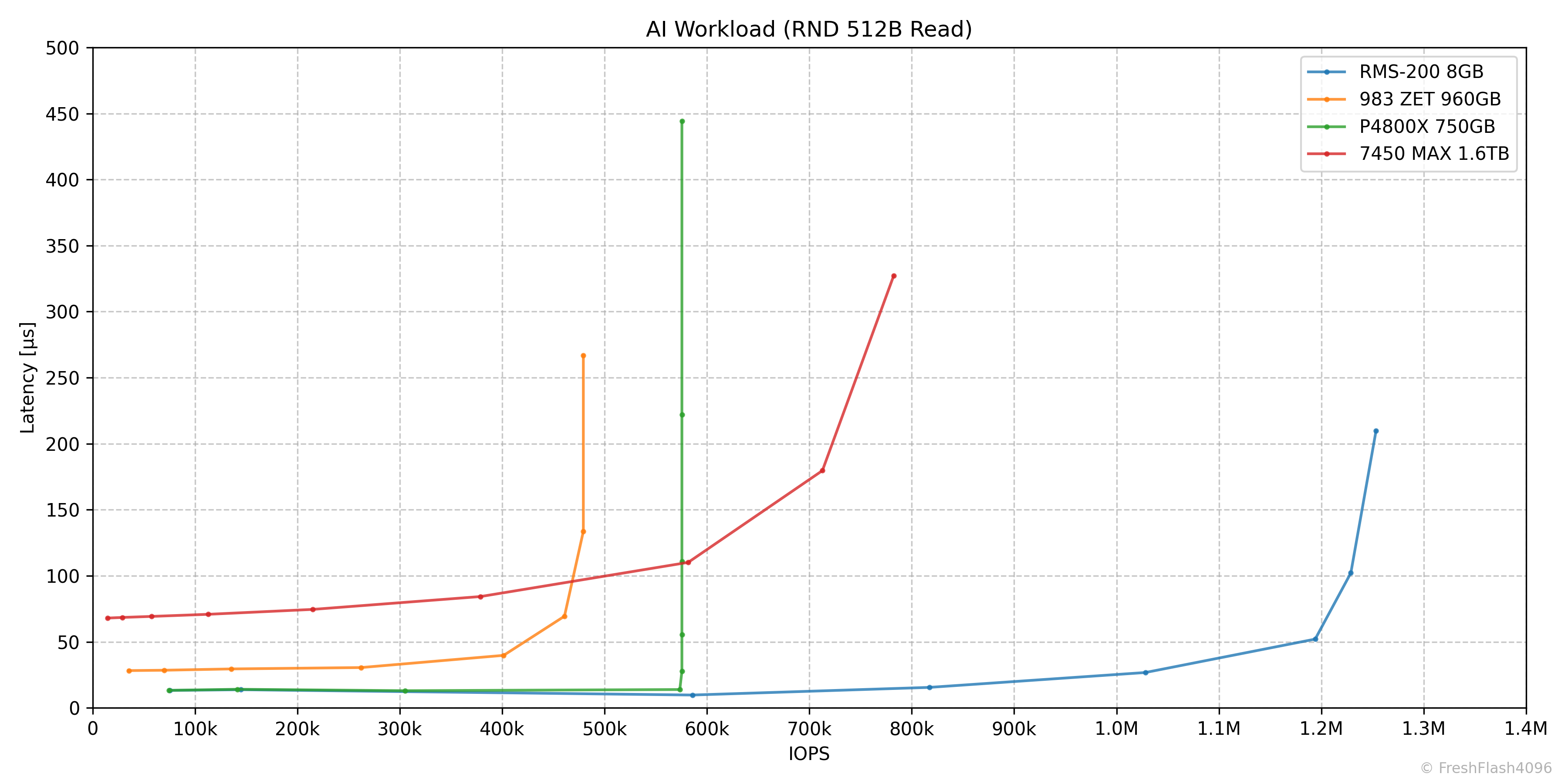

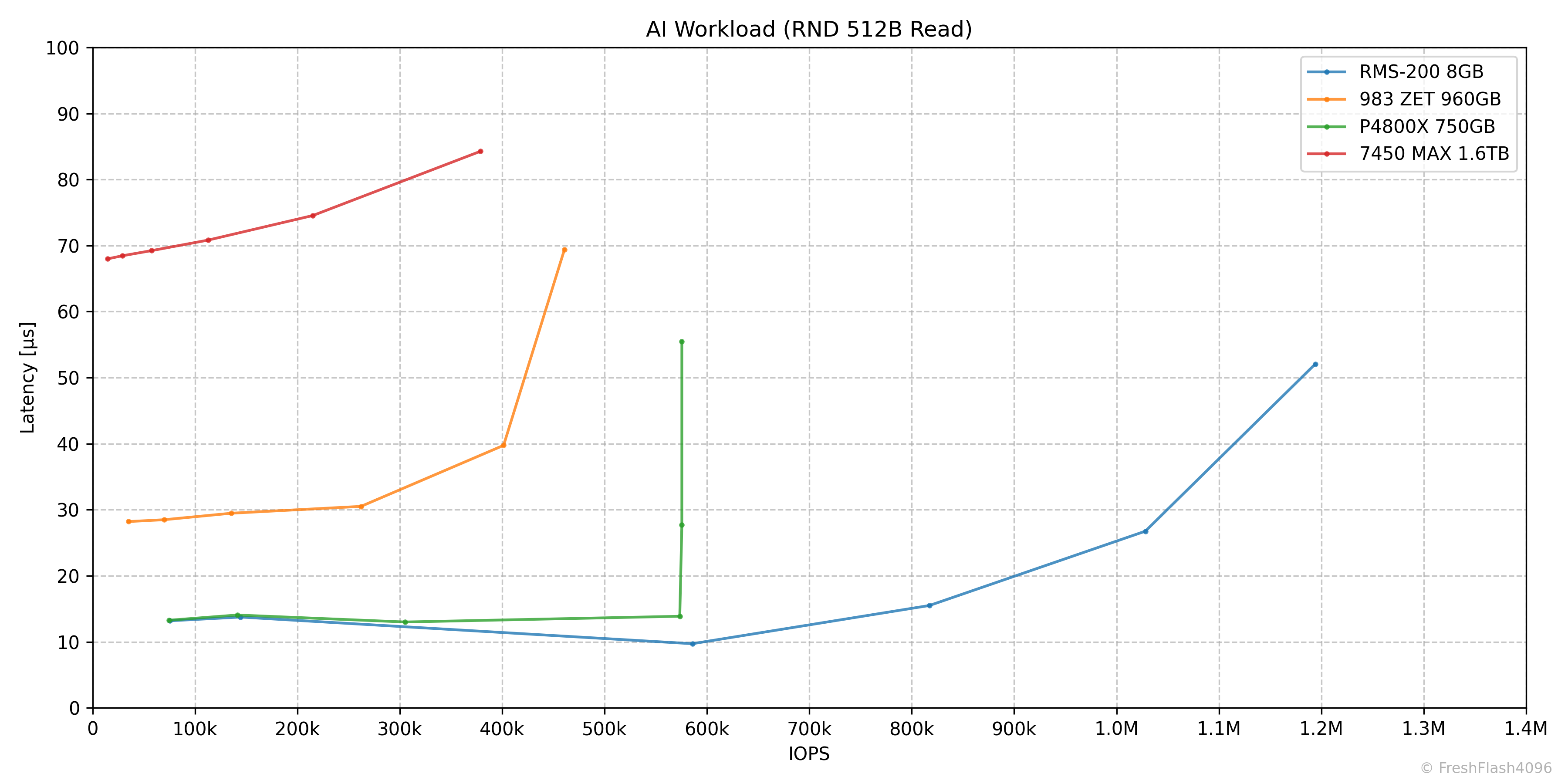

AI Workload (RND 512B Read)

AI 워크로드에서는 QD128 1252k@102µs가 측정되었으며, 이는 4k 랜덤 읽기의 최대 성능으로 측정된 1166k IOPS를 초과하는 값입니다.

Low QD에 대해서 자세히 확인하기 위해서 최대 지연시간을 100µs로 줄인 그래프입니다.(5)

QD4에서의 성능이 P4800X의 QD8 성능보다 우수한 것이 눈에 띕니다.

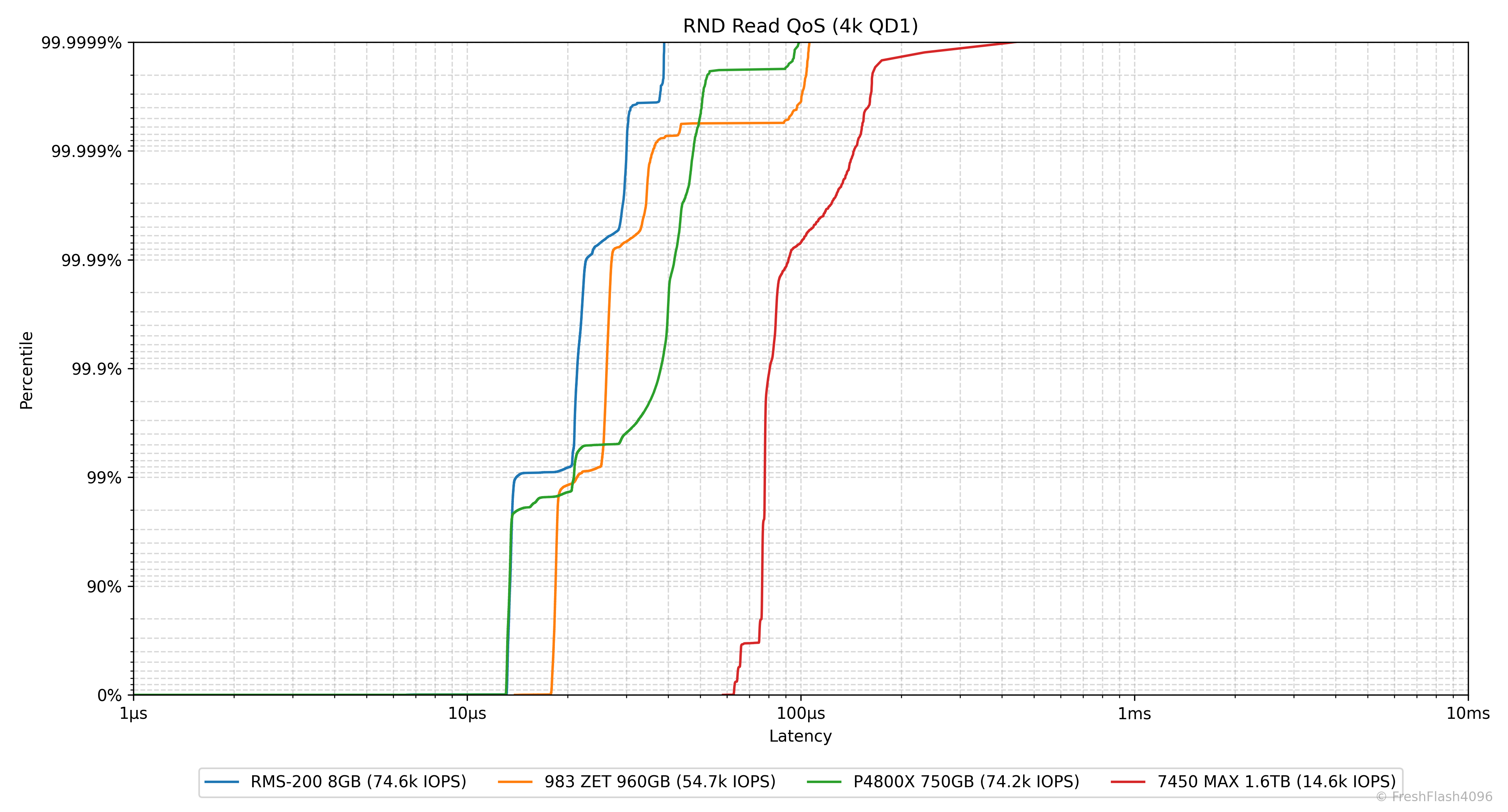

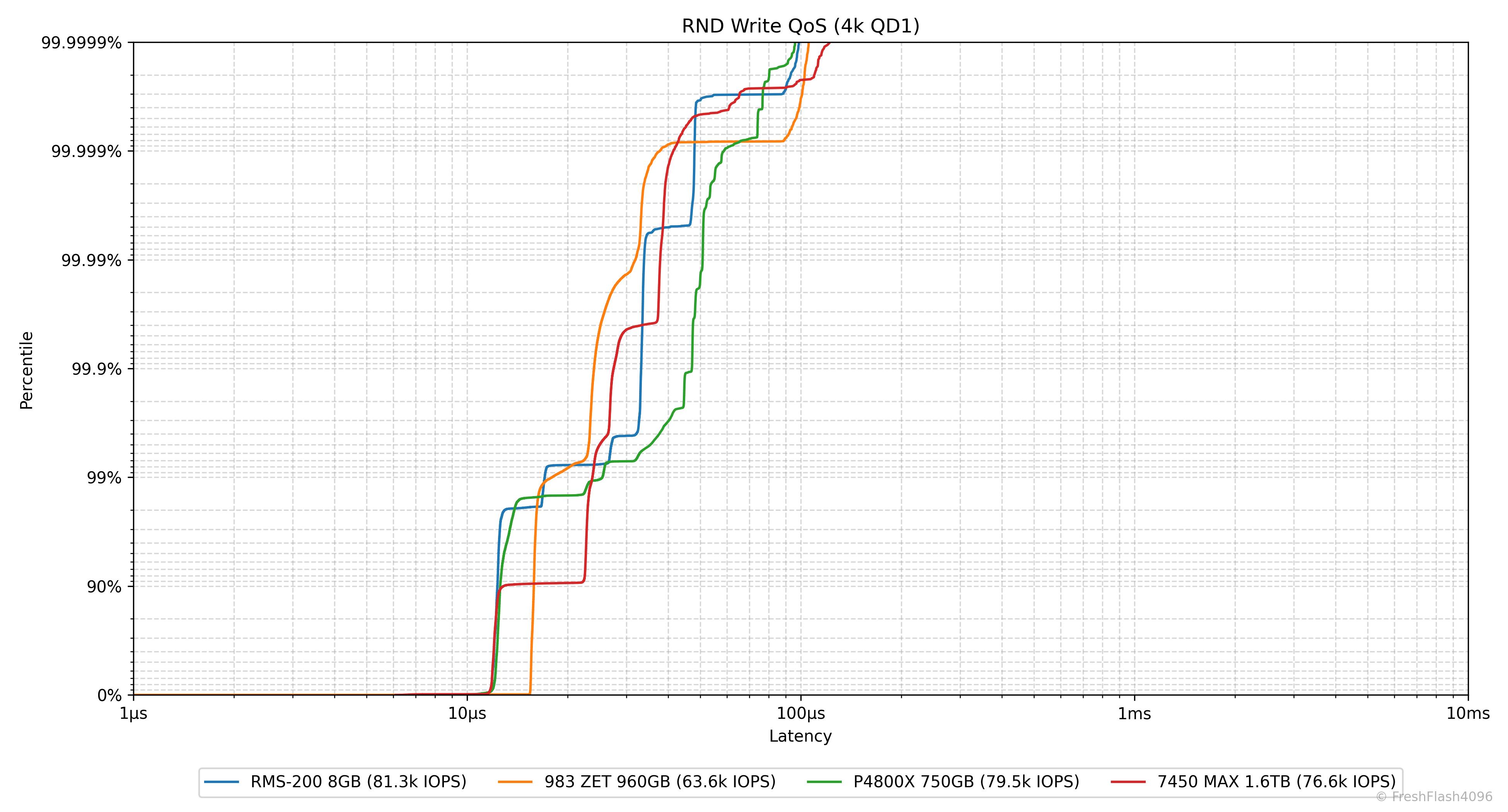

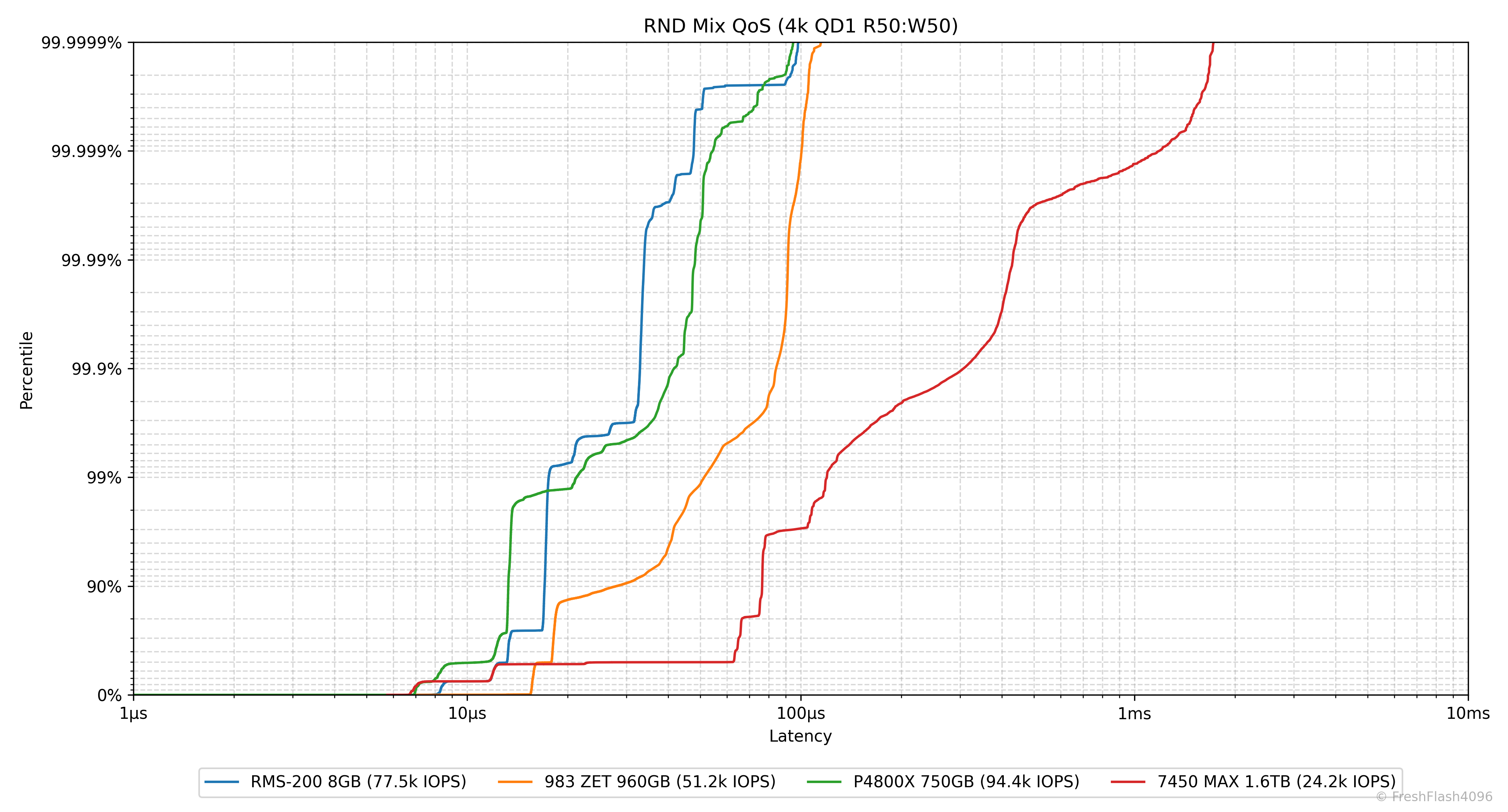

Random 4k QD1 Tail Latency

Latency에서 가장 느린 구간을 의미합니다. 그렇기 때문에 QoS(Quality of Service)에 큰 영향을 미치고, 실제로 eSSD의 데이터시트에서는 QoS를 명시하고 있습니다.

여기에선 100ms나 10ms 단위가 아닌, 모든 개별 I/O에 대한 지연시간을 카운트하여 그래프를 그립니다. 그렇기 때문에 데이터가 상당히 방대해, 이 항목은 RND 4k QD1에 대해서만 진행합니다.

랜덤 읽기의 QoS는 독보적으로 우수합니다. 혼합 작업이 발생하면 P4800X와 유사하지만, NAND SSD들에 비해선 여전히 우수한 모습을 보이고, 쓰기 작업에선 다른 SSD들과 비슷한 모습을 보입니다.

| RMS-200 8GB | RND 4k Read QD1 | RND 4k Write QD1 |

| Typical Value | 13.22 µs | 11.99 µs |

| QoS (99.9%) | 21.37 µs | 33.21 µs |

| QoS (99.99%) | 22.73 µs | 33.89 µs |

| QoS (99.999%) | 30.02 µs | 47.97 µs |

| RMS-200 8GB | RND Mix (R70:W30) QD1 | RND Mix (R50:W50) QD1 |

| Typical Value | 13.24 µs | 13.15 µs |

| QoS (99.9%) | 32.61 µs | 32.94 µs |

| QoS (99.99%) | 33.73 µs | 33.92 µs |

| QoS (99.999%) | 42.00 µs | 47.70 µs |

데이터시트에는 별도의 QoS 사양이 지정되지 않았습니다. 따라서 간략하게 벤치마크의 결과를 요약합니다.

아무리 봐도 제 벤치마크 결과에서 RND 4k Read의 지연시간이 10µs 이하로 내려가기 힘든 것은 제 테스트베드의 한계가 아닌가 싶습니다. 아예 볼 수 없던 것은 아니지만, 다른 플랫폼에서도 테스트를 진행해 볼 필요가 있어 보입니다.

Closing

사실, RMS-200은 가장 쉽게 구할 수 있는 HW 기반의 램디스크라고 생각합니다. NVMe 사양을 만족하기에 별도의 드라이버 없이 바로 사용할 수 있는 것도 장점이죠. 성능도 램디스크답게 좋습니다. 아쉬운 부분이라면 역시 용량이 아닐까 합니다. 8GB의 용량은 뭔가 해보기가 힘들죠.

해당 드라이브의 적절한 사용법은 제조사에서 말하는 대로 "Caching, Write-Ahead Logging, Journaling"입니다. 이는 본래의 의도된 사용 방법이기도 하지만, 개인도 이러한 용도가 아니면 쓰기 힘들어 보이는 용량이죠. 이 제품을 사용하는 일반 소비자가 있다면, ZFS SLOG로 사용하지 않을까 합니다. 최적의 사용 사례죠.

후속작으로 DDR4를 이용한 RMS-300 등도 출시되었지만, 최근에 와서야 RMS-300이 겨우 매물로 보이며, 가격도 아직 비싼 편입니다. RMS-375나 이를 기반으로 두고 있는 Viking VT-PM 시리즈는 보이지 않고요.

램디스크를 사용해 보고 싶으신 분은 RMS-200의 가격이 제가 구매했을 때보다도 내려간 상태라 장난감으로는 나쁘지 않다고 생각합니다.

Radian Memory Systems는 eSSD에 관심이 있으신 분들도 약간 생소할 기업입니다. 최근에는 특허 관련 소송으로 삼성과 기사가 났기에 한 번쯤은 들어보신 분도 계시겠지만요. 이 회사가 하는 걸 전체적으로 다루기엔 글의 내용이 너무 길어질 테니 나중에 다시 다루어보겠습니다. 궁금하신 분들은 홈페이지를 직접 방문하시면 좋을 것 같은데, ZNS, FTL, Open-Channel SSD에 대해서 어느 정도 개념을 가지고 있다면 어떤 기업인지 파악하는 데 도움이 될 것입니다.

2026년의 첫 리뷰는 계획하던 것보다 조금 길어졌네요. 앞으로는 특별한 일이 없다면 조금씩 단축될 것 같습니다. 읽어주셔서 감사합니다.

재미 삼아 진행한 SW 램디스크와의 비교는 이른 시일 내로 업로드될 예정입니다.

Comments