백금디스크 [P51 2TB]

일반 소비자 시장에서 SSD와 관련된 기업이라고 한다면, 삼성, 하이닉스, WD(이었던 것)이 가장 먼저 나올 것이라고 생각합니다. 마이크론도 있었지만, Crucial 브랜드의 종료를 선언했으니 이제 놔줍시다. 이것이 소비자용 시장과의 결별을 뜻하는 것은 아니지만, 어느 정도 거리감은 생겼을 것이라고 보이니까요.

아무튼, 그중에서 하이닉스는 다른 기업들과 비교할 때, 꽤 최근에 P31이라는 제품을 통해 일반 소비자와 접하게 되었습니다. 이후 PCIe 4.0의 P41, PCIe 5.0의 P51이란 제품으로 만날 수 있었는데요, 최신 제품이 나와도 개인 리뷰어가 바로 테스트하긴 약간 어렵습니다. 비싸니까요... 웃기지만 제가 eSSD들을 구매하는 이유 중 하나는 가격이 저렴하다는 부분입니다. 저도 U.2가 아니라 M.2 폼팩터의 8TB SSD 쓰고 싶어요.

뜬금없지만, 저의 9600X 기반 시스템은 PCIe 5.0 SSD의 테스트를 염두에 두고 구축했습니다. 하지만, 제가 지금까지 유의미하게 테스트할 수 있었던 것은 PM9E1 1TB 뿐. 이 친구의 리뷰를 마친 뒤, PCIe 5.0 SSD들의 가격이 내려가기를 기다렸습니다.

그때 살 "껄"

지금은 SSD의 추가 구매를 중단했습니다. 테스트 시스템도 쉬었음 시스템이 되리라고 확신했죠. 내 돈과 시간을 갈아넣는 자기만족인데 전부 처분하고 아이스레이크 기반의 서버와 PCIe 4.0에 만족하며 살까 싶었습니다.

갑작스럽게 날아온 메일. 어느 멋진 분께서 P51을 지원해 주신다는 내용이었습니다. 라벨 제거를 진행하지 않는 조건 하에 읽쓰기량은 크게 신경쓰지 않으시는 것 같더라고요.

플래그십 PCIe 5.0 SSD를 테스트할 수 있다는 기대감에 두근두근했습니다.

목차

Appearance

중고가 아닌, 완전히 새 제품으로 도착한 P51입니다. 컴퓨존에서 주문하실 때 도착지에 제 주소를 넣으신 것을 보고 상당히 당황했던 기억이 아직도 납니다. 별로 오래되지도 않았지만요.

주인보다 제가 먼저 개봉한다는 죄책감 1할, 새 SSD의 포장을 뜯는 것이 오랜만이라 두근두근감 9할로 제품을 개봉했습니다.

박스의 아래쪽에는 시리얼 번호를 비롯한 정보가 기재되어 있습니다.

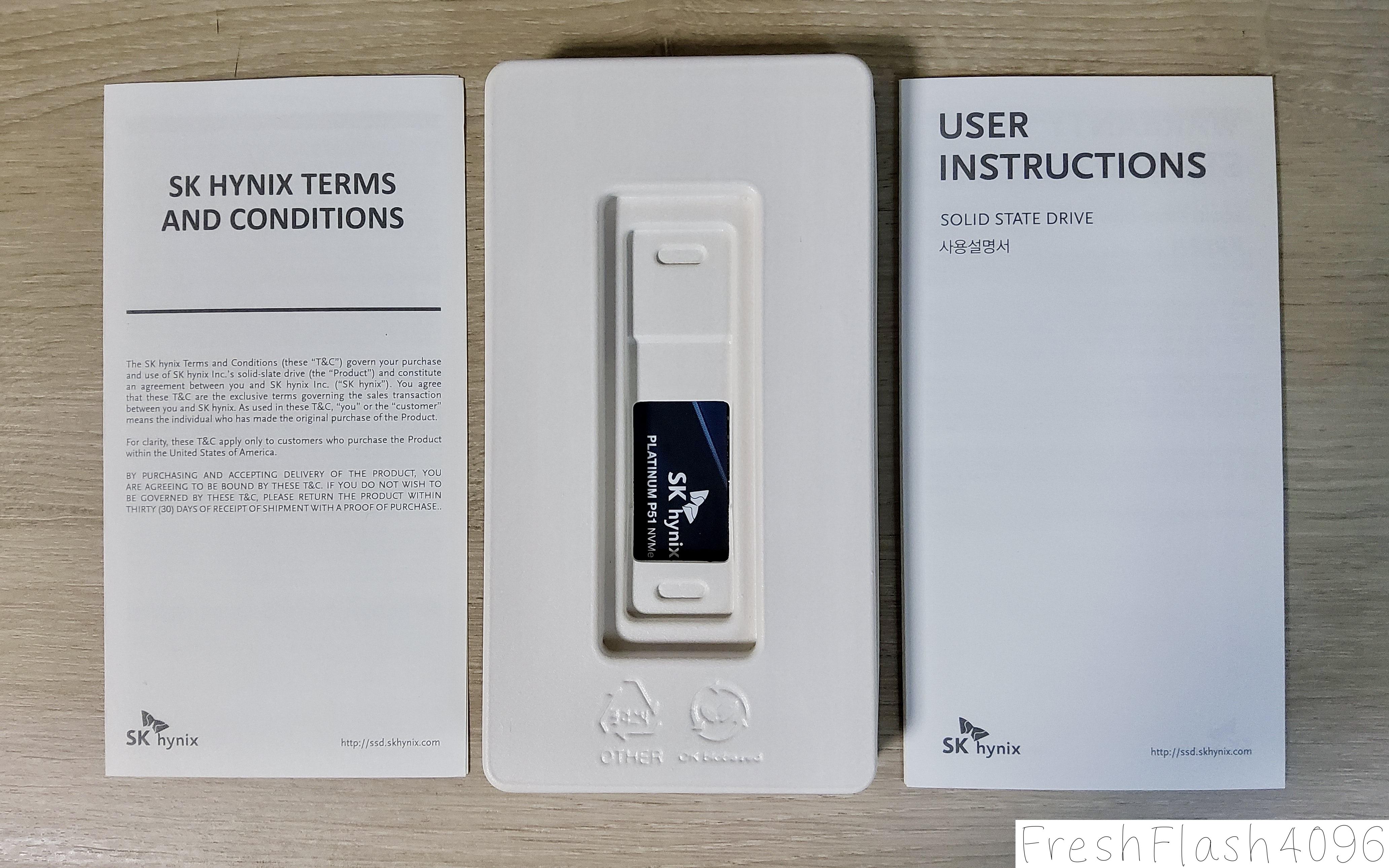

내용물은 많은 사람들이 읽지 않을 종이 2장과 본품입니다.

동일한 Platinum의 라인업이지만, P41이 보라색 계열의 라벨을 채택한 반면, P51은 파란색 계열의 라벨을 채택했습니다.

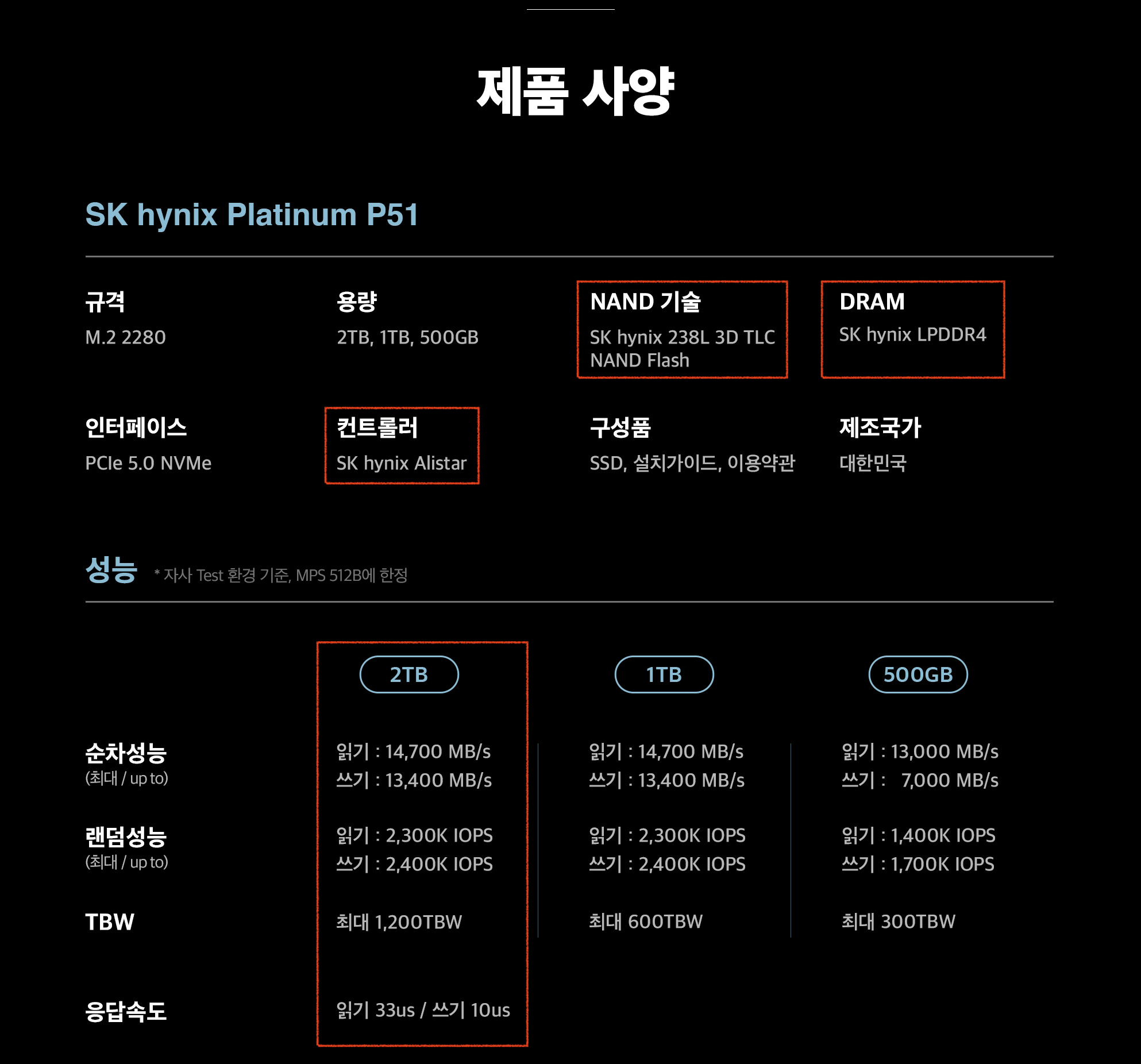

Datasheet

라벨을 제거할 수는 없지만, 홍보자료를 통해 대략적인 것을 확인할 수 있습니다. 간단하게 살펴보죠.

컨트롤러는 SK hynix Alistar를 사용했습니다. ARM Cortex-R8 코어와 TSMC 7nm의 공정을 사용했으며, 8채널 컨트롤러입니다. 삼성의 Presto와 달리, Alistar는 엔터프라이즈에도 일부 적용되었으며, PEB110이라는 E1.S 폼팩터의 eSSD로 만날 수 있습니다.

참고로, PEB110에서는 P51과 다르게 1.92TB로 시작해 최대 7.68TB의 용량을 제공합니다.

DRAM은 SK hynix LPDDR4입니다. 일반적으로 생각하면 2GB 모델이라고 생각됩니다. 자세한 분해 정보는 국내 커뮤니티들의 리뷰나 해외 리뷰를 통해 찾아볼 수 있겠으나, 제 리뷰에선 항상 하던 대로 제가 가진 자료를 기반으로 정리하기에 생략하겠습니다.

NAND는 SK hynix 238L 3D TLC NAND라고 적혀있는데, SK hynix V8 TLC라고 할 수 있겠습니다. 이 세대는 512Gb Die만 사용되었던 점과 P51 2TB에는 NAND 패키지가 2개 있는 것에서 각각 16개의 Die를 패키징했다는 것을 알 수 있습니다.

이를 통해서 NAND의 파트넘버를 역으로 유추하자면, H25T3TDG8C라고 예상됩니다. 119L *2의 구조와 Toggle 5.0 2400MT/s의 인터페이스를 가집니다.

그런데, 그렇게나 적극적으로 진행하던 4D NAND Flash 마케팅은 포기한 것일까요? PUC인 점은 V5와 같은데 말이죠.

그 외에는 용량에 따른 성능을 표기하고 있습니다. "MPS 512B에 한정"은 PCIe의 Max Payload Size로 보입니다. cSSD 홍보자료에서 이런 용어를 보게 될 줄은 몰랐는데 말이죠.

Notable Points

No ESD bag

P41은 만져볼 기회가 없어서 모르겠지만, P31은 제전 비닐을 이용해 한 번 더 제품을 감싸놓았던 기억이 있습니다. 하지만 P51은 그런 것 없이 그냥 고이 모셔두기만 했네요.

크게 중요하진 않지만, 조금은 아쉽습니다.

SW Report

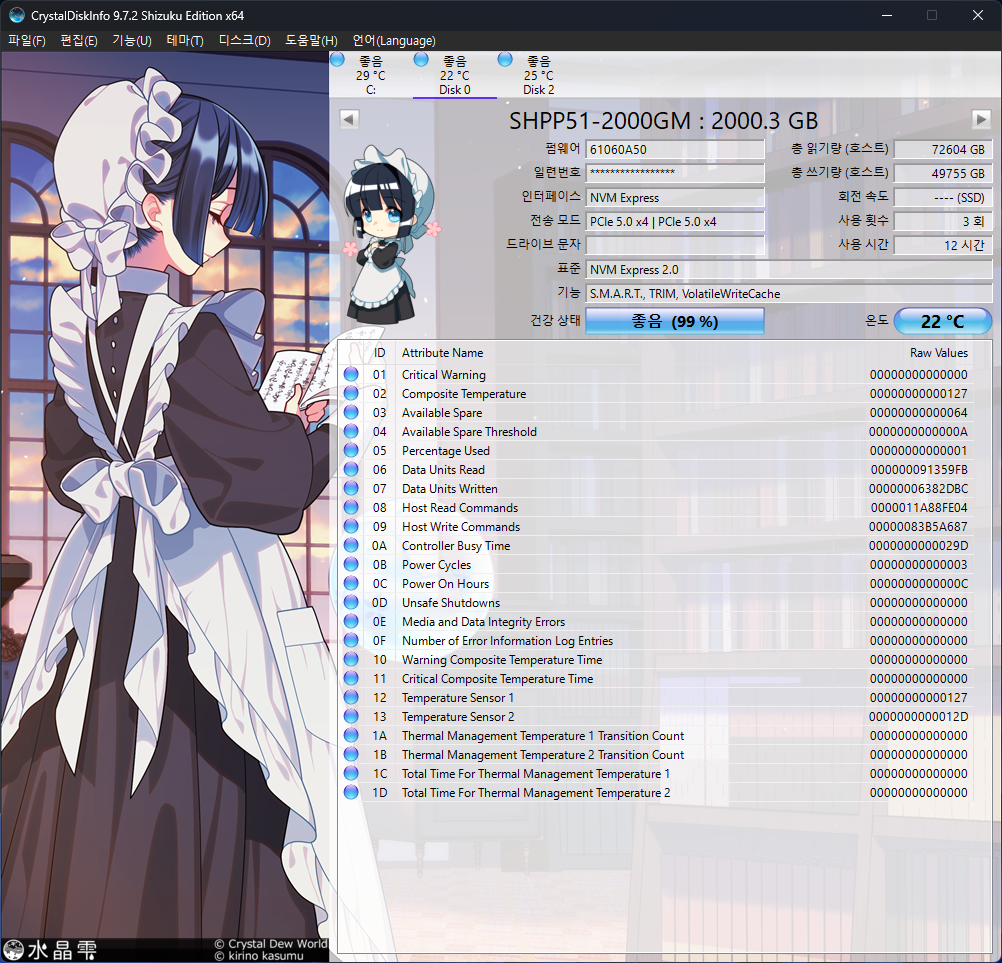

진짜진짜 FOB의 SSD입니다. 새 집 냄새나요. 온도 센서는 2개가 달려있으며, 1번 온도 센서의 값이 대표 온도로 읽힙니다.

벤치마크가 완전히 종료된 후의 CDI입니다. 100%가 깨져버렸어요.

smartmontools와 NVMe-CLI의 id-ctrl 결과는 GitHub에 첨부하도록 하겠습니다.

DUT Summary

벤치마크를 진행할 SSD에 관한 요약입니다.

SK hynix Platinum P51 2TB [SHPP51-2000GM] | |||

| Link | PCIe 5.0 x4 | NVMe Version | NVMe 2.0 |

| Firmware | 61060A50 | LBA Size | 512B |

| Controller | SK hynix Alistar | Warning Temp | 86 °C |

| Storage Media | SK hynix V8 TLC | Critical Temp | 87 °C |

| Power State | Maximum Power | Entry Latency | Exit Latency |

| PS0 | 10.50 W | 305 μs | 675 μs |

| PS1 | 6.5000W | 330 μs | 700 μs |

| PS2 | 2.0000W | 400 μs | 870 μs |

| PS3 | 0.0500W | 2000 μs | 3000 μs |

| PS4 | 0.0035W | 2000 μs | 12000 μs |

다른 SSD들과 비교하면, Entry와 Exit 지연시간이 0으로 끝나지 않는 부분이 있어서 그런가, 묘하게 현실감이 느껴집니다.

Warning 및 Critical 온도는 섭씨 1도의 차이로 80도 후반대가 입력되어 있습니다.

Comparison Device

비교군은 아래와 같습니다.

| Name | Why? |

| PM9E1 1TB [4L1QNXH7] | 삼성의 PCIe 5.0 플래그십 cSSD |

| 970 PRO 1TB [1B2QEXP7] | PCIe 4.0 플래그십 cSSD 데이터가 없어서 땜빵용 구형 cSSD |

| 983 ZET 960GB [EEZ90R56] | 삼성의 Z-NAND를 기반으로 하는 SCM급 SSD |

어쩌다 보니 비교군이 삼성밖에 없네요. 983 ZET는 처음에 들고 올 생각이 없었는데, 일부 항목에서 비교할 만하다 싶어서 가져오게 되었습니다.

용량이 다른 부분이 아쉬울 뿐입니다.

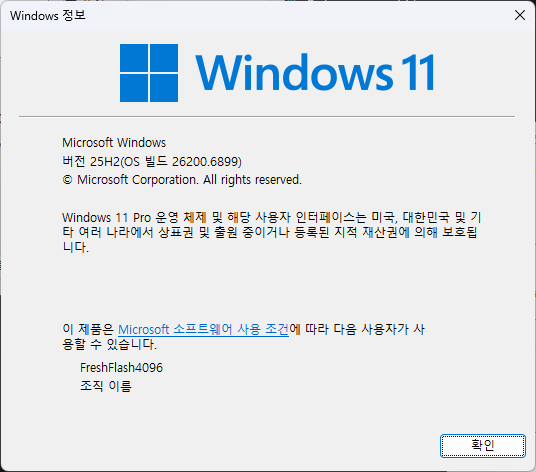

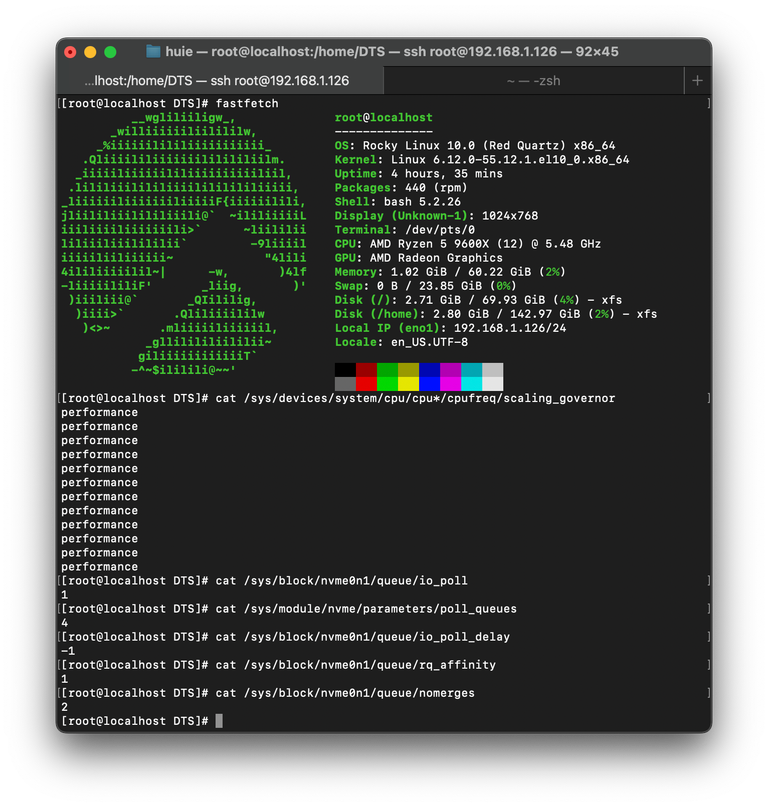

Test Platform

테스트 환경은 위와 같습니다. Windows 25H2(26200.6899)에 종속되는 도구들을 제외하고는 모두 FIO 3.41을 통해 Rocky Linux 10(6.12.0-55.12.1.el10_0)에서 실행되며, io_uring과 Polling을 적극적으로 활용합니다. 또한, 양쪽 다 기본 Inbox Driver를 사용합니다.

HW 사양에 대해서는 상단 우측의 fastfetch를 통해서 확인할 수 있지만, 다시 언급하자면, AMD의 9600X를 사용하고 있습니다. DUT는 5.0 x16 연결이 가능한 PEG 슬롯에 장착됩니다.

자세한 벤치마크 방법론에 대해서는 이전에 작성한 Refresh Benchmark를 참고해 주시길 바랍니다.

cSSD Benchmarking

start /wait Rundll32.exe advapi32.dll/ProcessIdleTasks Windows에서는 위의 명령어를 실행하고 15분 뒤를 IDLE 상태로 정의해 벤치마크를 진행합니다. 각 벤치마크 사이에는 5분의 휴식 시간이 부여되며, Purge는 Linux에서 nvme format 명령어를 통해 수행했습니다.

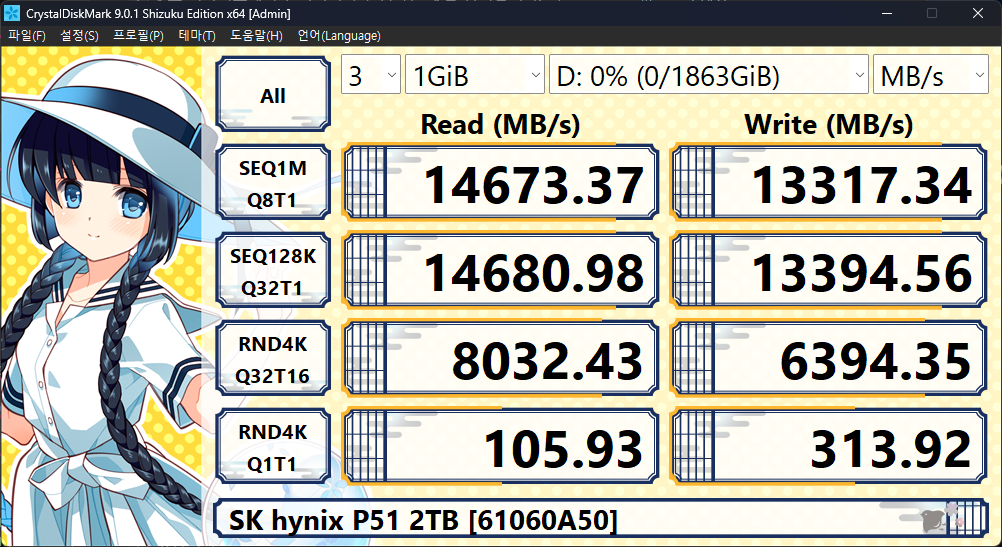

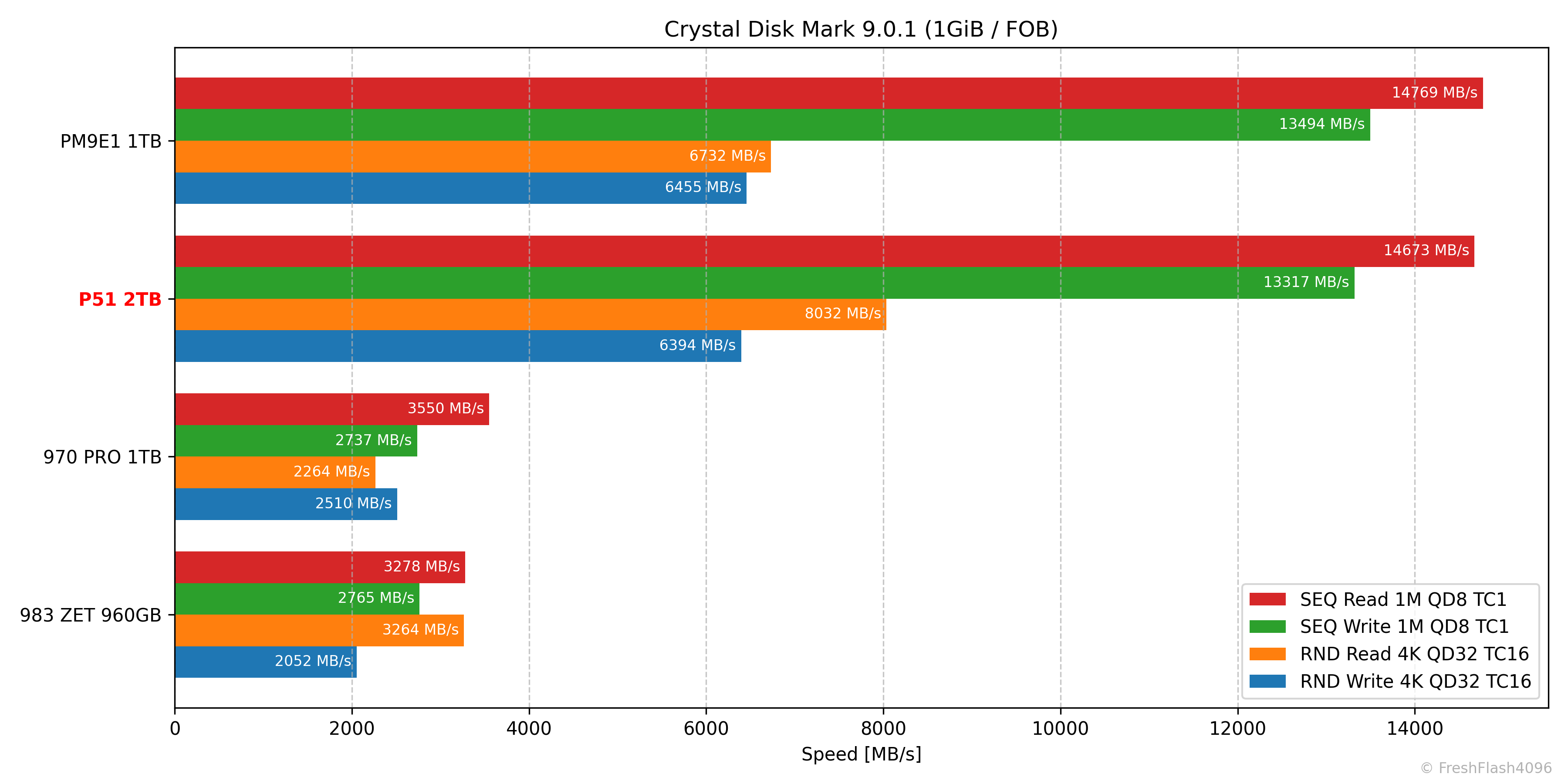

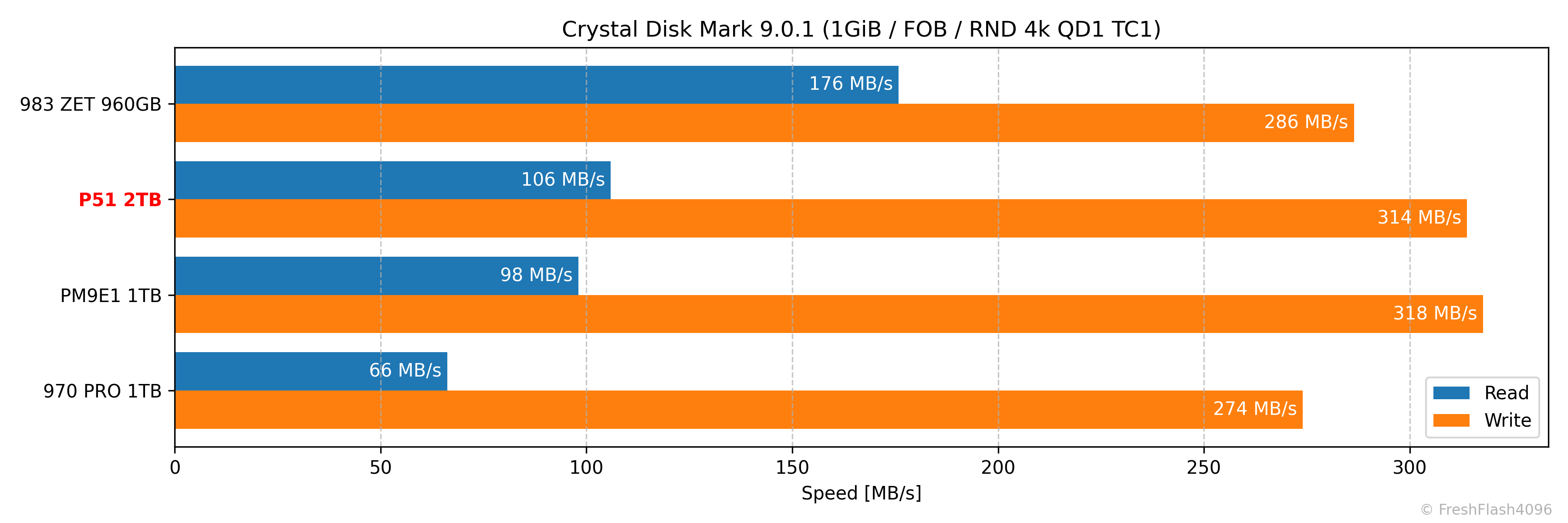

CrystalDiskMark 9.0.1

Windows에서 인식하는 용량은 1863GiB임을 확인할 수 있습니다.

읽기 최대 14700MB/s와 쓰기 최대 13400MB/s라는 표기 스펙의 순차 성능에는 살짝 미달이지만, 오차 범위 수준으로 생각해주면 합격으로 볼 수 있겠습니다.

랜덤 성능은 블록 사이즈를 지정해 두지 않았지만, 보통 4kB임을 고려하면, 읽기 2300k IOPS는 약 9421MB/s, 쓰기 2400k IOPS는 약 9830MB/s인데, 양쪽 모두 만족하지 못하는 모습입니다.

이는 9600X라는 CPU의 성능이 부족한 것도 있지만, Windows의 한계이기도 합니다. Linux기반의 FIO를 통한 결괏값은 아래와 같습니다. (테스트 사이즈는 동일하게 1GiB로 진행했습니다.)

| R/W [2300k / 2400k] | CDM | libaio (IRQ) | io_uring (Polling) |

| QD32 TC16 [IOPS] | 1961k / 1561k | 2097k / 2675k | 1725k / 2521k |

| QD512 TC1 [IOPS] | - | 722k / 764k | 2703k / 2731k |

Polling 기반으로 테스트를 진행했을 때, 스펙 성능을 만족하는 것을 확인할 수 있었습니다. 9100 PRO의 스펙 시트를 기록할 때 사용된 OS와 도구가 Linux 및 FIO라는 것을 생각해 보면, P51도 비슷하지 않을까 생각되네요.

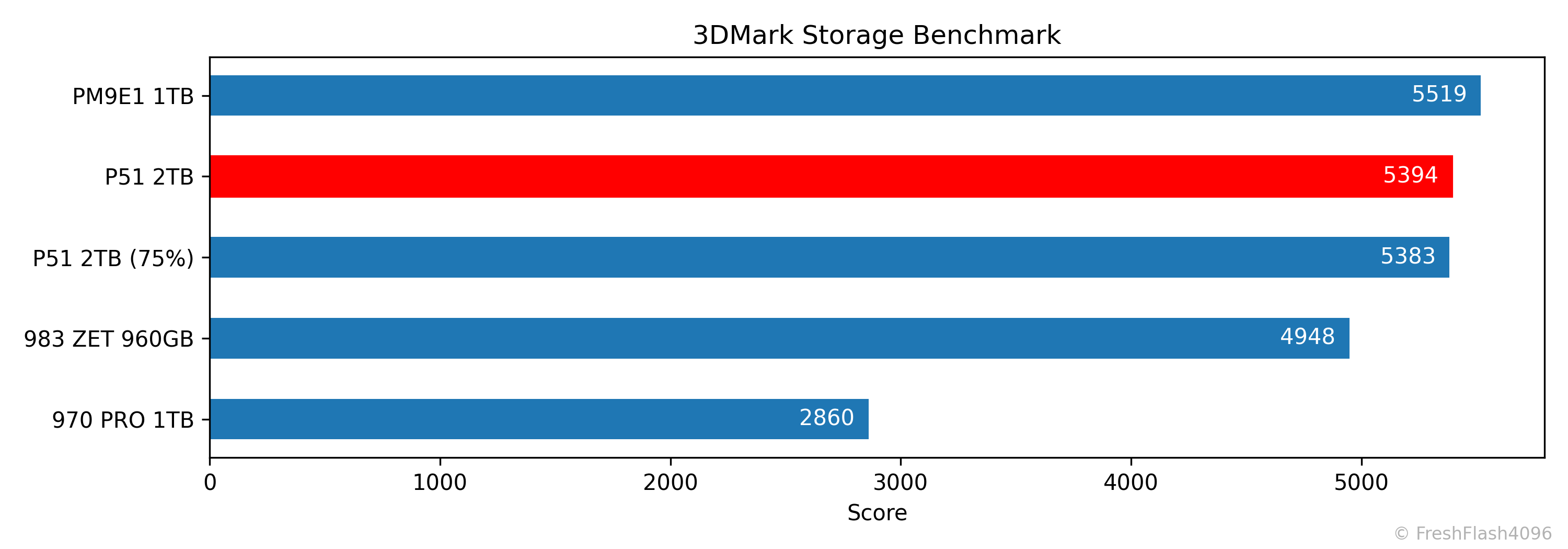

3DMark Storage Benchmark

3DMark에서는 PCIe 5.0 플래그십 cSSD 답게 구형 SCM급 SSD를 넘겨주는 모습을 보입니다. 호기심이나 수집 목적이 아니라면 일반적인 소비자 워크로드에선 최신 cSSD가 더 낫다는 모습을 뜻하기도 하죠.

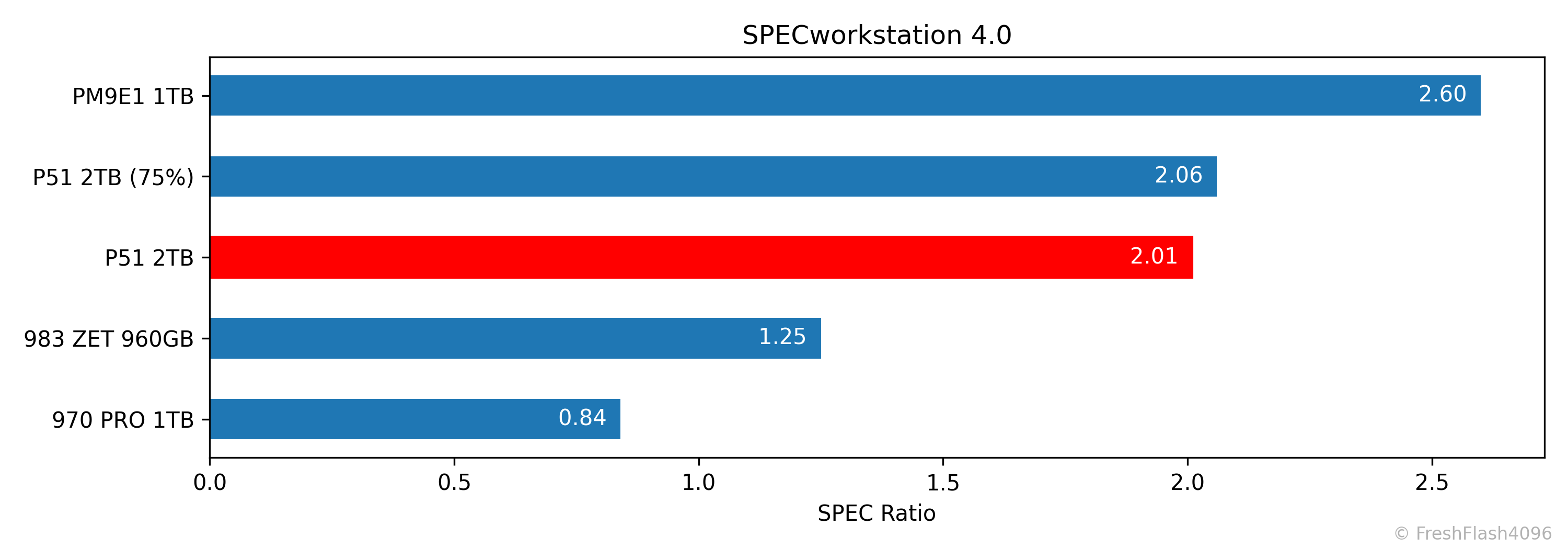

SPECworkstation 4.0

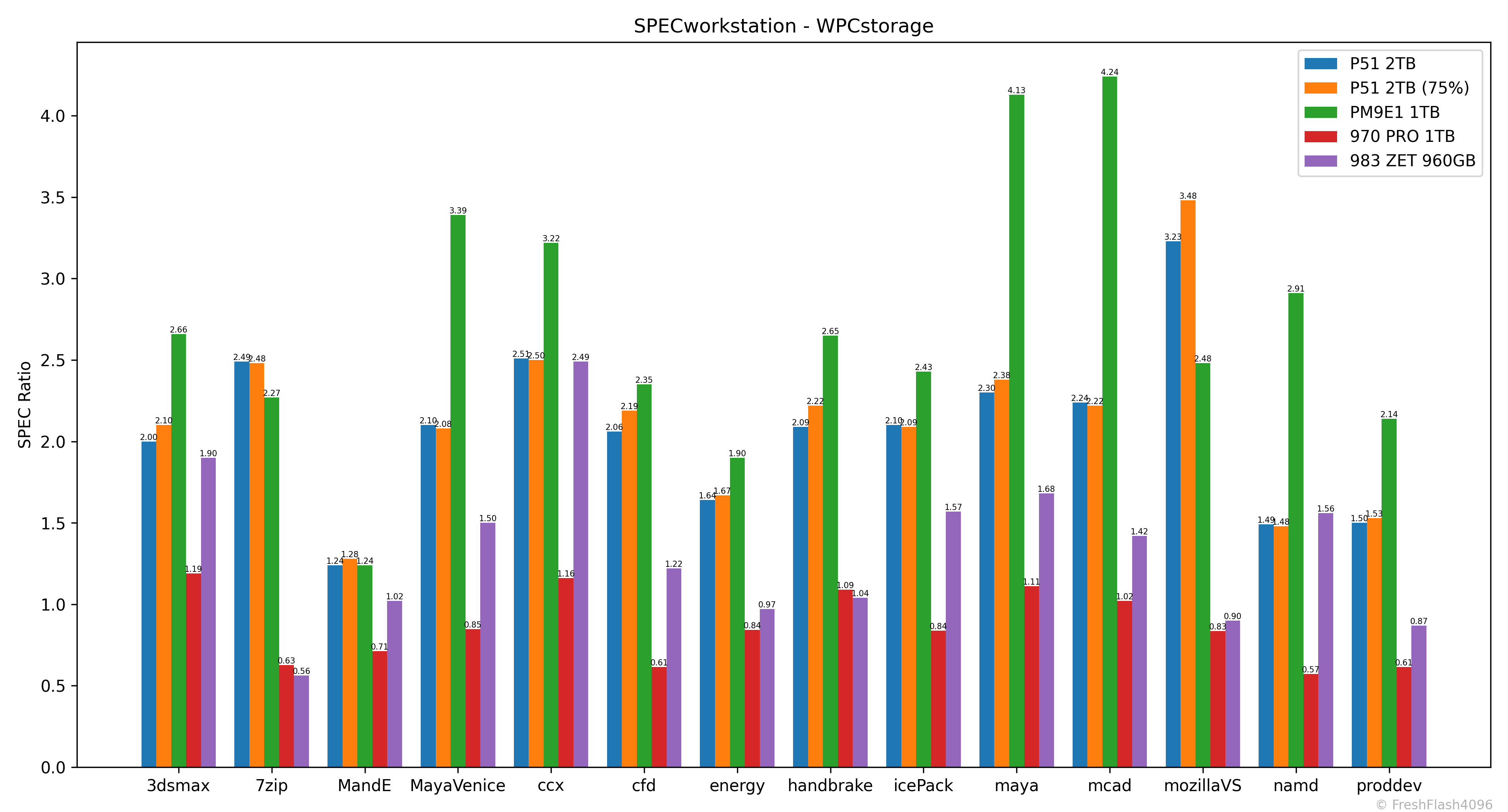

SPECworkstation에서는 위의 3DMark와 다르게 PM9E1과 꽤 차이를 보입니다. 그래도 2.0이 넘는 값은 여전히 인상적이네요.

워크로드를 개별적으로 살펴보면, PM9E1이 이상할 정도로 우월한 워크로드가 일부 확인됩니다.

Fill Drive

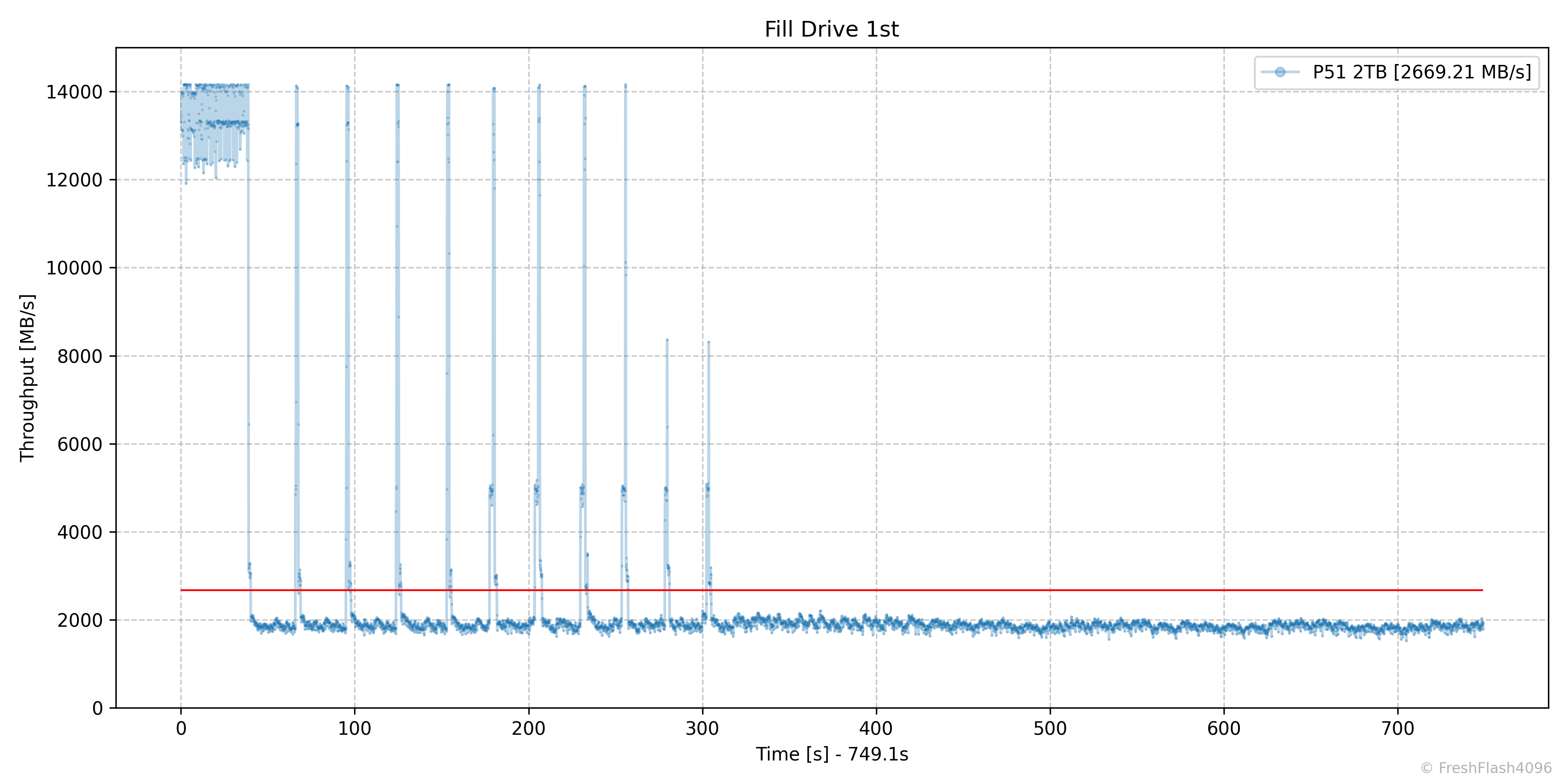

나래온 더티테스트와 비슷한 벤치마크입니다. FOB상태로 시작하여, SEQ 128k QD256으로 드라이브 전체를 2회 채우며, 0.1s 단위로 값을 측정합니다. 1회차와 2회차 사이의 휴식은 충분히 부여됩니다.

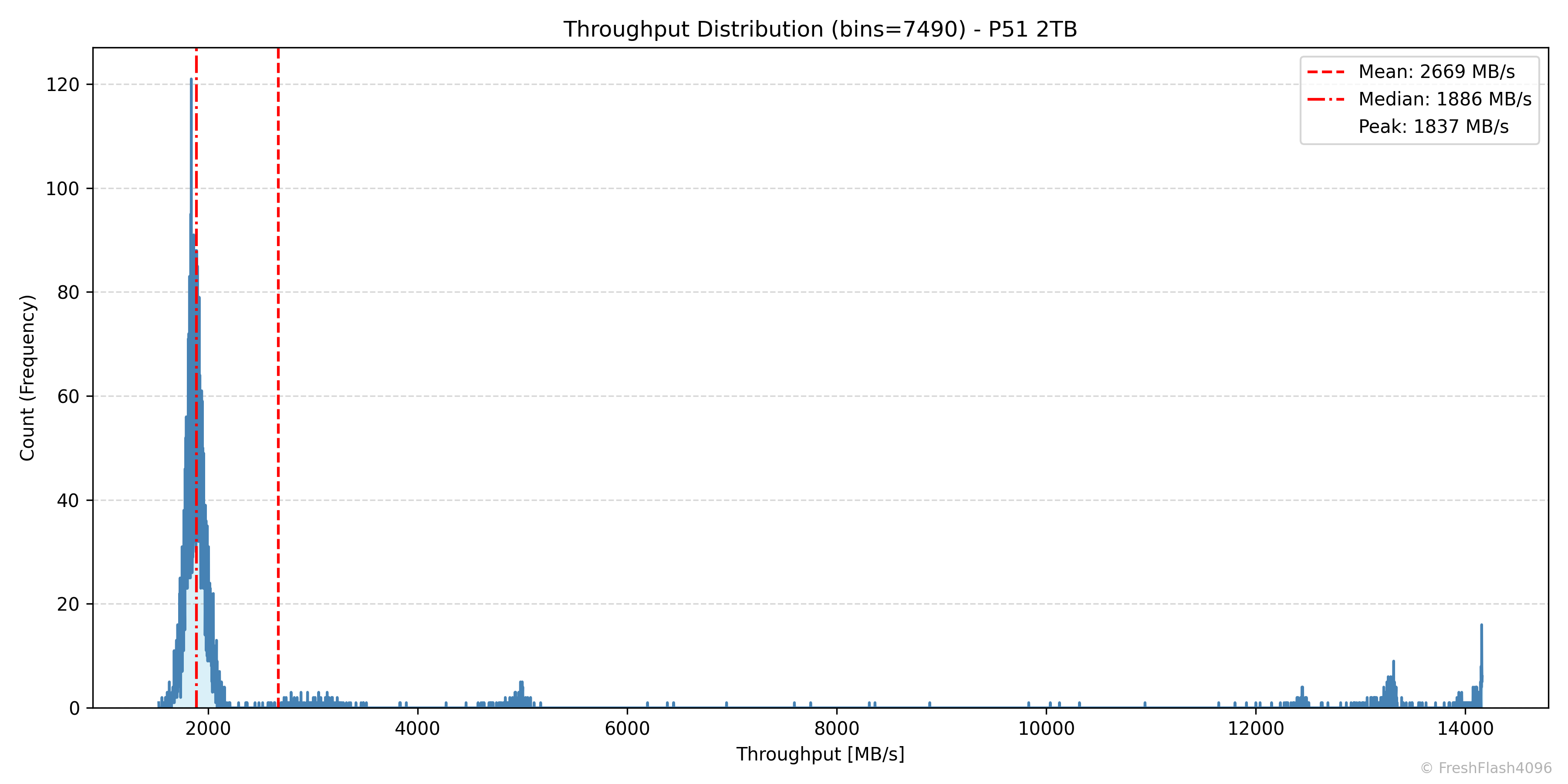

1차 Fill Drive는 12분이 조금 넘게 걸렸습니다. SLC 캐시의 최대 크기는 약 500GB로 짐작됩니다.

SLC 캐시 내부에서는 12GB/s에서 14.7GB/s 정도의 속도를 보여주었으며, 이후에는 캐시의 내용을 Flush하는 패널티가 부가되어 약 1890MB/s의 속도를 보여주었습니다.

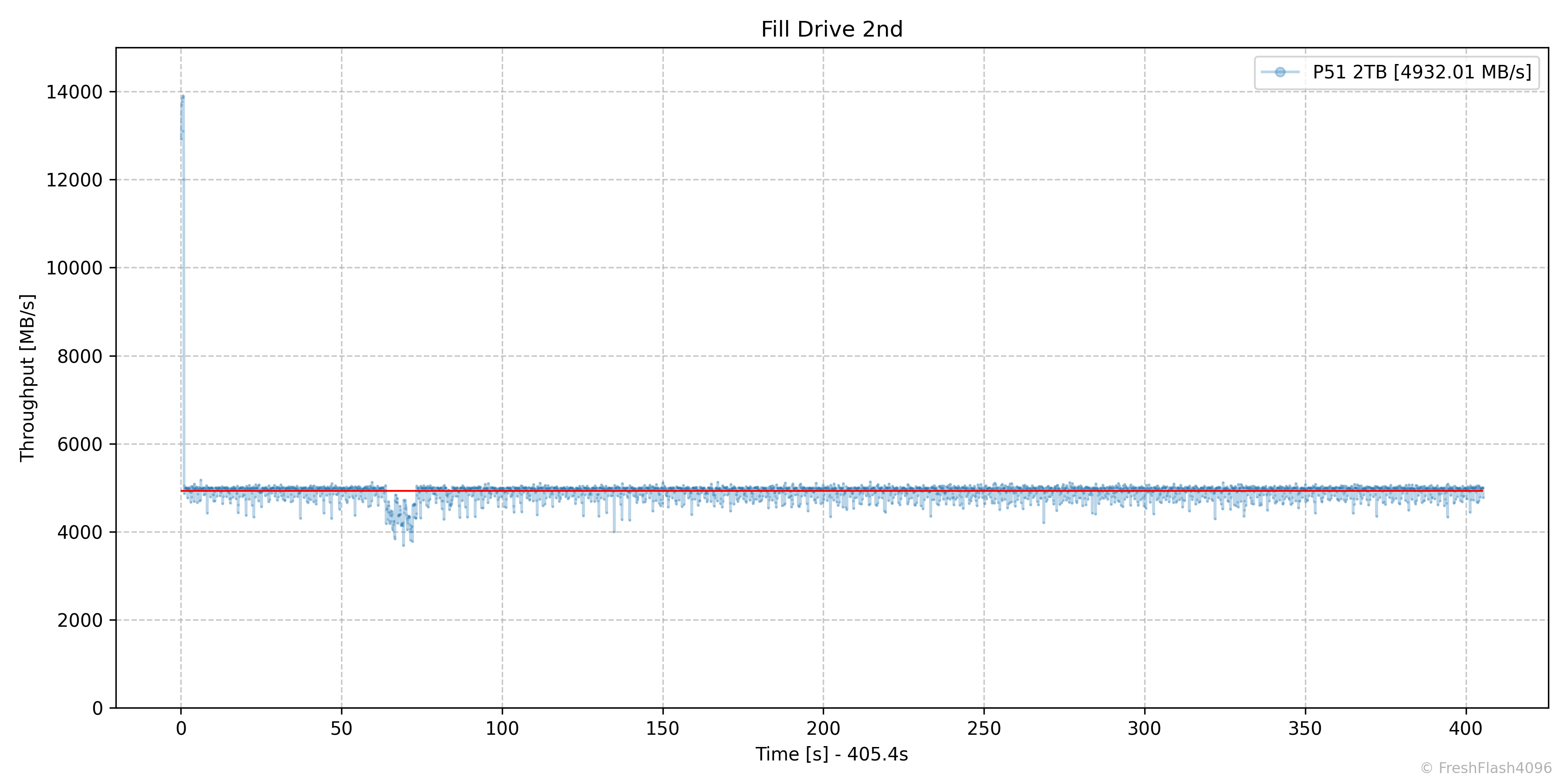

2차 Fill Drive에서는 10분도 걸리지 않았습니다. SLC 캐시의 최소 크기는 약 10GB로 추정됩니다.

TLC에 직접 쓰는 이 과정은 약 5000MB/s의 속도를 보여주며, 빠른 것을 넘어 감동적인 속도를 보여주었습니다. 이것이 컨슈머 워크로드에 가깝지 않은 것이 아쉬울 정도로 말이죠.

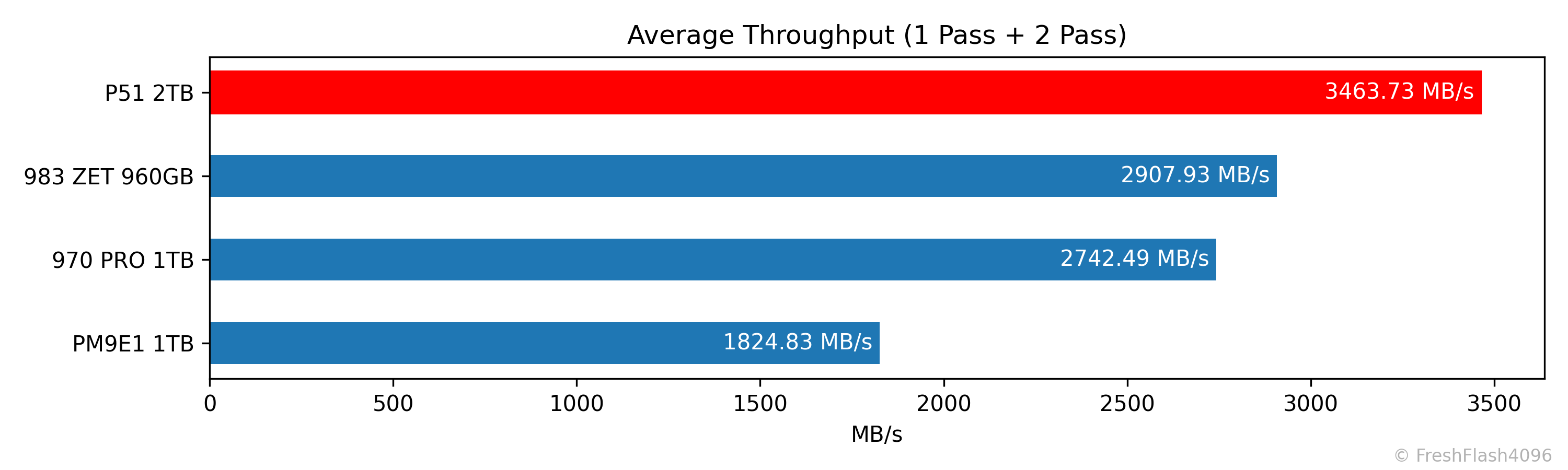

첫 번째와 두 번째의 Fill Drive에 대한 전체 평균값은 3000MB/s를 넘기며, 제가 지금까지 보여드린 SSD 중 가장 우수했습니다.

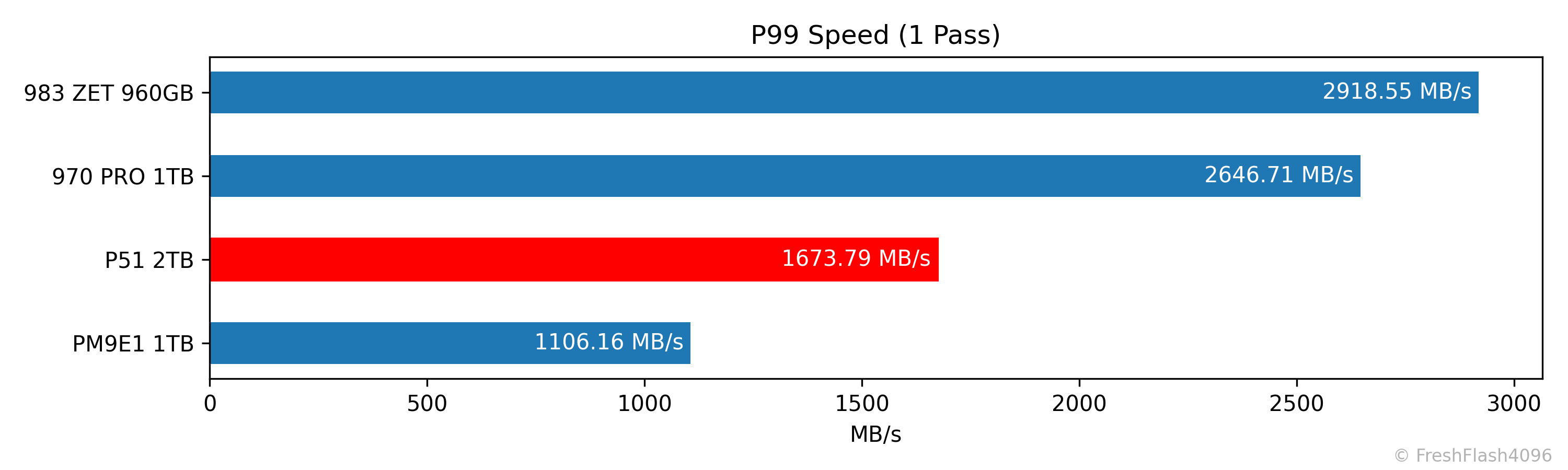

물론, 첫 번째 Fill Drive에 대한 하위 1% 속도는 Flush 과정 때문에 낮게 나왔습니다. 그래도 성능이 상당히 우수하네요.

Sync Performance

자체적인 Pre-Conditioning 이후, 해당 영역에 한해서 측정됩니다. 쓰기량은 총 500MiB이며, 최대 소모 시간은 2분으로 제한합니다. sync=1 옵션을 활용했습니다.

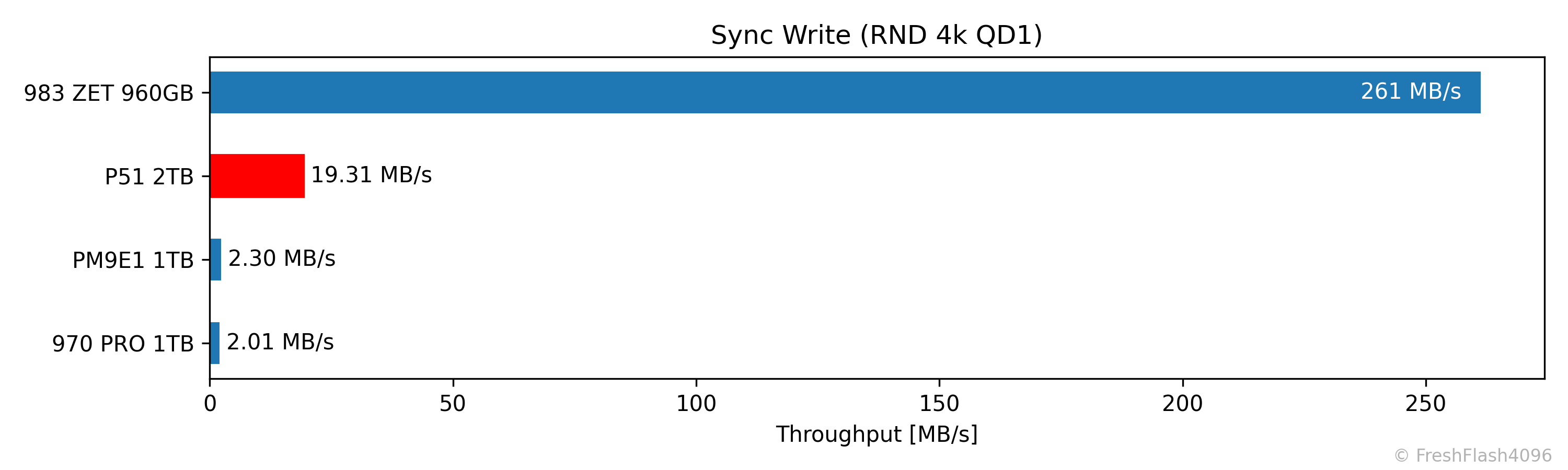

19.31 MB/s라는 속도를 보여주었습니다.

Low QD Performance by RW Ratio

이전과 마찬가지로 Pre-Conditioning 이후에 측정하며, Burst 성능을 측정하기 위해서 각 단계에서 가해지는 I/O의 양은 GB 단위가 되지 않습니다. 다시 말해, 매우 가벼운 부하입니다. 전체 용량의 75%는 이미 채워져 있지만요.

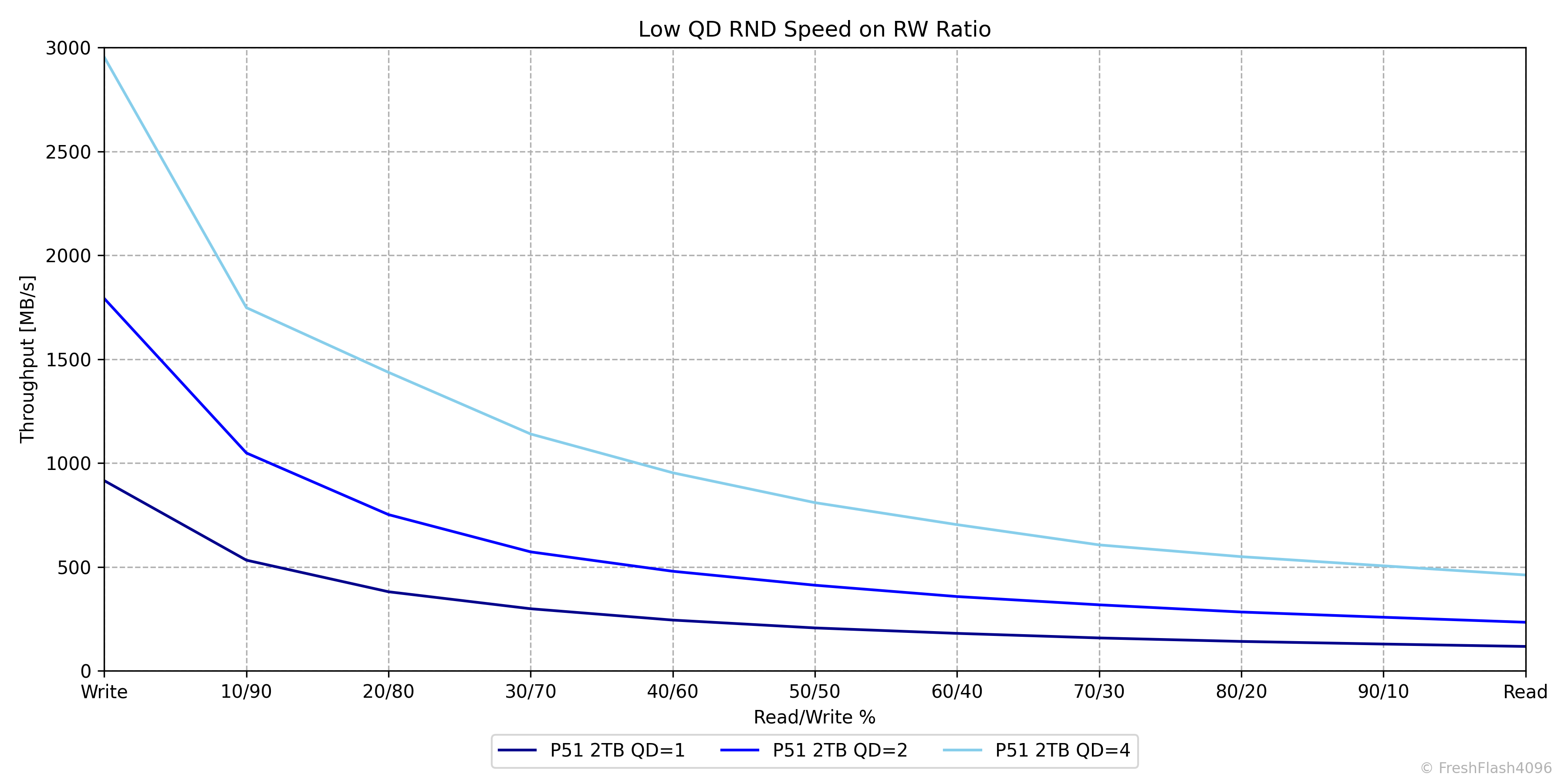

Low QD 성능도 예상보다 우수했습니다. Polling 기반의 테스트에 Burst 속도를 측정한 것이지만, 4kB QD4의 쓰기 속도가 3000MB/s에 가깝고, 읽기 성능도 QD1 117MB/s, QD2 234MB/s, QD4 461MB/s로 PM9E1보다 약간 우수한 모습입니다.

Weighted Graph

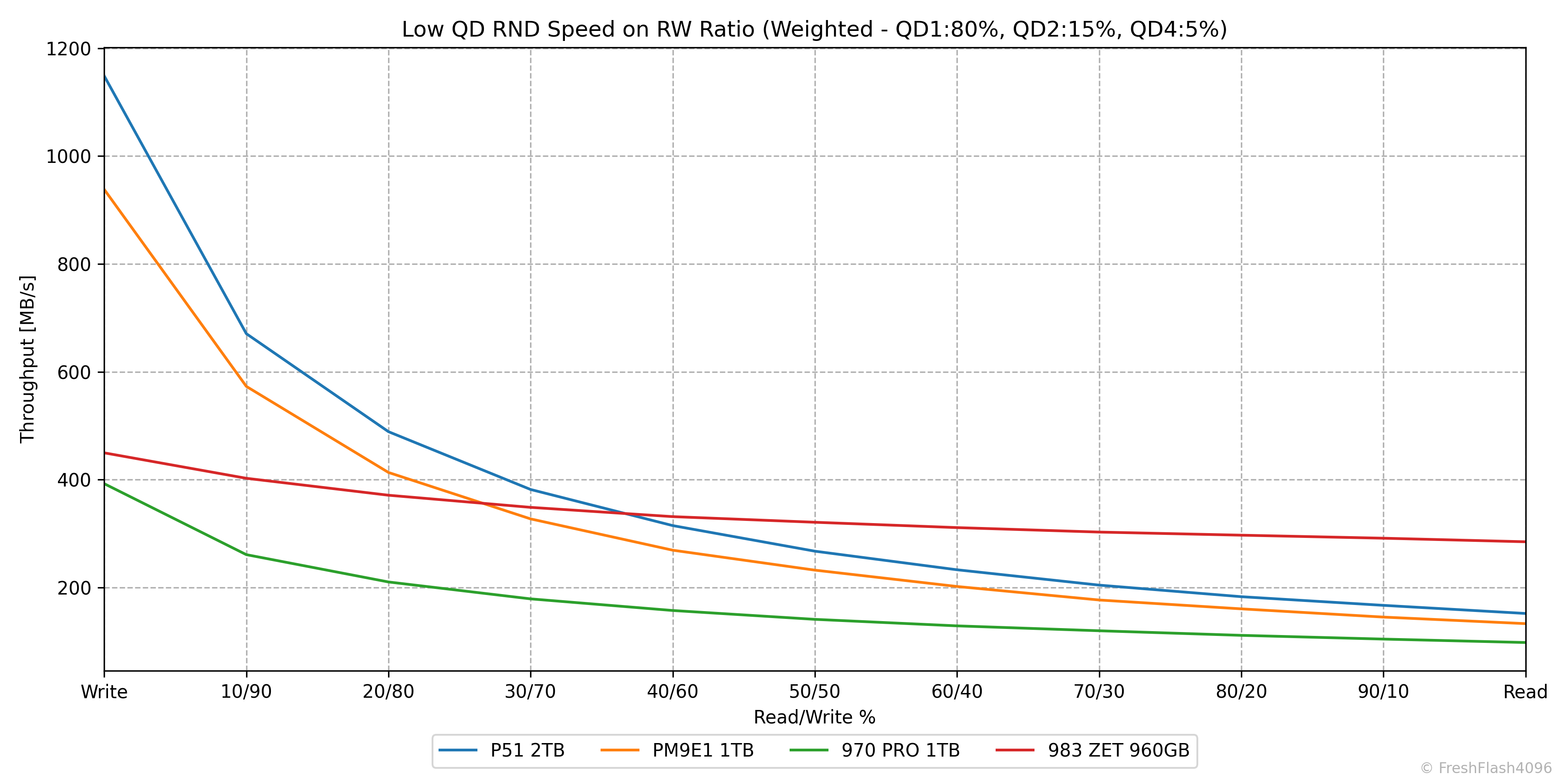

QD1 80%, QD2 15%, QD4 5%로 가중치를 부여해 보기 쉽게 나타냅니다.

앞서 말한대로, 전체적으로 PM9E1보다 우수한 모습입니다.

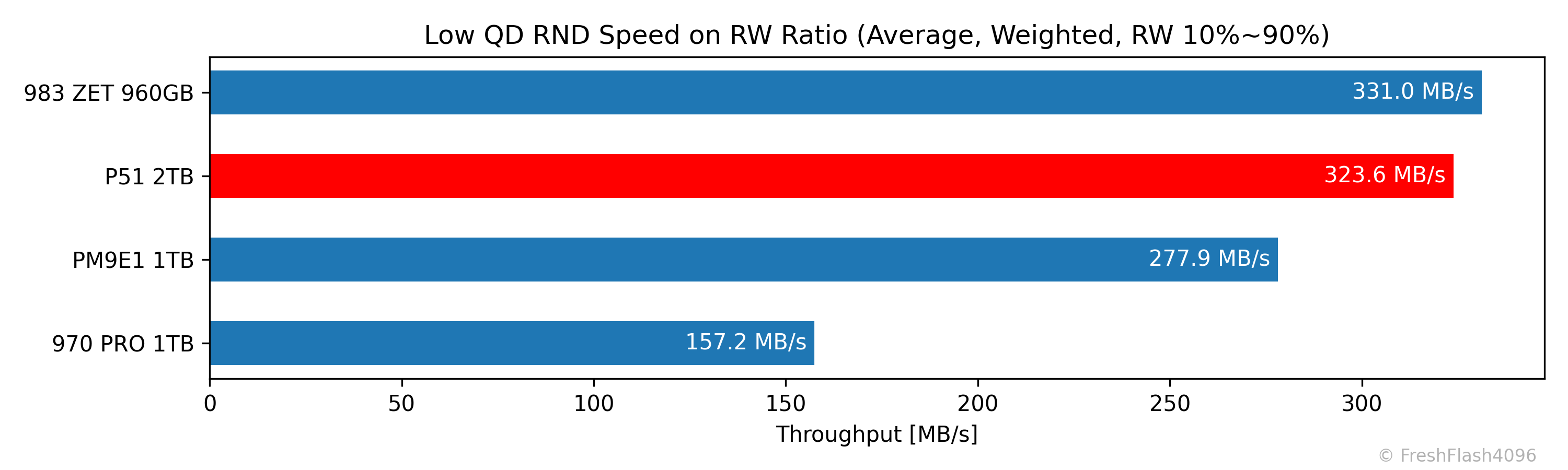

완전한 읽쓰기를 제외하고 산출한 평균값입니다. 983 ZET에 가까운 값을 보여주고 있네요. 다만, 일반적인 소비자 워크로드에선 읽기 비율이 더 높으며, 이 그래프는 쓰기가 상당히 강조되었다는 것을 염두에 두어야 합니다.

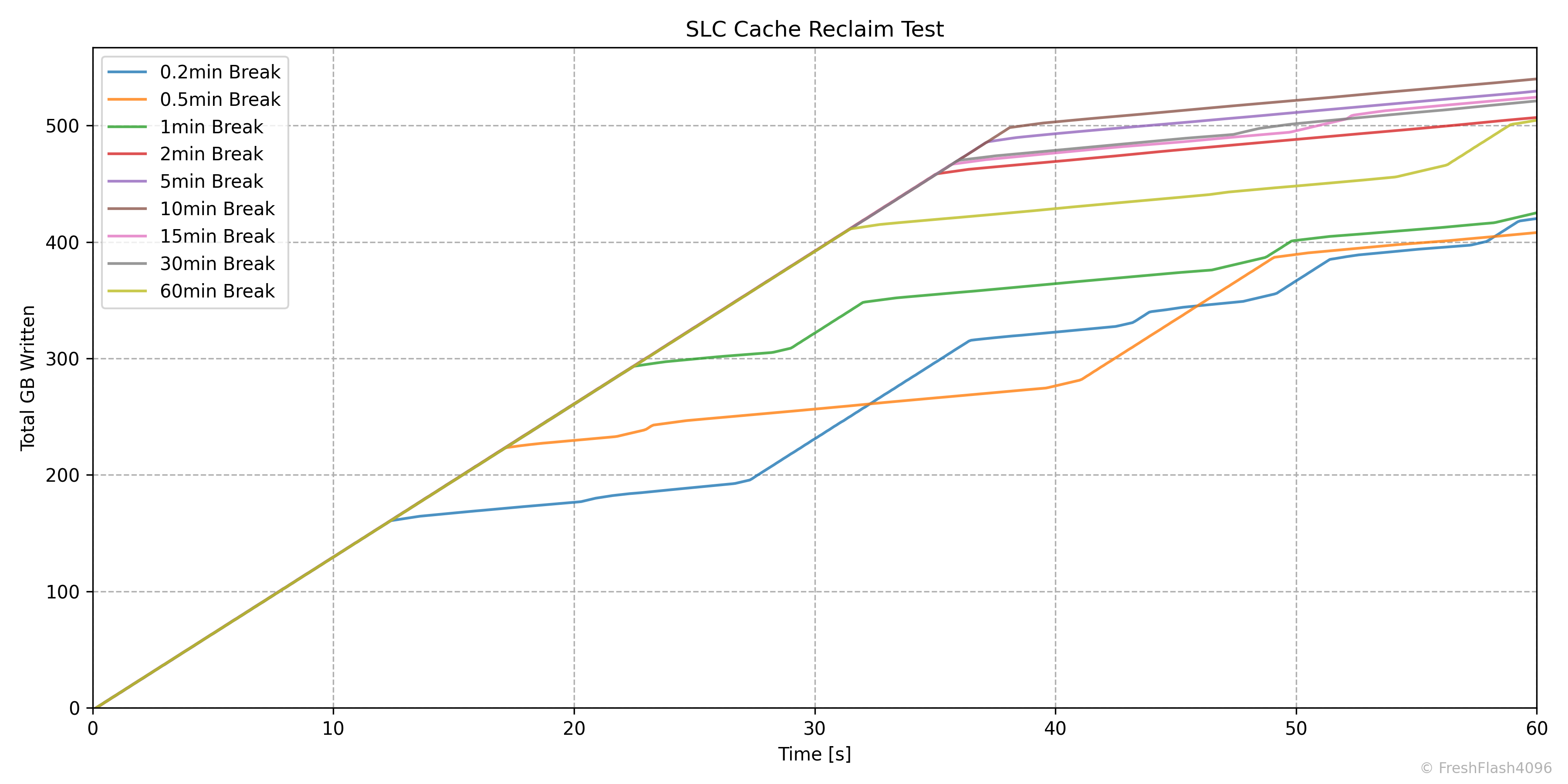

SLC Cache Reclaim

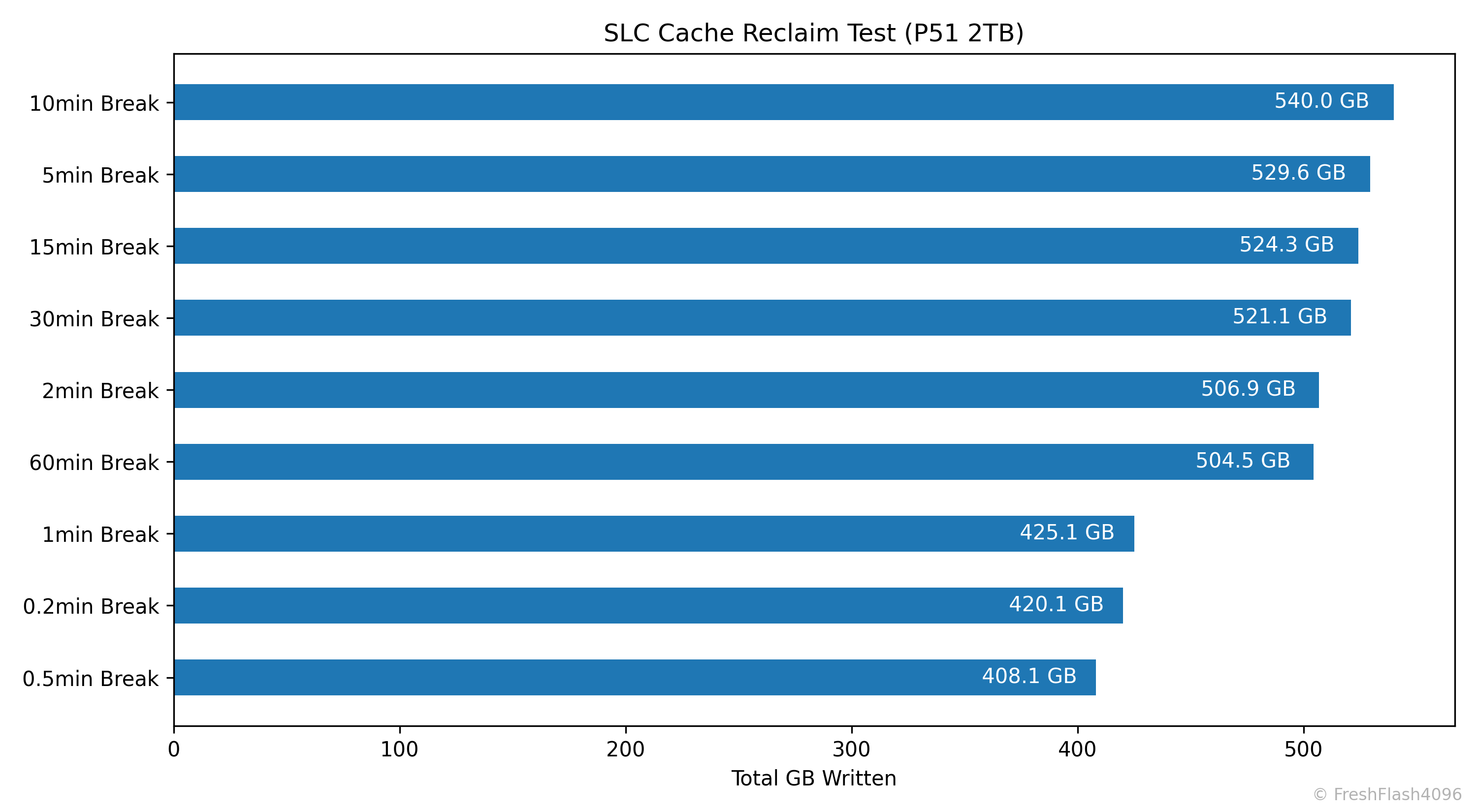

SLC 캐시의 회복에 대해서 알아보기 위해 설계되었습니다. Purge를 수행하고, User Capacity의 50%를 SEQ 128k QD256로 채운 뒤, 잠깐의 휴식을 취합니다. 이후, SEQ 128k QD256 쓰기를 1분간 진행합니다.

이 휴식 시간을 늘리며 테스트를 7회 진행합니다. 그래프들은 휴식 이후 1분간의 I/O에 대한 결과입니다.

1차 Fill Drive의 그래프를 보시면, SLC 캐시가 포화된 이후에도 조금 독특한 패턴을 그리며 SLC 캐시를 사용하는 모습이 보일 것입니다. 이러한 펌웨어의 동작이 위와 같은 쓰기량을 산출했을 것이라고 짐작할 수 있습니다.

이 그래프를 보면, 초기 상태의 기울기가 유지되는 시간을 통해 SLC 캐시의 회복 정도를 파악할 수 있습니다. 2분의 휴식 시간까지는 회복량이 눈에 띄게 증가하는 것을 볼 수 있습니다.

eSSD Benchmarking

Purge 직후를 제외한 모든 단계 사이에는 휴식 시간이 부여되지 않습니다. Pre-Conditioning은 User Capacity의 2배를 쓰고나서도 Steady State에 진입할 때까지 이를 계속 진행합니다.

Steady State는 SEQ의 경우엔 대역폭의 기울기가 ±10%인 상태를 30초간 유지하는 것을 기준으로 하며, RND의 경우에는 IOPS의 기울기가 ±10%인 상태를 30초간 유지하는 것을 기준으로 합니다. 이를 달성할 수 없을 땐 User Capacity의 23배까지 쓰기를 진행합니다.

모든 워크로드는 User Capacity의 전체 영역에 대해서 진행하며, 각각 30초의 적응 시간을 가진 후에 5분 동안 성능측정을 진행합니다. 다시 말해, 128k Read 성능을 측정한다면 QD1 ~ QD256까지 총 9개의 작업이 있으며, 모든 작업이 30초의 적응 시간과 5분의 측정시간이 부여됩니다.

역시 자세한 벤치마크 방법론에 대해서는 이전에 작성한 Refresh Benchmark를 참고해주시길 바랍니다.

4-Corners Performance

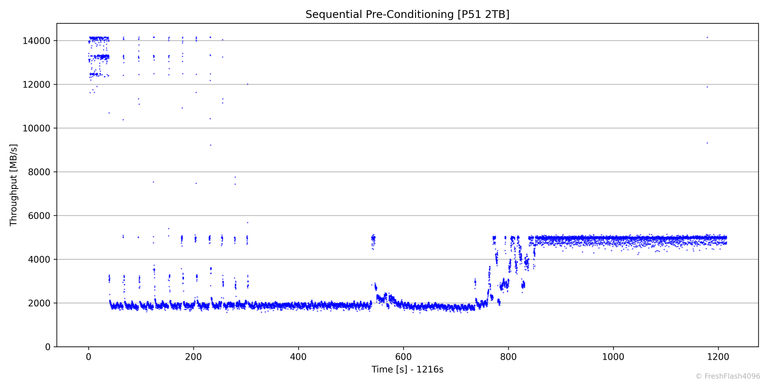

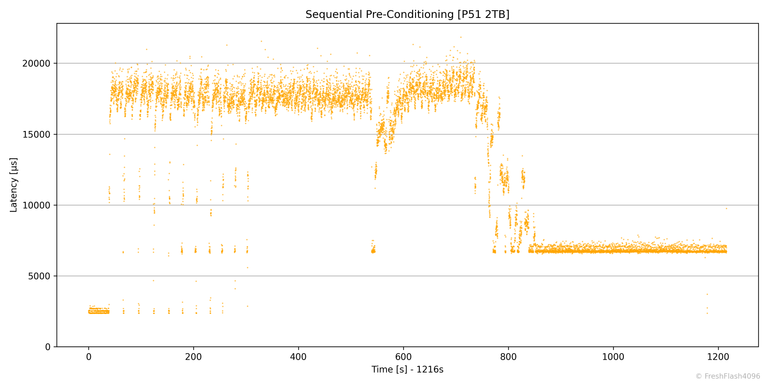

SEQ Pre-Conditioning

SEQ Pre-Conditioning은 약 20분에 걸쳐 진행되었으며, 4827MB/s로 Steady State에 진입했습니다. 앞서 Fill Drive에서 보았듯, TLC에 직접 쓰는 속도가 빠릅니다. 참고로, 아직 리뷰를 게시하지 않은 제품들을 전부 카운트해도 한 손에 꼽힐 성능입니다.

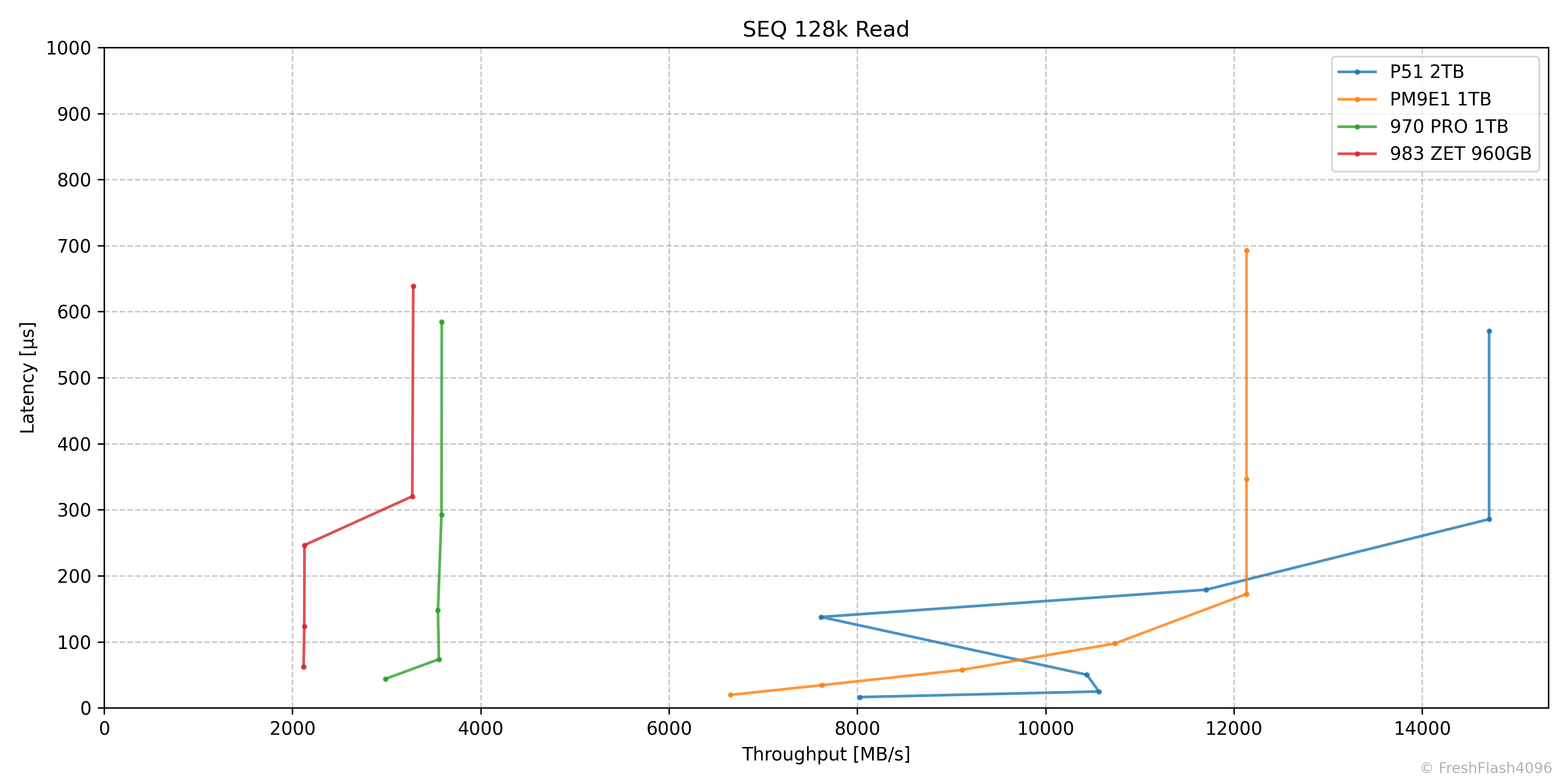

SEQ 128k Read

순차 읽기는 QD32에서 14710MB/s@286µs의 최대 성능을 보였습니다. 다만, QD8에서 비정상적으로 속도가 하락했습니다.

QD16에서는 PM9E1의 12133MB/s에 밀리지만, 결국 14.7GB/s에 달하는 최대 성능을 보인 것을 생각하면 상당히 기쁜 일입니다. 오히려 PM9E1이 14.7GB/s에 도달하지 못한 부분이 의문이 생기니 말이죠. PM9E1은 개인적으로 추가 벤치마크를 몇 개 예정해 두고 있기에, 보고할 사항이 생기면 블로그에 다시 작성해 보도록 하겠습니다.

SEQ 128k Write

감동스러운 순차 쓰기는 QD1에서 포화상태로, 4920MB/s@26µs의 성능을 보였습니다. 비교 대상들은 모두 1TB라는 부분이 걸리지만, 이를 감안하더라도 P51의 Steady State 순차 쓰기 성능은 굉장히 우수합니다.

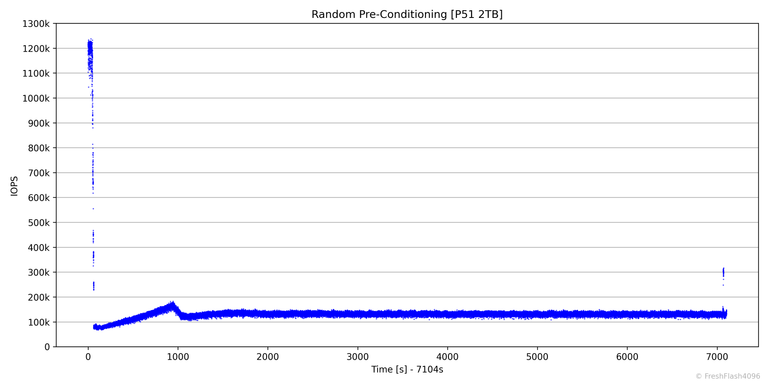

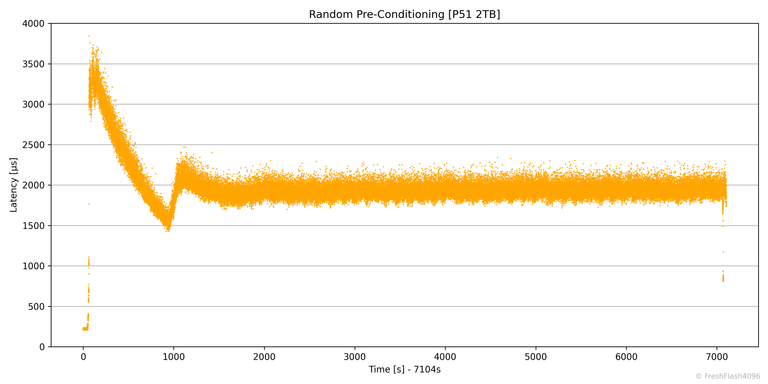

RND Pre-Conditioning

RND Pre-Conditioning은 2시간이 채 걸리지 않았으며, 131k IOPS로 진입했습니다.

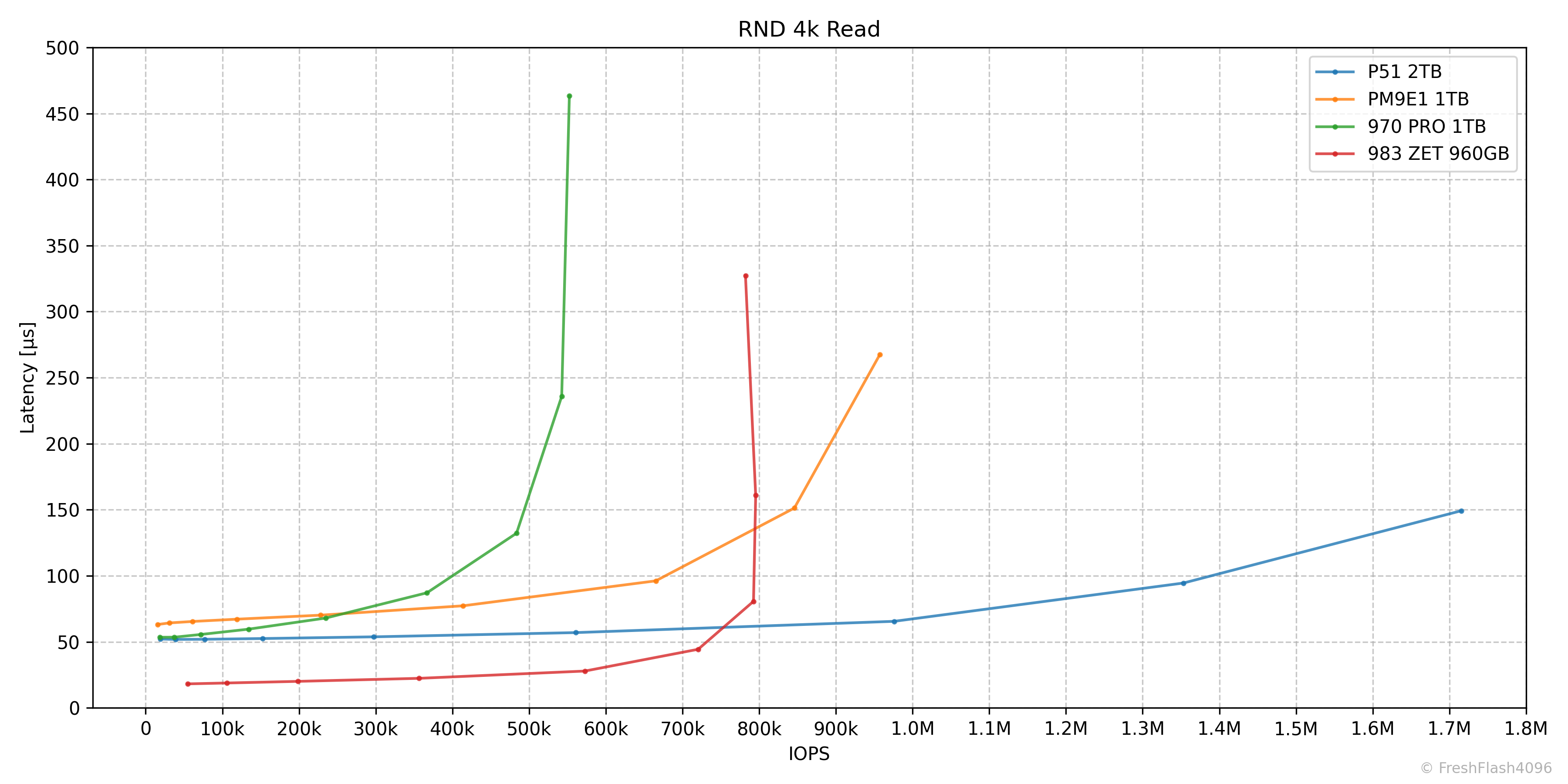

RND 4k Read

랜덤 읽기는 QD256에서 1715k IOPS@149µs의 성능이 측정되었습니다. QD64에서 976k IOPS@66µs로 모든 비교군을 넘어서는 모습을 보여주었고, Low QD에서는 Z-NAND를 기반으로 하는 983 ZET에는 대항하지 못하지만, PM9E1, 970 PRO와 비교하면 약간 앞서는 모습입니다.

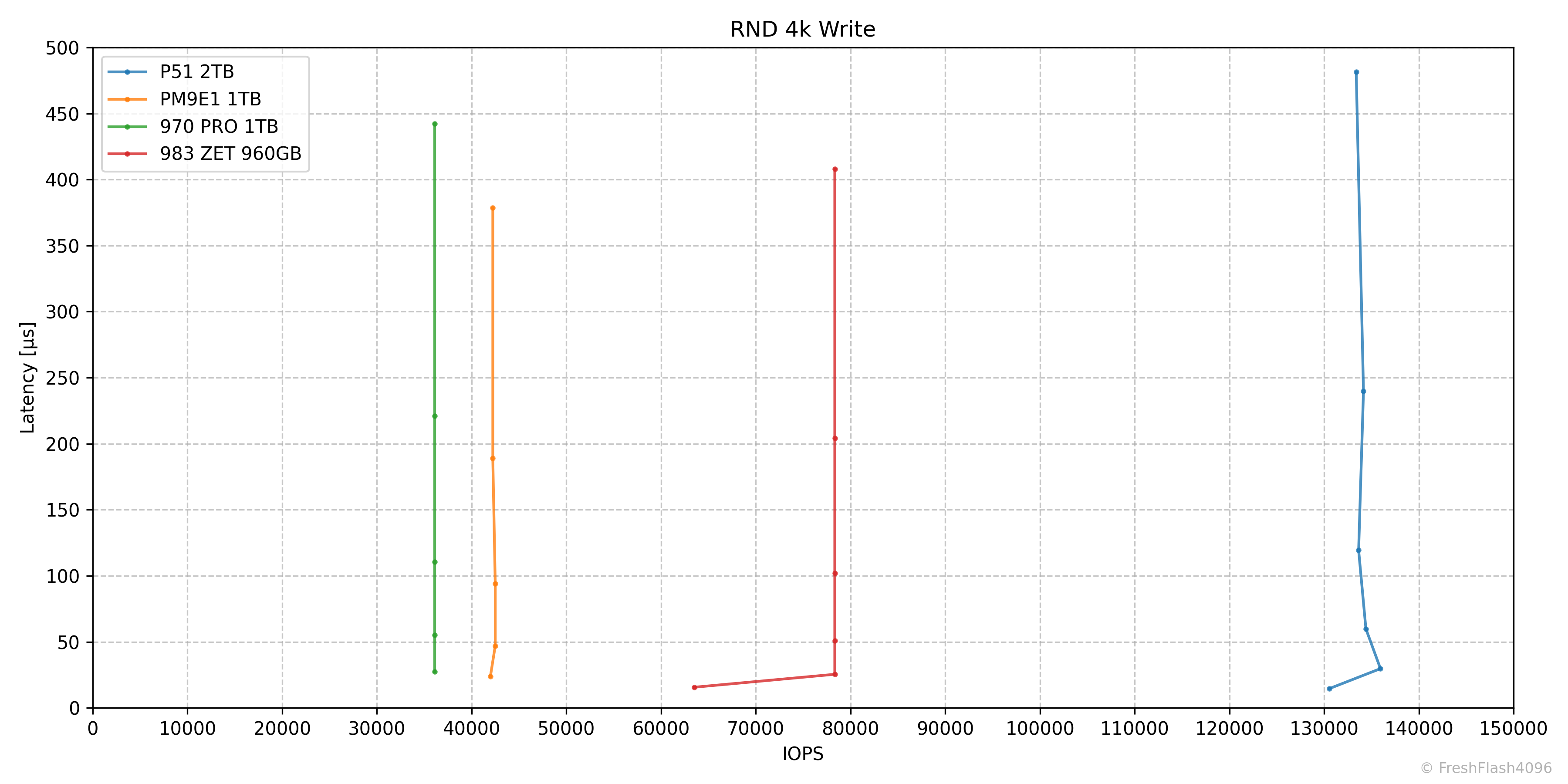

RND 4k Write

랜덤 쓰기는 QD1에서 131k IOPS@8µs, QD2에서 134k IOPS@15µs가 측정되었습니다.

983 ZET가 78k IOPS, 28% OP를 부여한 800GB의 성능이 171k IOPS로 측정되는 것을 생각할 때, 0% OP인(엄밀히는 그렇지 않지만) cSSD의 랜덤 쓰기가 130k IOPS를 넘긴다는 것은 굉장히 우수합니다.

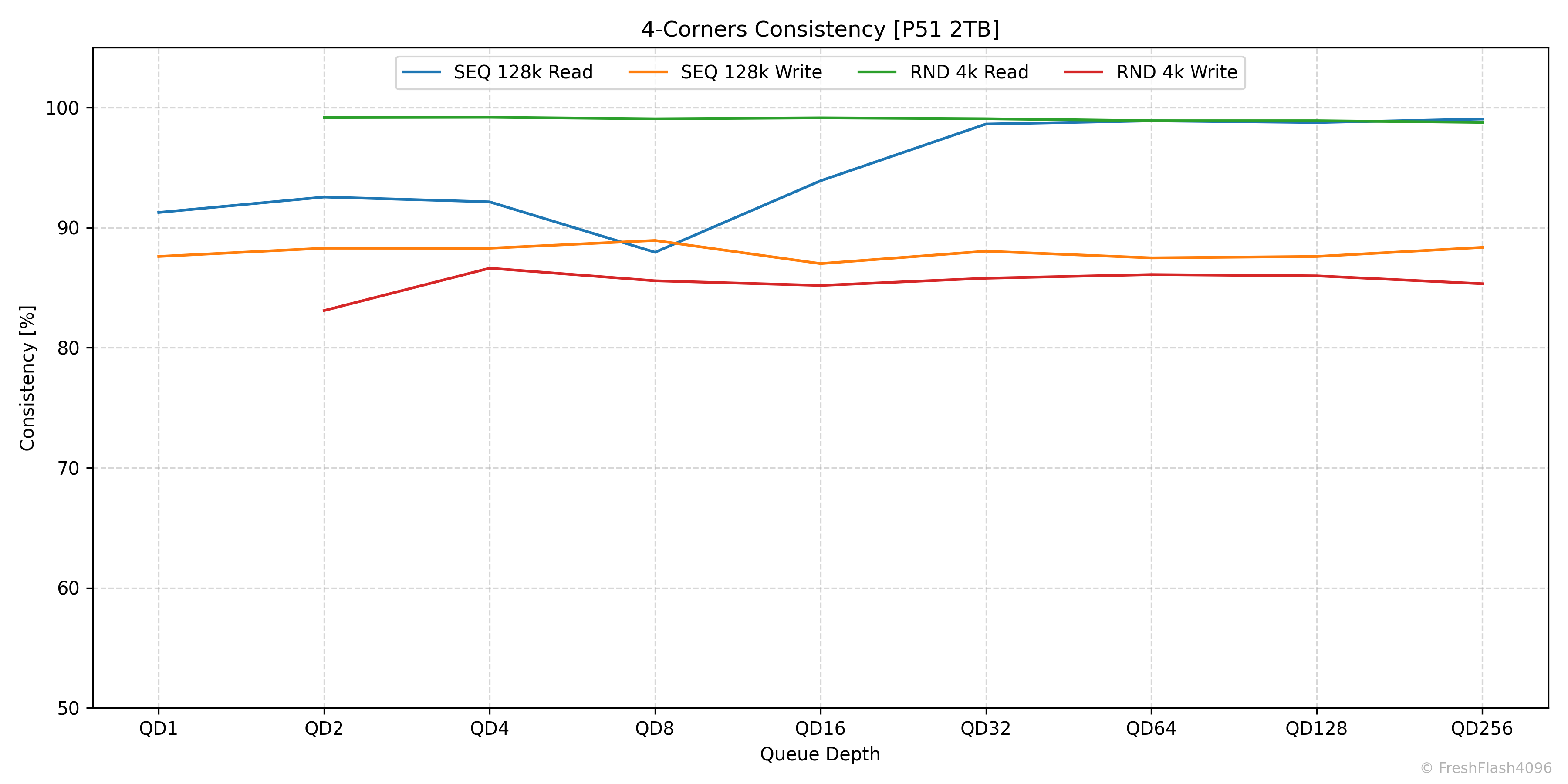

4-Corners Consistency

QD에 따른 4-Corners Performance의 안정적인 정도를 제시합니다. 상위 99.9%값과 평균을 이용하는데, SEQ 128k에서는 Bandwidth를 기준으로, RND 4k에서는 IOPS를 기준으로 계산합니다. 참고로, RND 4k에서 QD1에 대한 값은 이후 Tail Latency에서 자세히 살펴보기에 제외됩니다.

쓰기는 전체적으로 80% ~ 90% 사이를 유지하며, 읽기는 대체로 90% 이상의 모습을 보여줍니다. 단, QD8의 순차 읽기에서 90% 이하의 일관성을 보이는데, 이는 위에서 확인할 수 있었던 QD8의 낮은 성능과 관련이 있지 않나 싶습니다.

Specific Workload Performance

4-Corners Performance가 아닌 워크로드를 분리했습니다. 단, 워크로드 이름은 편의상 붙인 것뿐이며, 실제 환경에서는 다양한 Block Size와 RW 비율이 나타난다는 것을 명심해야 합니다. Block Size들의 정확한 비율과 RW 비율을 결정하기 힘들어 대략 분류한, 가상의 워크로드입니다.

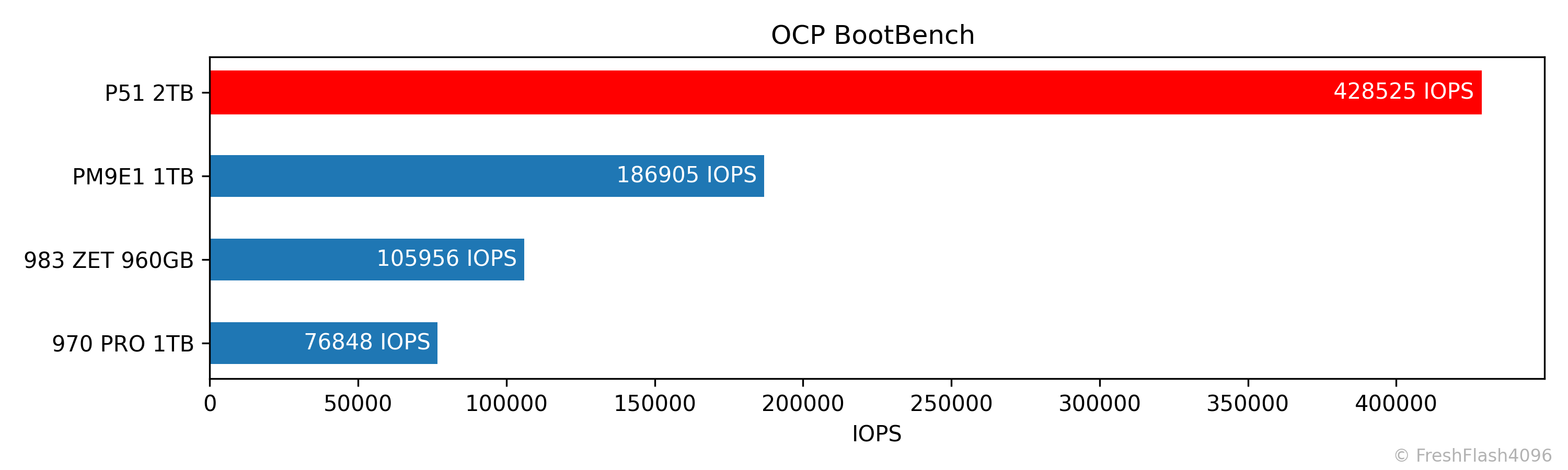

Boot Workload (OCP BootBench)

Hyperscale에서의 Boot Drive로 사용될 때의 성능을 측정하는 벤치마크입니다. SEQ Write로 User Capacity가 2번 채워지면, 동기 쓰기, TRIM, 읽기가 동시에 가해지며, 결과의 지표는 읽기 IOPS입니다. 60k IOPS를 통과하면 합격입니다.

두 말할 것도 없이 합격선을 아득히 넘는 429k IOPS를 보여주었습니다. 제가 테스트한 드라이브 중 독보적으로 가장 우수한 값입니다.

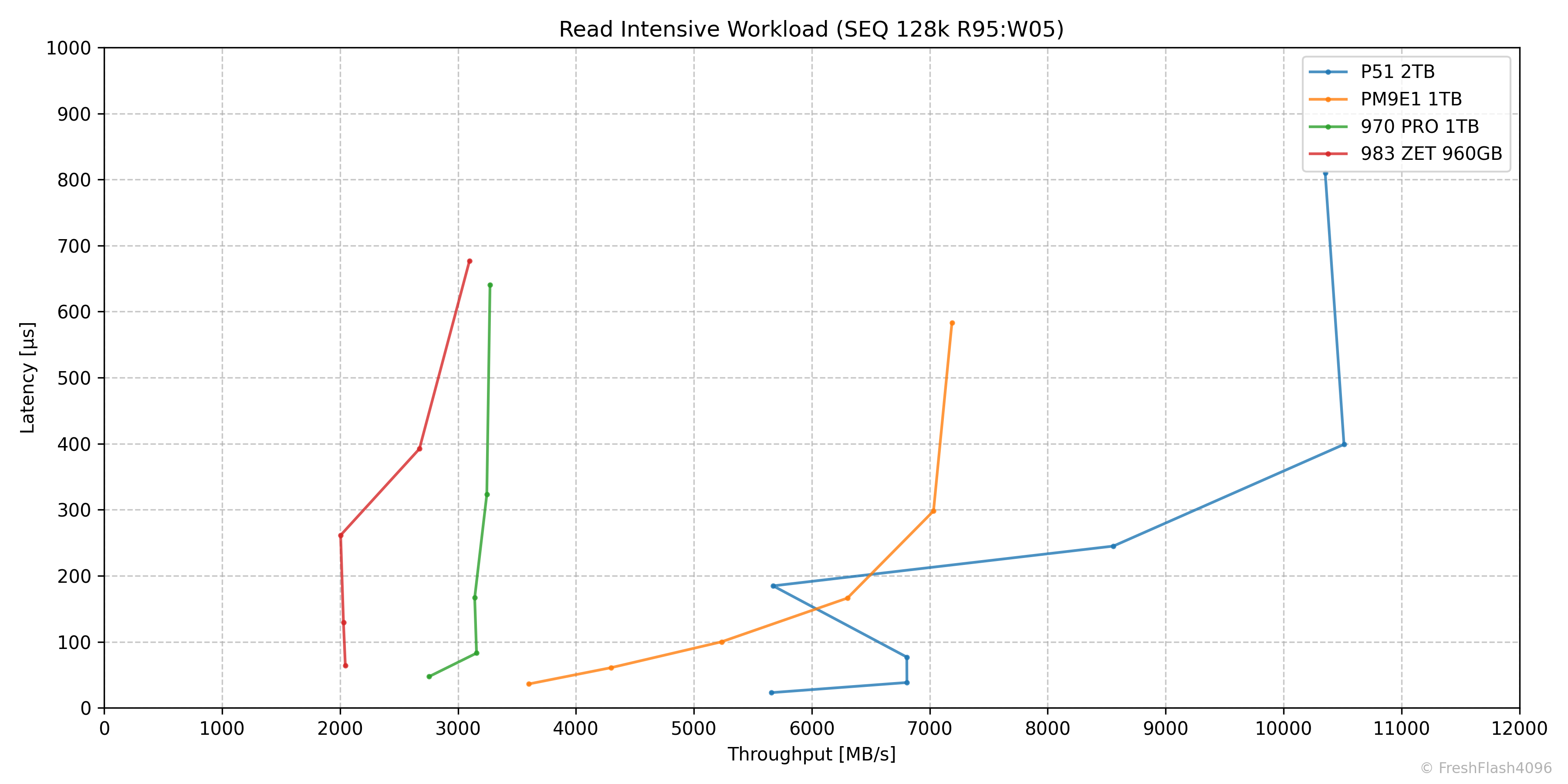

Read Intensive Workload (SEQ 128k R95:W05)

순차 읽기가 심하게 반영되어서 그런 것일까요, 마찬가지로 QD8에서 5672MB/s@185µs의 성능으로 이상한 포인트를 기록했습니다.

최대 성능은 QD32에서 10512MB/s@399µs였습니다.

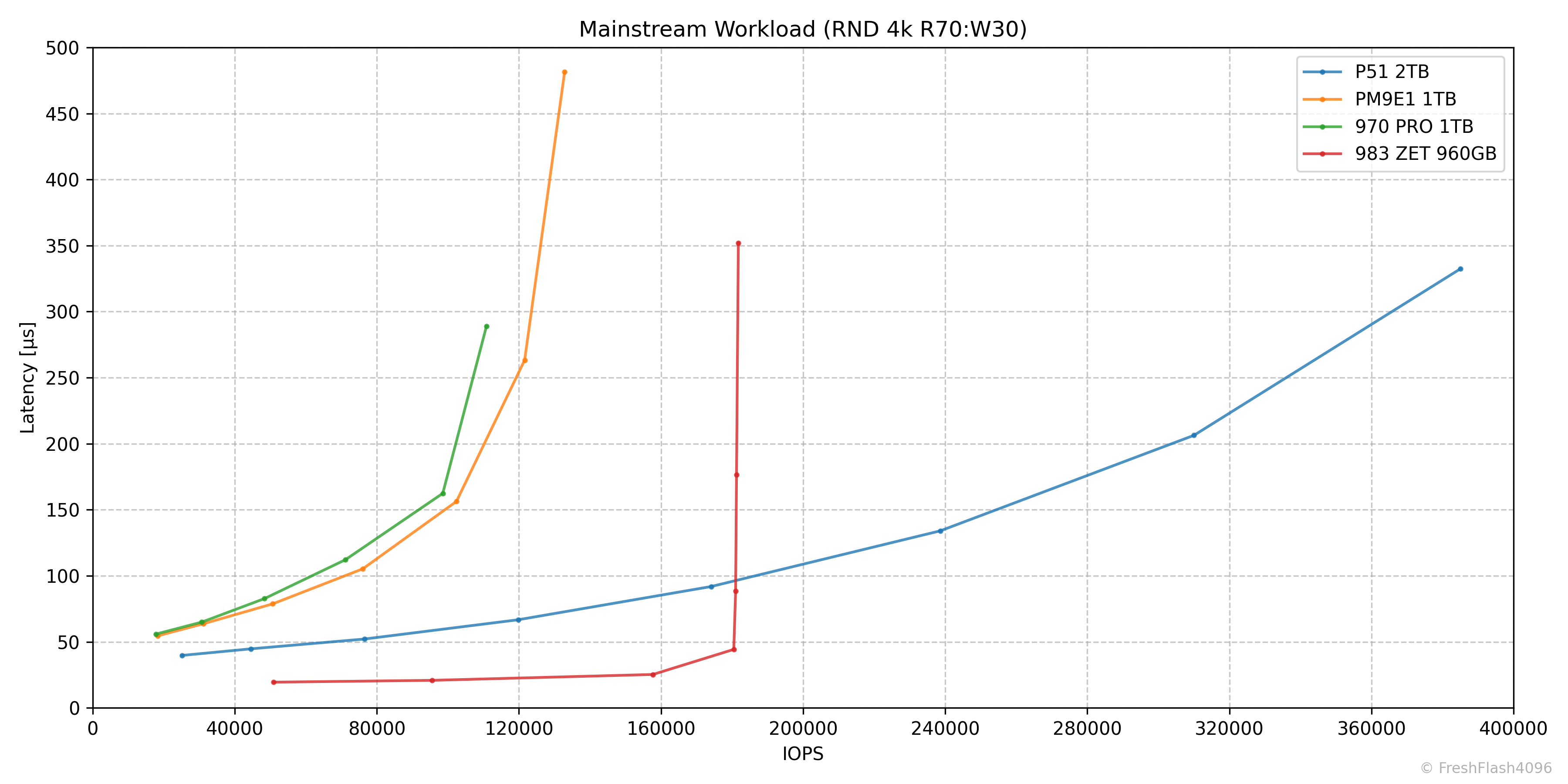

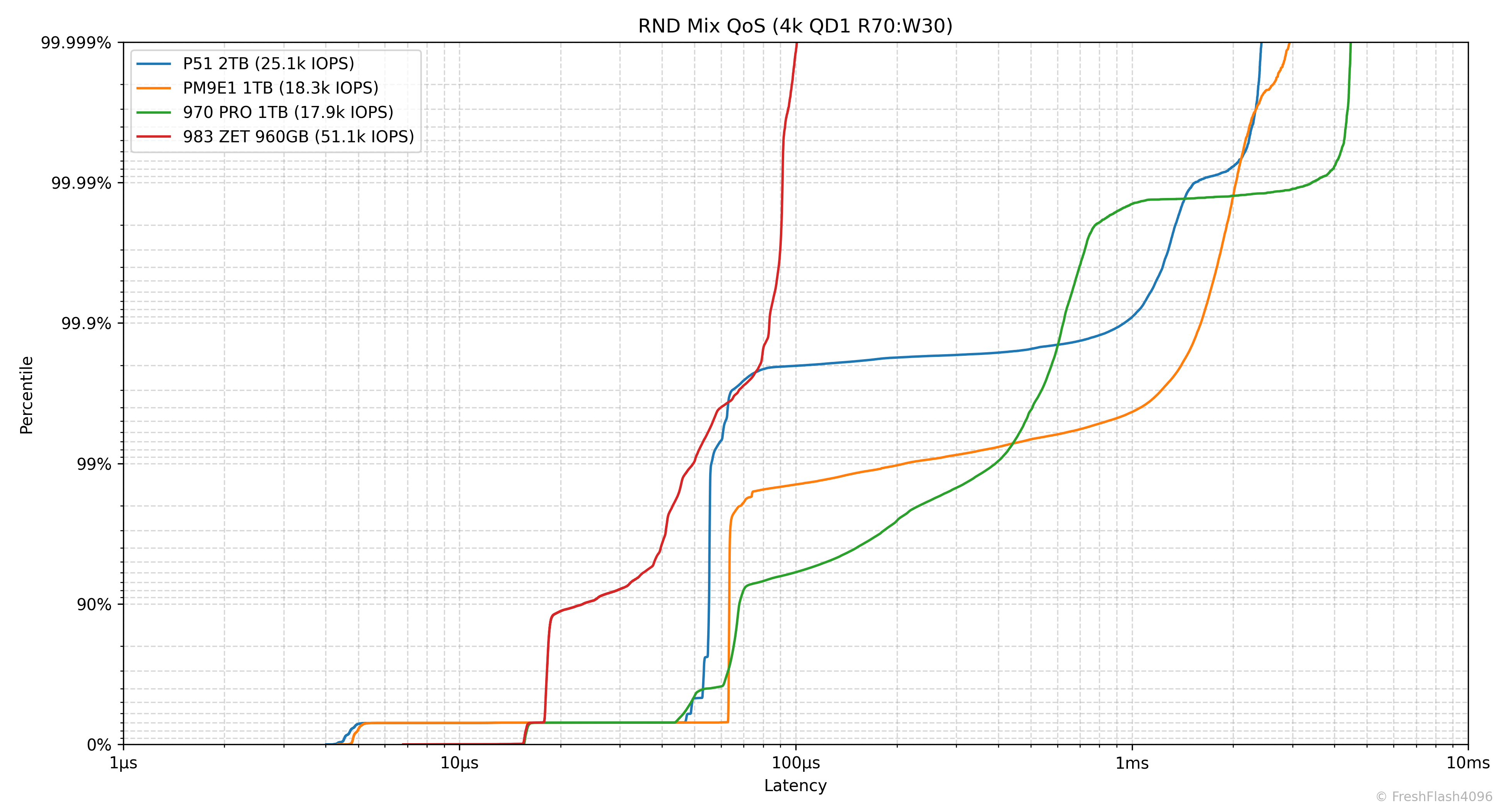

Mainstream Workload (RND 4k R70:W30)

QD128에서 385k IOIPS@332µs로 최대 성능을 기록하며, 983 ZET의 최대 성능을 넘겨주었습니다.

물론, 983 ZET는 낮은 QD에서 훨씬 더 우수한 성능을 보이기에 실제로 체감되는 QD 및 성능은 더 높을 것이며, 거기에 QD8에서 포화 상태라는 것을 감안해야 합니다.

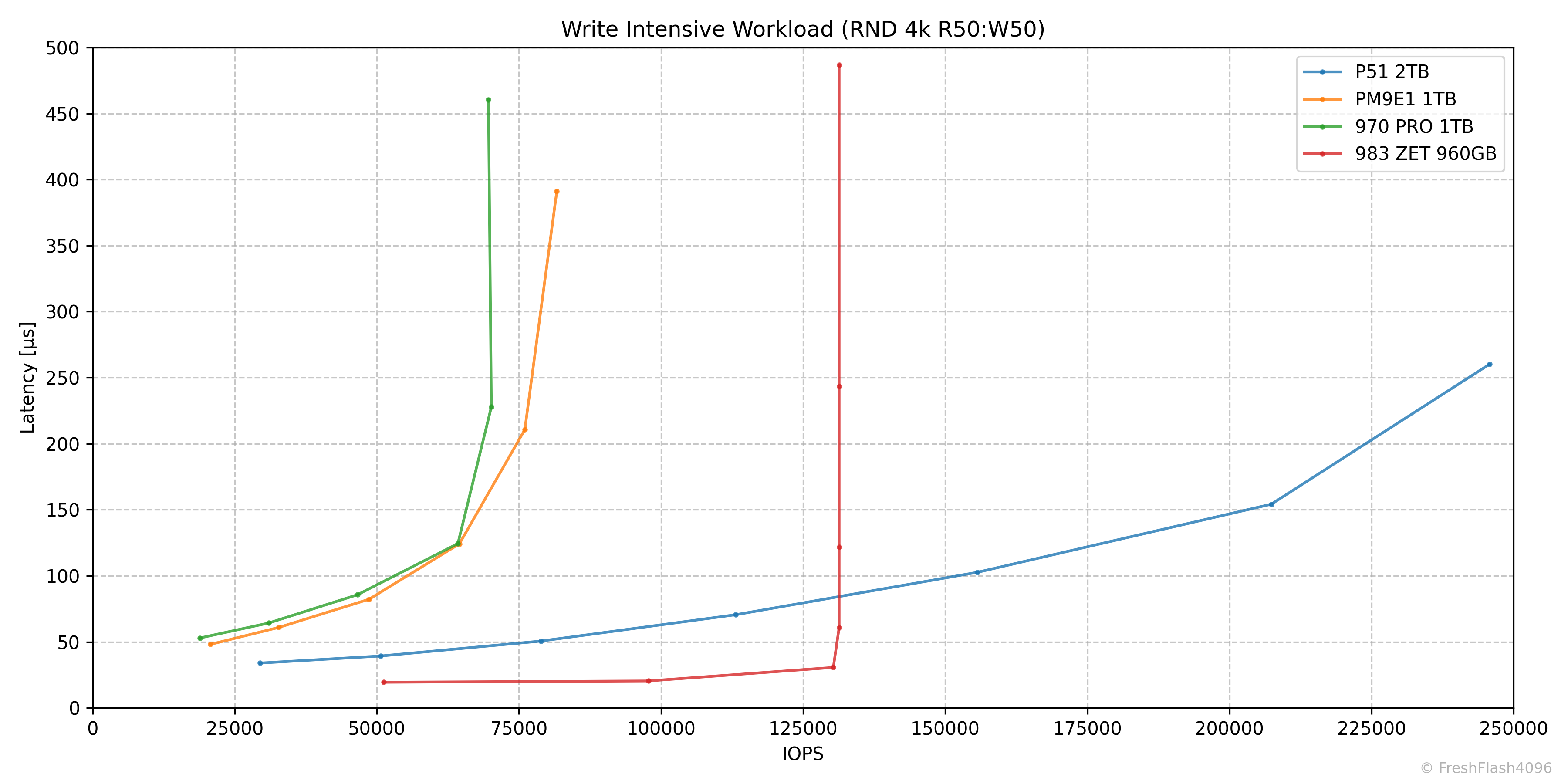

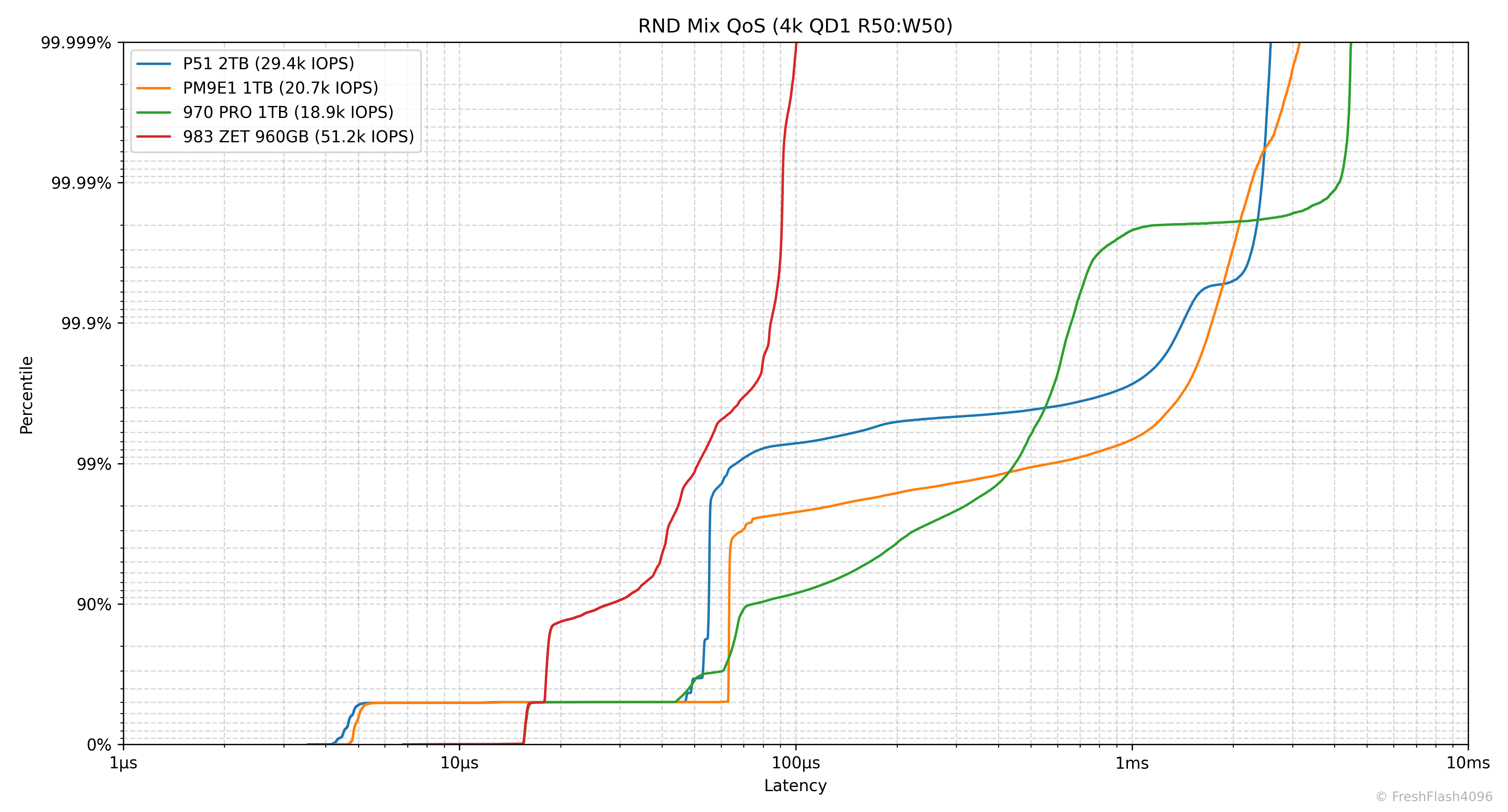

Write Intensive Workload (RND 4k R50:W50)

QD64에서 246k IOPS@260µs를 기록했습니다. 낮은 QD에서도 Mainstream workload처럼 비교군에 비해 우수한 모습을 보여주는 것을 확인할 수 있습니다.

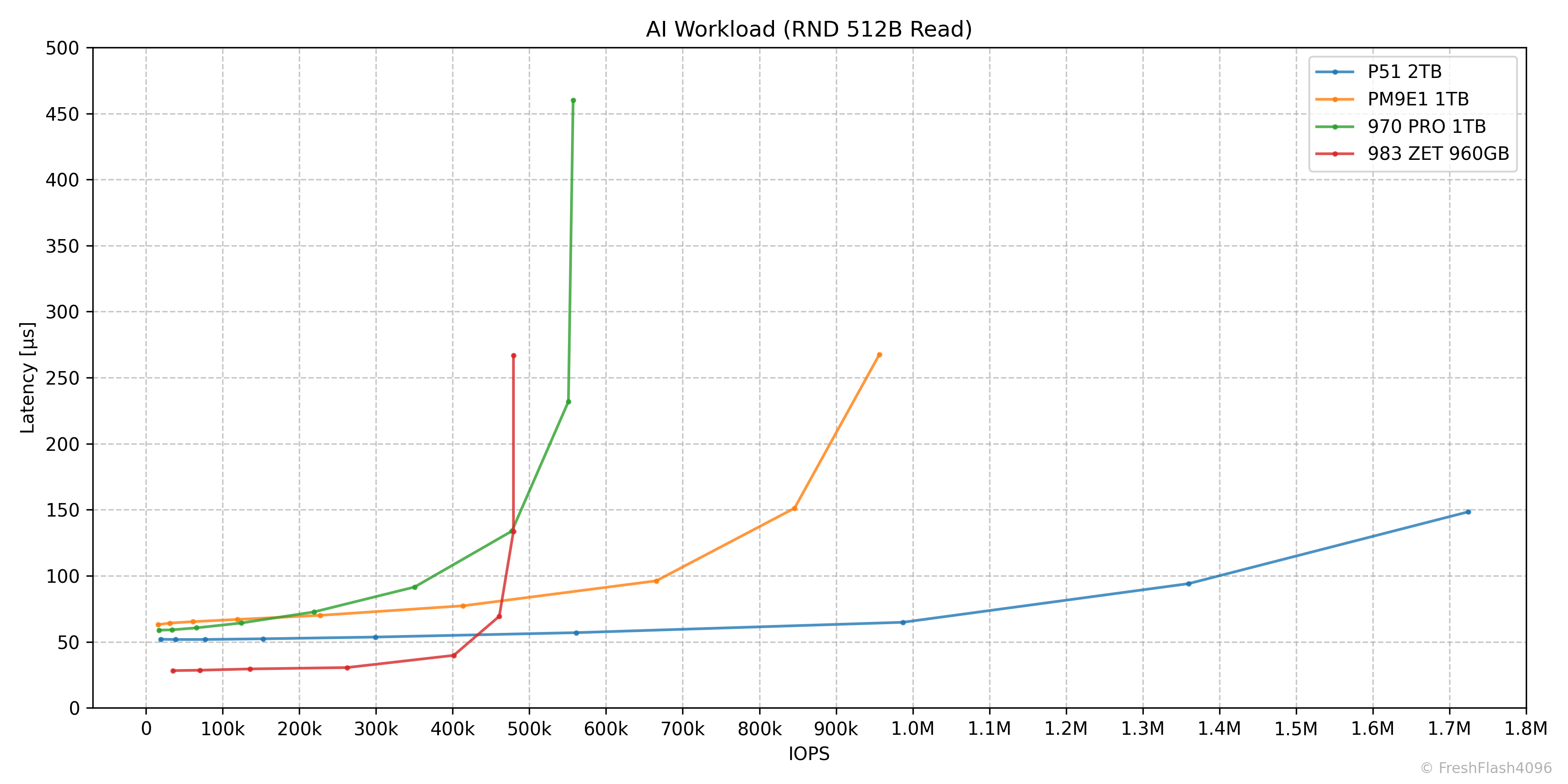

AI Workload (RND 512B Read)

4k 랜덤 읽기가 제공하는 최대 성능인 1715k IOPS와 크게 다르지 않게, QD256에서 1724k IOPS@148µs가 측정되었습니다. 그래프가 좀 다르게 보인다면, 983 ZET의 심각한 후퇴 때문입니다.

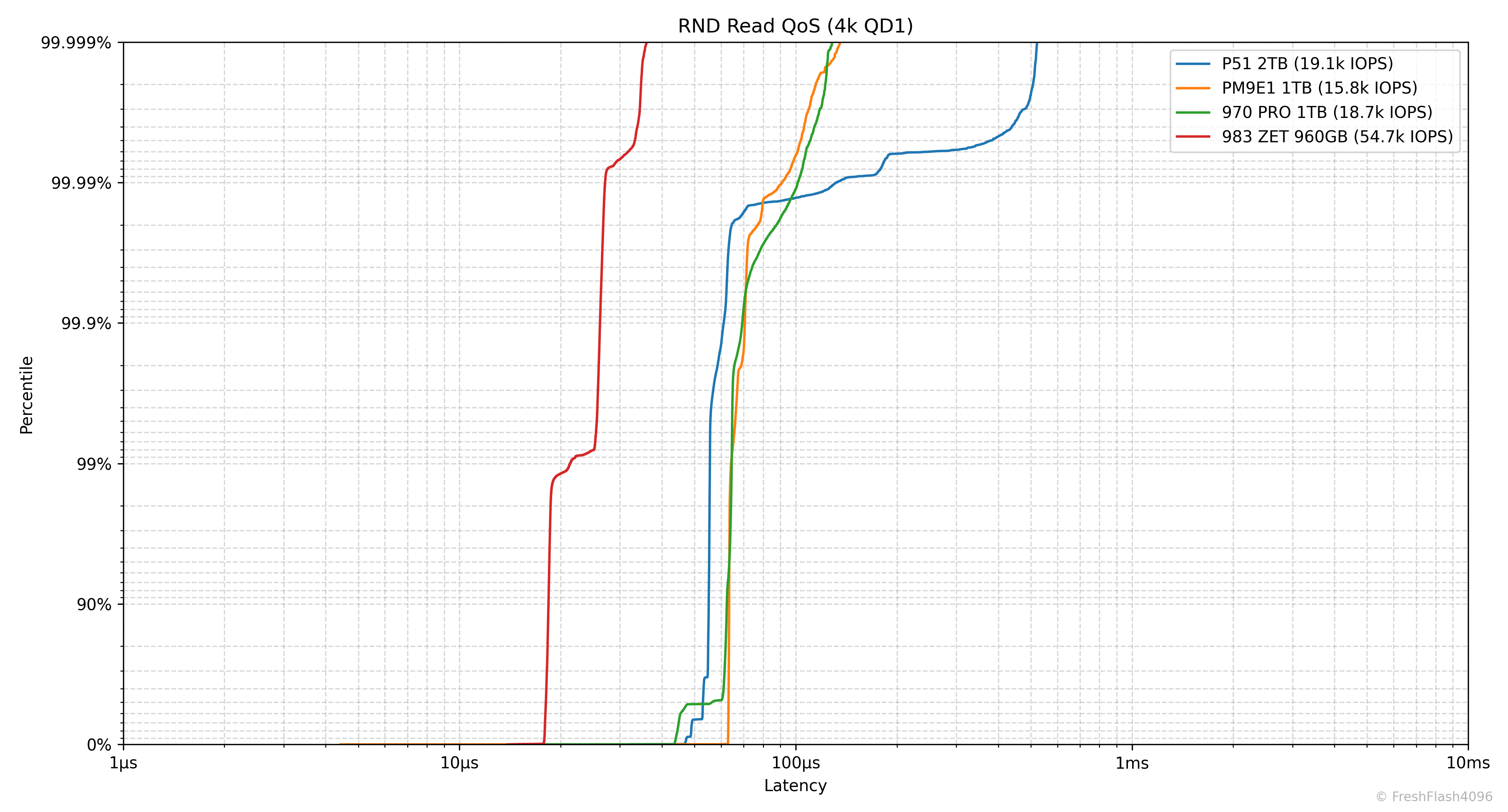

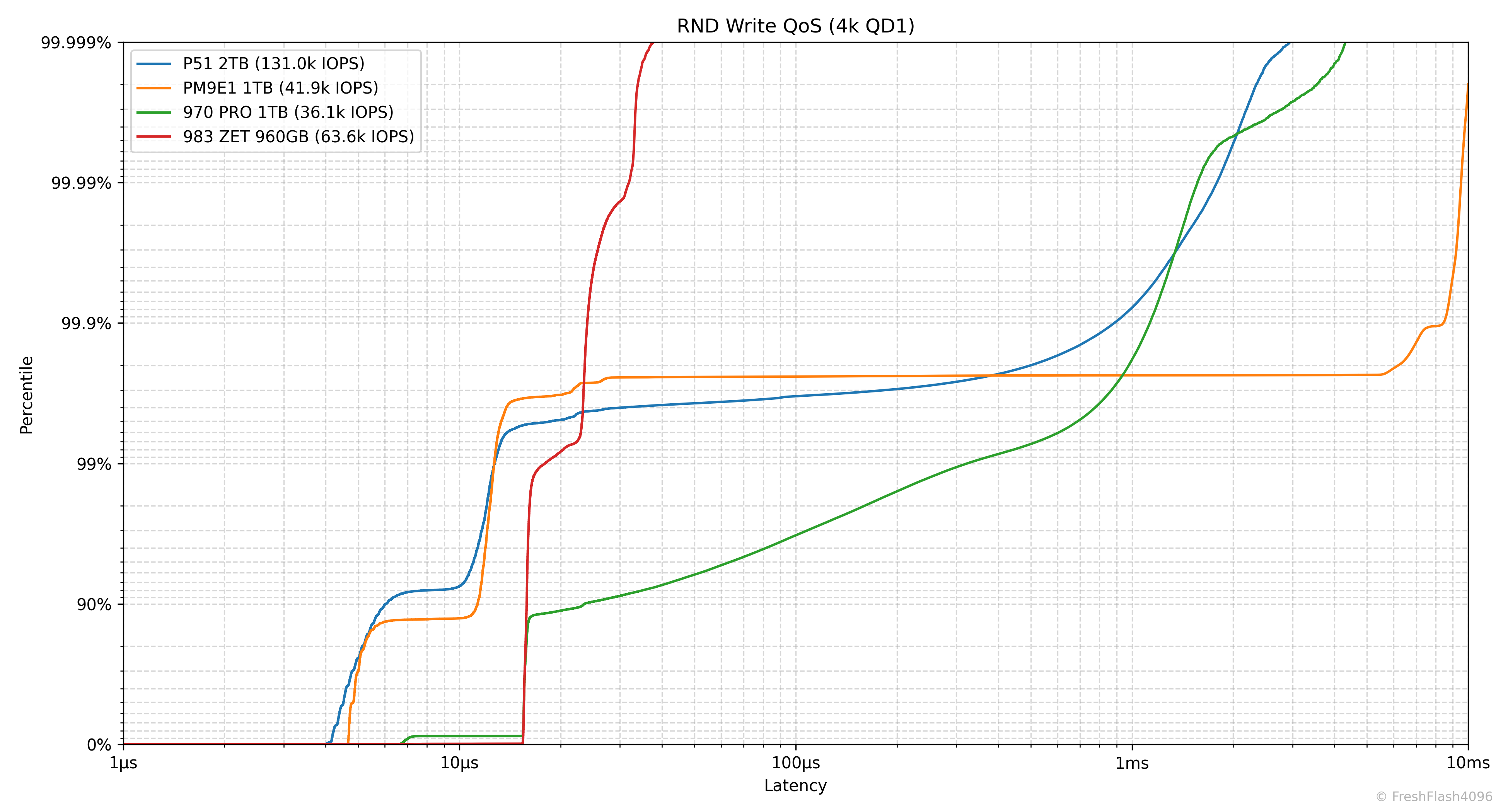

Random 4k QD1 Tail Latency

Latency에서 가장 느린 구간을 의미합니다. 그렇기 때문에 QoS(Quality of Service)에 큰 영향을 미치고, 실제로 eSSD의 데이터시트에서는 QoS를 명시하고 있습니다.

여기에선 100ms나 10ms 단위가 아닌, 모든 개별 I/O에 대한 지연시간을 카운트하여 그래프를 그립니다. 그렇기 때문에 데이터가 상당히 방대해, 이 항목은 RND 4k QD1에 대해서만 진행합니다.

983 ZET를 비교대상으로 넣으며 eSSD의 장점만을 부각하게 된 것 같습니다. 애초에, 이 벤치마크가 엔터프라이즈를 대상으로 하지만요.

올바른 경쟁 대상인 PM9E1과 비교하면, 읽기는 99.99% 이후로 일관성이 떨어지나, IOPS는 여전히 더 우수합니다. 쓰기는 PM9E1보다 지연시간이 잘 관리되는 것으로 보이네요. 그래봤자 99.99%에서 ms 단위이지만요. 하하핫

| RND Read | Datasheet | Benchmark Result |

| Typical Value [Burst, Polling] | 33 µs | 31.9 µs |

| Typical Value [Burst, IRQ] | 33 µs | 32.6 µs |

| Typical Value [Steady State] | - µs | 52.97 µs |

| QoS (99.999%) | - ms | 0.522 ms |

| RND Write | Datasheet | Benchmark Result |

| Typical Value [Burst, Polling] | 10 µs | 4.2 µs |

| Typical Value [Burst, IRQ] | 10 µs | 12.6 µs |

| Typical Value [Steady State] | - µs | 4.519 µs |

| QoS (99.999%) | - ms | 2.934 ms |

Steady State는 cSSD에서 전혀 고려되지 않는 부분이기에 그래프에는 나타나지 않았지만, Burst 성능도 표에 넣어보았습니다.

스펙시트의 읽쓰기 지연시간(33µs / 10µs)은 잘 지켜진 것으로 확인되었습니다.

Closing

P51은 테스트 타이밍이 굉장히 애매했습니다. 자취방을 잠깐 비워야 할 때 도착해서 급하게 테스트를 마무리하지 않으면 반납일이 일주일 이상 밀릴 위기가 있었거든요. 그런데, 생각보다 상당히 빠른 P51 덕분에 아슬아슬하게 방을 나서면서 P51을 택배로 부칠 수 있었습니다. cSSD라고 하기엔 상당히 우수한 Steady State를 보여주며, TLC에 직접 쓰는 속도도 우수하고 읽기 지연시간도 상당히 낮아 개인적으로는 상당히 마음에 들어버린 SSD입니다.

성능 측면에서 완벽을 말할 때 한 가지 아쉬운 점이 있다면, 3DMark와 SPECworkstation에서 PM9E1에 밀리는 부분일까요? 3DMark에서는 상세 항목에서 마지막의 게임 이동 부분이 4260MB/s 가량으로 측정되며, PM9E1보다 1300MB/s 정도 낮은 수치를 보였습니다. 나머지 부분은 크게 다르지 않은 결과를 보여, 해당 부분이 점수 차이를 만들어 낸 것으로 생각되네요. SPECworkstation에서의 점수 차이는 꽤 유의미했기에, 굳이 다시 보진 않겠습니다.

제가 가진 PM9E1이 2TB 모델이었다면 더욱 공정한 비교가 되었을 것이지만, P51을 고평가한 Steady State의 성능에선 결국 P51이 더 우수한 성능을 보여주지 않을까 짐작됩니다. 하이닉스의 V8 NAND의 성능이 상상 이상으로 보이거든요. 소비자에게 있어 P51의 단점을 꼽아보자면, 2TB 모델이 최대 용량인 부분일 것입니다. 경쟁 대상인 9100 PRO나 SN8100은 일단 8TB 모델까지 제공하니까요. 유사한 하드웨어를 기반으로 하는 eSSD인 PEB110이 최소 1.92TB SKU부터 시작하는 것을 생각하면, 여러 감정이 교차합니다.

이러니저러니, P51은 최신 플래그십 SSD답게 일반 소비자용 워크로드에서 우수한 성능을 제공합니다. 애초에, 많은 PCIe 5.0 플래그십 cSSD들은 구형 Optane SSD, Z-SSD과 유사하거나 더 우수한 성능을 보입니다. P51도 이들에 속하고 있으니 우수한 부분은 당연하게 생각해야겠죠.

하지만, Steady State는 다른 이야기입니다. 엔터프라이즈용 워크로드에서 이 정도의 성능을 보여줄 것이라고는 상상도 하지 못했거든요. OP가 더 주어진다면 어떤 모습을 보일지 기대하게 만드는 성능입니다.

그럼, 잠깐 쉬고 다음 리뷰를 작성해 보겠습니다. 2월 목표는 리뷰를 2개 더 투고하는 것입니다. 학교에서 리눅스 커널과 관련된 세미나에 참가하는 중이라 마감 기한을 준수할 수 있을지는 확신이 안 서는데, 취미니까 가볍게 하도록 하죠. 홈랩도 정비하면서 물건들을 처분해야 하는데 말이죠...

P51 2TB 제품을 대여해주신 조드의 애뽀 님께 이 리뷰로 감사 인사를 전합니다.

Comments